基于Mask R睠NN模型的葡萄藤關鍵結構分割方法

董婭蘭 胡國玉 劉廣 古麗巴哈爾·托乎提

摘要:剪枝點的精確識別與定位是實現葡萄藤冬季剪枝智能化的基礎,葡萄藤關鍵結構的分割是用于推理精確剪枝點的重要前提。針對現有分割方法受背景影響較大致使葡萄藤各關鍵結構損失和剪枝點識別與定位不準確的問題,提出一種基于Mask RCNN的葡萄藤關鍵結構分割方法,建立葡萄藤修剪模型以及各關鍵結構數據集。通過主干特征提取網絡和分割性能的對比試驗,得出最優的Mask RCNN模型結構并驗證其擬合與泛化能力以及在不同自然背景下的分割性能。結果表明,以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型具有較好的擬合與泛化能力,相較于對照組模型準確率分別提升7.33%和8.89%,召回率分別提升9.32%和9.26%,平均精度均值分別提升12.69%和12.63%,其能夠克服各類自然種植背景因素,分割目標邊緣完整,葡萄藤各關鍵結構之間連接關系正確。

關鍵詞:圖像分割;特征提取;葡萄藤;深度學習

中圖分類號:TP391

文獻標識碼:A

文章編號:20955553 (2024) 02020708

收稿日期:2022年8月12日 ?修回日期:2022年10月17日

基金項目:國家自然科學基金資助項目(12162031)

第一作者:董婭蘭,女,1999年生,甘肅隴南人,碩士研究生;研究方向為農牧機器人及智能農業裝備。Email: dongyalan122@163.com

通訊作者:胡國玉,女,1979年生,新疆烏魯木齊人,博士,副教授;研究方向為農牧機器人及智能農業裝備。Email: xjhuguoyu@xju.edu.cn

Segmentation method for grapevine critical structure based on Mask RCNN model

Dong Yalan, Hu Guoyu, Liu Guang, Gulbahar Tohti

(College of Mechanical Engineering, Xinjiang University, Urumqi, 830049, China)

Abstract:

The precise identification and positioning of pruning points is the basis for the intelligent pruning of grapevines in winter, the segmentation of the critical structure of the grapevine is an important prerequisite for reasoning about the precise pruning point. Aiming at the problem that the existing cutting method is greatly affected by the background, resulting in the loss of critical structures of the grapevine, and inaccurate identification and positioning of pruning points, a segmentation method of grapevine critical structure based on Mask RCNN was proposed, the grapevine pruning model and the critical structure data sets were established. Through the comparative experiment of backbone feature extraction network and segmentation performance, the optimal Mask RCNN model structure was obtained and its fitting and generalization ability and segmentation performance in different natural backgrounds were verified, The results showed that the Mask RCNN model with ResNet 101+FPN as the backbone feature extraction network proposed had better fitting and generalization ability, compared with the control group model, the accuracy rate was increased by 7.33% and 8.89%, the recall rate was increased by 9.32% and 9.26%, and the average precision was increased by 12.69% and 12.63% respectively, it could overcome various natural planting background factors, the edge of the segmentation target was complete, and the connection relationship between the critical structures of the grapevine was correct.

Keywords:

image processing; feature extraction; grapevine; deep learning

0 引言

冬季修剪是葡萄種植管理過程中一項重要的農藝環節,通過冬季修剪能夠合理分布生長枝與結果枝,阻止結果部位過快上移;調節單位面積上的芽眼負載量、結果母枝數量與長度,進而提高來年的葡萄產量與質量[1]。目前現有修剪機械多針對林果樹木,粗獷的修剪方式與機械無法滿足精細化的葡萄藤冬季修剪需求[2],因此葡萄冬季修剪主要依靠人工作業,其季節性勞動強度大、人工作業效率低,致使勞動成本投入增加。因此,開發自動化、智能化的葡萄修剪設備具有重要意義。

在葡萄栽培與種植過程中,機器視覺技術常被應用于葡萄串檢測、葡萄藤結構識別、病蟲害防治、產量與葉面積的估算[36]。針對葡萄冬季修剪作業,剪枝點的精確識別與定位可以保證來年葡萄保質增產,葡萄藤關鍵結構包括綁縛主干、枝條與節點,其各結構之間具有較強附屬性,并且相似性較大,各關鍵結構之間的連接關系是推理與定位葡萄藤冬季修剪點的關鍵。為此,國內外學者研究多集中于葡萄各關鍵結構的識別、芽點二維與三維位置的推理與識別以及智能裝備的開發。賈挺猛等[7]將骨架提取方法應用于葡萄藤各關鍵結構提取中,對比分析多種細化算法用于保證骨架具有良好的連通性與中心性,在此基礎上,Xu等[8]提出一種基于Rosenfeld細化算法和Harris算法結合的芽點檢測方法。Botterill等[9]設計了一種葡萄藤自動修剪機器人,通過三目攝像機重建形成完整的三維藤蔓模型,同時對機器人手臂進行高效的無碰撞路徑規劃,實現葡萄藤冬季修剪作業的自動化。Pérez[10]、Daz[11]等使用尺度不變特征變換來計算底層特征,利用支持向量機訓練分類器來檢測葡萄芽在三維空間中的位置。

由于芽點的大小與形狀存在差異、圖像采集多受光照與背景影響,傳統的圖像處理方式會導致在藤條細化過程中弱小芽點被忽略。深度學習是目前最先進的處理葡萄種植任務的方法,已經應用于葡萄藤修剪作業,如Marset等[12]提出了一種基于完全卷積網絡從葡萄藤圖像中完整分割出芽體形狀的語義分割網絡,用于識別突出芽體。Fernandes等[13]對葡萄藤圖像進行分割并創建葡萄藤植物代表模型,依據農藝規則推測潛在的修剪點。Yang等[14]提出一種基于細化算法和輕量級卷積神經網絡的二維葡萄冬季剪枝位置,訓練分類器查找芽眼并獲得冬季剪枝位置。由于國內葡萄種植環境較復雜,葡萄藤關鍵結構之間、關鍵結構與周圍環境之間都存在較大相似性,上述方式不適用于在國內復雜的種植背景下精確的葡萄藤關鍵結構識別以及葡萄藤冬季剪枝點推理以及定位作業。綜上,本文提出一種基于Mask RCNN的葡萄藤關鍵結構的分割方法,用以保證葡萄藤各關鍵結構的識別與連接關系,為進一步提高復雜環境下二維以及三維空間下芽點的識別與剪枝點的推理精度提供依據。

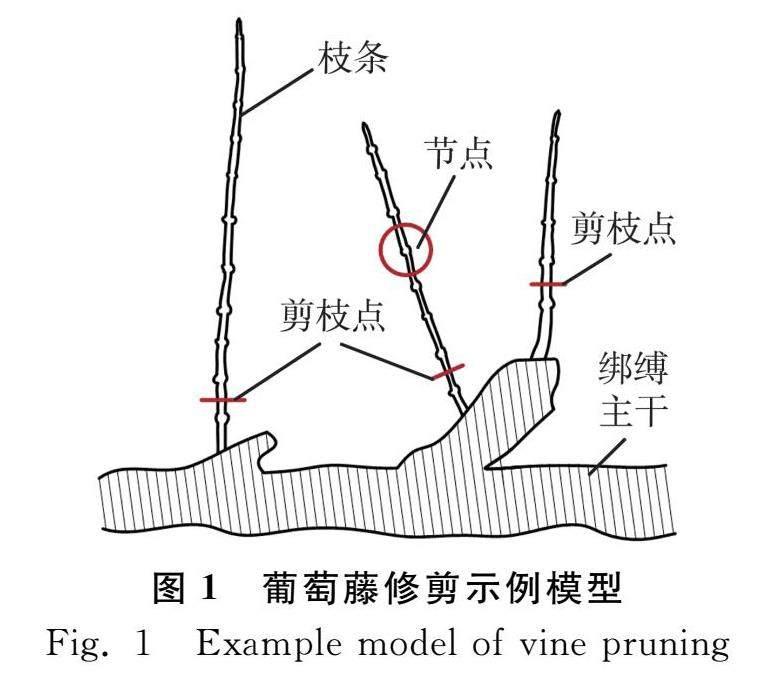

1 葡萄藤冬季修剪原理

為實現葡萄園種植過程機械化作業與產量增收,國內普遍采用“廠”形栽培模式,即保留植株單個主莖成為綁縛主枝,并呈“廠”形在第一條綁縛線上進行固定。枝條生長于綁縛主枝上,主要生長方向垂直于綁縛主枝。葡萄藤精細化的冬季剪枝農藝需求為:各枝條保留靠近綁縛主干的一至兩個芽點后,在保留芽點與上部芽點之間的枝條處做截斷處理。“廠”形栽培模式的葡萄藤修剪示例模型如圖1所示。葡萄藤各關鍵結構的識別與連接關系成為確定精確剪枝點的必要前提。

2 葡萄藤關鍵結構分割模型

2.1 Mask RCNN網絡模型

隨著深度學習分割方法逐步在農業工程領域的應用,目前已經在各項農業種植環節中成功實施[1517]。經典的圖像分割模型包括全連接卷積網絡(Fully Convolutional Networks,FCN)、DeepLab、PSPNet、Mask RCNN[1819],其中Mask RCNN可實現復雜背景下較高精度的像素分割,并且能夠并行實現目標檢測、分類以及像素分割問題。由于葡萄藤關鍵結構之間、關鍵結構與背景之間顏色相近,枝條叢生交錯、姿態多樣,傳統的閾值分割和邊緣分割[2021]方式難以實現葡萄藤關鍵結構與背景的準確識別以及分割,鑒于深度學習網絡同時具備的特征提取與識別的優勢,本文將基于Mask RCNN網絡框架,對葡萄藤關鍵結構進行分割識別,為推理精確的葡萄藤冬季剪枝點,實現自動化剪枝作業提供完整的修剪模型依據。其算法框架如圖2所示,實現步驟如下。

1) 通過由殘差網絡(Residual Network)和特征金字塔網絡(Feature Pyramid Network,FPN)組成的主干特征提取網絡對輸入的圖像進行多尺度的信息提取與融合,生成一系列有效特征層。

2) 在提取到的有效特征層上生成不同尺寸的感興趣區域(Region of Interest,ROI)后傳入區域選取網絡(Region Proposal Network,RPN),RPN將各尺寸的ROI進行初步篩選后對進行分類以及回歸操作,以獲得目標候選區域。

3) 通過ROI Align(Region of Interest Align)層將RPN網絡篩選出來的目標候選區域與主干特征提取網絡的有效特征圖進行匹配對齊,并統一特征圖大小。

4) 統一大小的特征圖將輸入由類別、邊界框以及掩膜分支構成的網絡頭部,用于輸出類別概率、定位的目標邊界框位置以及目標區域的掩膜分割。

2.2 圖像采集與標注

試驗數據于2021年10月13日10:00~21:00(天氣晴,光照強烈,自然種植環境)、10月14日(陰,光線較弱,自然種植環境)采集于新疆昌吉州瑪納斯縣中信國安葡萄酒合約種植地。采集對象為“廠”形種植的8年生赤霞珠釀酒葡萄,多方位進行拍攝,按照拍攝圖片的光照條件分為晴天順光、晴天逆光、陰天。共采集像素為3000×4000的圖片606張,將樣本圖片統一縮小至512像素×512像素,為防止數據集在訓練過程中產生過擬合,采用圖像與標簽同時進行水平翻轉與增減亮度的調整方式對數據集進行增廣,經過數據增強后,數據集總數為1818張,按照8∶1∶1的比例劃分訓練集、驗證集和測試集,數據增強后各類樣本數量與數據集劃分如表1所示。

葡萄藤各關鍵結構之間具有附屬性,合理的數據集標注有助于后期形成各組分連接關系與推斷準確的剪枝點位置。依據葡萄藤精細化的冬季剪枝農藝需求與規范的修剪示例,用labelme[22]圖像標注工具建立含有三類標簽的數據集,并為數據集圖像添加掩膜標簽,如圖3所示。

2.3 對照組網絡模型

DeepLab v3+和PSPNet作為經典的語義分割網絡,具有較好泛化能力和分割效果,因此本文將采用DeepLab v3+模型和PSPNet模型[2324]作為對照組模型對葡萄藤關鍵結構的分割性能進行對比試驗。

DeepLab v3+模型是近年來深度學習發展中分割精度偏高、使用較廣泛的目標分割模型。DeepLab v3+采用編碼-解碼結構,編碼結構主體使用帶有空洞卷積的深度卷積神經網絡與帶有空洞卷積的金字塔池化模塊,獲取不同尺度的感受野并進行多尺度的特征提取,DeepLab v3+模型在DeepLab v3的基礎上,引入解碼模塊實現底層特征與高層特征的融合,最后通過上采樣輸出預測結果。PSPNet模型主要由主干特征提取網絡與加強特征提取結構組成,其中加強特征提取網絡將獲取到的特征層劃分為不同大小的區域,并對各區域進行平均池化用以實現不同區域上下文信息的聚合,從而提高獲取全局信息的能力,特征融合進行上采樣后通過卷積層輸出目標物體的分割結果。對照組網絡模型均采用Labelme工具對數據進行標注,采用PASCAL VOC數據集格式進行訓練。

2.4 性能評價指標

采用COCO數據集評價標準對模型性能做出評估,其包括準確率P(Precision)、召回率R(Recall),平均精度AP(Average Precision):AP值可以對各給定類別準確率與召回率全面的表達與綜合體現;平均精度均值MAP(Mean Average Precision):MAP值可以滿足多標簽分類模型的評價任務;各評價指標計算公式如式(1)~式(4)所示。

P=TPTP+FP×100%

(1)

R=TPTP+FN×100%

(2)

AP=∫10P(R)dR×100%

(3)

MAP=1n∑ni=1AP×100%

(4)

式中:

TP——被模型預測為正的正樣本;

FP——被模型預測為正的負樣本;

FN——被模型預測為負的正樣本;

AP——

準確率在召回率上的積分,數值越高,模型性能越好;

MAP——每個類別AP值的平均值;

n——

類別個數,在本文中n=3(綁縛主干+枝條+節點)。

2.5 試驗設計

2.5.1 計算環境配置

本試驗主機配置Windows 10系統,中央處理器為Intel(R) Xeon(R) CPU E5-2680 v4 @ 2.40 GHz,顯卡為GeForce GTX 3090。各網絡模型在Anaconda 3虛擬環境下訓練,采用TensorflowGPU 1.13.2和Keras 2.1.5、TensorflowGPU 2.5.0深度學習框架來適應不同模型的網絡訓練需求。虛擬環境配置安裝Python 3.8編程環境、GPU并行計算架構Cuda 11.2和深度神經網絡GPU加速庫Cudnn 8.1。

2.5.2 計算環境配置

1) Mask RCNN模型參數設置:GPU個數1;單GPU同時處理圖片數量2;類別個數為1(背景)+3(綁縛藤條、枝條、節點),RPN錨大小為32、64、128、256、512;加載COCO數據集默認權重。為進一步提升目標圖像分割精度,采用將區域選取網絡和網絡頭部(分類、邊框回歸以及掩膜分支)合并起來的端到端的訓練模式,整個網絡訓練迭代數為100,初始學習率為0.001,網絡權重衰減系數為0.000 1,動量為 0.9。

2) 對照組模型參數設置:本文中對照組模型為DeepLab v3+與PSPNet網絡模型,均采用PASCAL VOC(PASCAL Visual Object Classes)數據集格式進行訓練,數據集圖片分辨率大小分別設置為512像素×512像素、473像素×473像素,整個網絡迭代數為100,總迭代次數為1 000,初始學習率為0.001,每迭代100次,學習率降低0.1。

2.5.3 對比試驗設計

1) 主干特征提取網絡對比試驗。

為使模型的識別與分割效果達到最佳,分別以ResNet 50+FPN、ResNet 101+FPN作為Mask RCNN的主干特征提取網絡進行訓練并進行對比驗證。通過訓練及驗證損失曲線是否收斂判斷模型泛化擬合能力與樣本的適用性;依據訓練后模型的平均精度AP值、訓練時間以及分割效果,選擇出最優的主干特征提取網絡。

2) 分割模型對比試驗。

在主干特征提取網絡對比試驗的基礎上選出Mask RCNN模型的最優主干后,與基于MobilNet v2主干特征提取網絡的DeepLab v3+和PSPNet模型進行分割模型性能對比試驗。通過訓練與驗證損失曲線收斂程度、收斂后損失值的保持數值判斷分割模型的擬合與泛化能力;對比各模型在葡萄藤關鍵結構圖片測試集上得到的準確率、召回率、平均精度均值以及分割效果,對比各類模型的分割性能。

3 結果與分析

3.1 主干特征提取網絡性能對比分析

將ResNet 50+FPN、ResNet 101+FPN分別作為主干特征提取網絡,對Mask RCNN模型進行訓練與驗證,試驗結果表明:兩種模型在訓練與驗證的迭代過程中,分類、邊框和掩膜的訓練集與驗證集的損失值整體呈現降低的趨勢,如圖4所示,兩個模型在100個epoch之內均達到收斂,收斂后3個模型整體訓練集損失值保持在(0.25,0.3)之間,整體驗證集損失率保持在(0.24,0.3)之間。從損失曲線的結果呈現,證明由兩種主干特征提取網絡構成的Mask RCNN分割模型具有較好的擬合與泛化能力,本數據集的構建也較符合用于葡萄藤關鍵結構的識別。

經過擬合泛化能力的確定,可知兩種主干特征提取網絡對模型以及圖像樣本有效可用,在此基礎上,需要通過對比其模型整體的性能來選擇最優的主干特征提取網絡。表2是兩種主干特征提取網絡的AP50(IoU取值為0.5)、AP75(IoU取值為0.75)、AP(IoU取值為0.5~0.95閾值下的平均值)以及訓練時間的對比。由數值可以看出,ResNet 101+FPN作為主干特征提取網絡具有較高的精準度,盡管網絡參數量是ResNet 50+FPN的1.4倍,但訓練時間僅多出0.462h;AP值相較于ResNet 50+FPN提升1.3%,識別精度提升對比顯著,極大程度上保證了葡萄藤關鍵結構的識別精度。

(a) 不同主干網絡訓練損失曲線

(b) 不同主干網絡驗證損失曲線

為驗證以ResNet 50+FPN、ResNet 101+FPN為主干特征提取網絡的分割性能,在測試集上對兩種模型分割性能進行對比試驗。由于葡萄藤各關鍵結構之間、關鍵結構與背景之間顏色都較為相近,為驗證模型對各背景的識別與分割效果,采用強、弱背景之分的圖片對模型進行性能檢測。利用兩種主干特征提取網絡對葡萄藤各關鍵結構的識別與分割效果如圖5所示。由圖5(b)與圖5(c)對比可知,以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型,在不同背景下對葡萄藤各關鍵結構的識別與分割整體優于ResNet 50+FPN。圖5(b)是以ResNet 50+FPN為主干特征提取網絡的Mask RCNN模型,其對于強背景區分的葡萄藤關鍵結構的分類與掩膜較差,對弱背景區分無法完成分類與掩膜任務。圖5(c)是以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型,對不同背景區分下的各類分割目標輪廓清晰,沒有出現目標像素點重復、遺漏標注的情況;對比強、弱背景區分對作物的分類與掩膜效果,其針對強背景區分的邊框回歸與分類效果更佳。通過對比兩種主干特征提取網絡的Mask RCNN模型,綜合考慮模型對于目標作物分類、邊框回歸、掩膜效果,訓練時間,模型整體參數量以及電腦配置,選取以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型,用于葡萄藤關鍵結構的分割模型對比試驗。

(a) 原圖

(b) 以ResNet 50+FPN為主干網絡的分割效果圖

(c) 以ResNet 101+FPN為主干網絡的分割效果圖

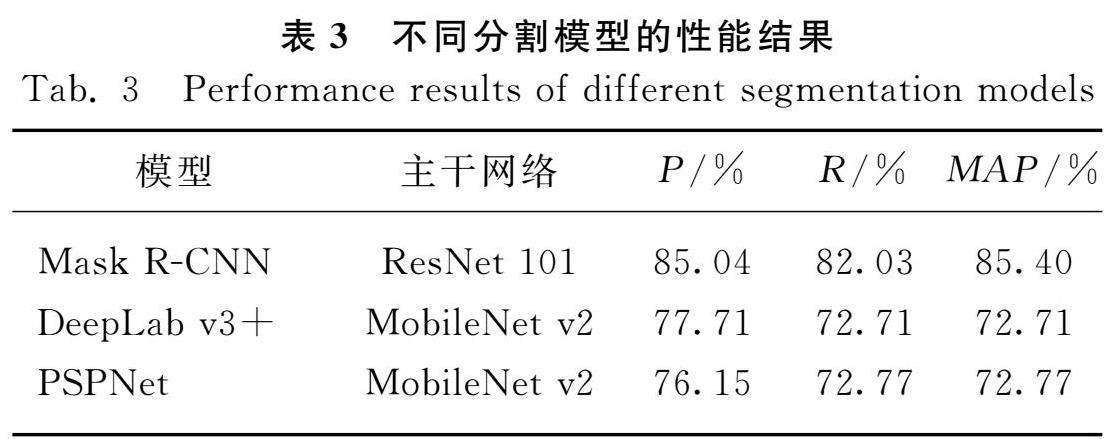

3.2 分割模型性能對比分析

在主干特征提取網絡對比試驗中,得出ResNet 101+FPN是Mask RCNN模型最優的主干特征提取網絡,為進一步驗證以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型對葡萄藤關鍵結構分割的分割性能,將其與以MobilNet v2為主干特征提取網絡的DeepLab v3+、PSPNet模型進行分割性能比較。采用相同數據集對兩類對比模型進行訓練與驗證,試驗結果表明:對照組兩種模型在訓練與驗證的迭代過程中,訓練集以及驗證集的損失值整體呈現降低的趨勢,見圖6,對照組兩種模型在100個epoch之內均達到收斂。PSPNet模型在訓練集上效果最佳,收斂后模型損失值保持在0.25以下;以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型在驗證集上效果最佳,收斂后在驗證集的損失值相較于PSPNet、DeepLab v3+模型低0.3左右。對比三類模型在訓練集與驗證集的訓練效果,得出以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型具有最優的擬合與泛化能力。

(a) 不同分割模型訓練損失曲線圖

(b) 不同分割模型驗證損失曲線圖

經過擬合泛化能力的確定,需要通過對比三類模型的分割性能來獲得最優的葡萄藤關鍵結構分割模型,以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型、以MobilNet v2為主干特征提取網絡的PSPNet、DeepLab v3+模型在測試集上對葡萄藤關鍵結構的分割試驗結果如表3所示。

由表3可知,以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型的各項結果均優與對照組模型,其相較于以MobilNet v2為主干特征提取網絡的PSPNet、DeepLab v3+模型對葡萄藤各關鍵結構的準確率分別提升7.33個和8.89個百分點,召回率分別提升9.32個和9.26個百分點,平均精度均值分別提升12.68個和12.63個百分點。試驗結果表明:采用以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型雖然網絡層數較深,模型參數量較大,致使網絡運行速度較慢,但綜合其優越的分割性能,針對葡萄藤關鍵結構的分割任務更具有魯棒性。

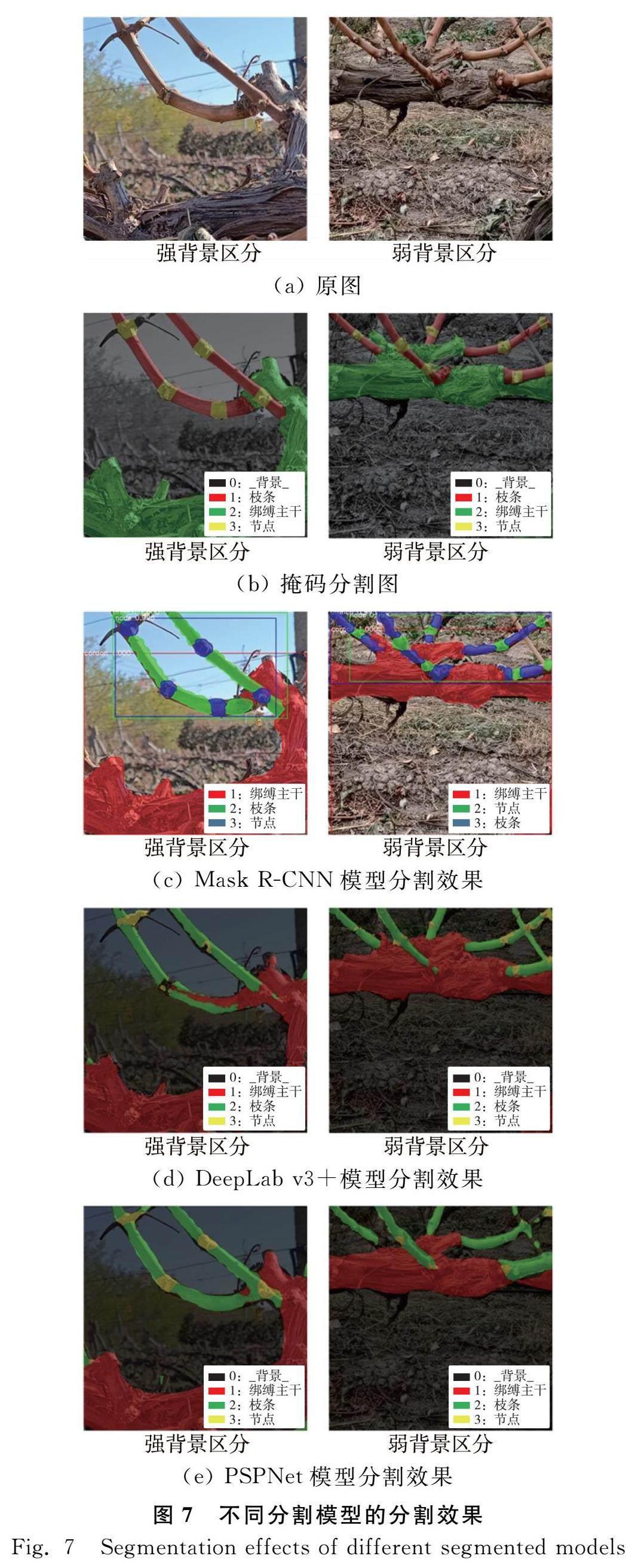

由于葡萄藤各關鍵結構之間、關鍵結構與土壤背景之間都存在較大相似度,需要模型具有目標作物與背景相似度較高的弱背景區分下識別與分割能力,因此采用強、弱背景區分兩類圖像對三類分割模型進行對比試驗,三類模型對葡萄藤關鍵結構在測試集上的分割效果如圖7所示。

(a) 原圖

(b) 掩碼分割圖

(c) Mask RCNN模型分割效果

(d) DeepLab v3+模型分割效果

(e) PSPNet模型分割效果

在強背景區分的圖像樣本中,綁縛主干、枝條、節點個數如標簽圖7(b)左所示分別為1、2、5個,以MobilNet v2為主干特征提取網絡的DeepLab v3+模型分割情況,如圖7(d)左所示,分割圖像出現將枝條像素錯誤分割為綁縛主干、綁縛主干與枝條之間形成錯誤間接關系、節點漏、錯分割比例占80%的情況;以MobilNet v2為主干特征提取網絡的PSPNet模型分割情況,如圖7(e)左所示,分割圖像存在枝條與枝條之間像素點粘連、節點邊緣分割不完整并且漏分割比例占20%的情況。對于弱背景區分的圖像樣本中,綁縛主干、枝條、節點個數如標簽圖7(b)右所示分別為2、5、8個,以MobilNet v2為主干特征提取網絡的DeepLab v3+模型分割情況,如圖7(d)右示,分割圖像綁縛主枝與枝條邊緣分割較完整,節點邊緣分割完整度較差,未完整分割的節點比例為87.5%,由于節點與節點之間距離較小,存在節點之間像素點粘連劃分形成錯誤連接關系的情況;以MobilNet v2為主干特征提取網絡的PSPNet模型分割情況,如圖7(e)右所示,枝條與節點分割邊緣完整性較差,節點沒有完整分割的個體。可見以MobilNet v2為主干特征提取網絡的DeepLab v3+、PSPNet模型受背景信息的影響較大,尤其在弱背景區分下,模型難以區分目標作物與背景的顏色與形狀特征,漏分割與誤分割現象嚴重。

對于試驗樣本,以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型展現出良好的分割性能,如圖7(c)所示,對三類分割目標分割輪廓完整,各分割目標之間的連接關系正確,樣本試驗分割正確率與整體掩碼程度達到100%。綜上,在不同背景與環境下以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型對葡萄藤各關鍵結構具有較好的分割性能。

4 結論

本文提出了基于Mask RCNN模型的葡萄藤關鍵結構的分割方法,并對模型的主干特征提取網絡進行對比選取、對模型分割性能進行對比驗證。

1) 進行以ResNet 50+FPN和ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型的對比試驗,經驗證,以ResNet 101+FPN為主干特征提取網絡的模型具有較好的擬合與泛化能力,對葡萄藤各關鍵結構的平均檢測精度為76%,相比以ResNet 50+FPN為主干特征提取網絡的模型AP0.5、AP0.75、AP分別提高了4%、4.6%與1.3%,表明其較優的目標檢測能力,并且在強、弱背景區分下其分割效果均優于ResNet 50+FPN主干特征提取網絡。

2) 在模型分割性能驗證上,采用以MobileNet v2主干特征提取網絡的DeepLab v3+和PSPNet模型進行分割模型為對照組進行對比試驗,經驗證,以ResNet 101+FPN為主干特征提取網絡的Mask RCNN模型相較于對照組兩類模型具有更好的擬合與泛化能力,相比于對照組模型準確率分別提升7.33%和8.89%,召回率分別提升9.32%和9.26%,平均精度均值分別提升12.69%和12.63%;在分割效果性能方面,相較于對照組模型在強、弱背景下的分割效果均優于對照組分割模型,分割邊緣完整,葡萄藤各關鍵結構之間連接關系正確。

3) 本文提出的基于Mask RCNN模型分割識別方法,初步實現了對葡萄藤各關鍵結構完整的識別與分割。雖然在識別與分割精度方面還有待優化,但與傳統圖像處理方式下的葡萄藤關鍵結構識別相比,保證了各關鍵結構的連接關系,并針對現有種植環境下,實現對自然種植背景的目標識別與分割任務,能夠為葡萄藤精確剪枝點的識別與定位研究提供精確的關鍵結構推理模型,為葡萄自動化、智能化的修剪作業奠定基礎。

參 考 文 獻

[1]金子煜, 劉淑紅, 周祥軍. 葡萄冬季修剪技術淺析[J]. 南方農業, 2021, 15(5): 30-31, 40.

[2]秦喜田, 劉學峰, 任冬梅, 等. 我國果園生產機械化現狀及其發展趨勢[J]. 農業裝備與車輛工程, 2019, 57(S1): 35-38.

Qin Xitian, Liu Xuefeng, Ren Dongmei, et al. Current situation and development prospect of orchard mechanization in China [J]. Agricultural Equipment & Vehicle Engineering, 2019, 57(S1): 35-38.

[3]劉平, 朱衍俊, 張同勛, 等. 自然環境下貼疊葡萄串的識別與圖像分割算法[J]. 農業工程學報, 2020, 36(6): 161-169.

Liu Ping, Zhu Yanjun, Zhang Tongxun, et al. Algorithm for recognition and image segmentation of overlapping grape cluster in natural environment [J]. Transactions of the Chinese Society of Agricultural Engineering, 2020, 36(6): 161-169.

[4]蘇仕芳, 喬焰, 饒元. 基于遷移學習的葡萄葉片病害識別及移動端應用[J]. 農業工程學報, 2021, 37(10): 127-134.

Su Shifang, Qiao Yan, Rao Yuan. Recognition of grape leaf diseases and mobile application based on transfer learning [J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(10): 127-134.

[5]Francesca C, Ermes M, Davide C, et al. Estimating leaf area index (LAI) in vineyards using the PocketLAI smartapp [J]. Sensors, 2016, 16(12): 2004.

[6]Fourie J, Bateman C, Hsiao J, et al. Towards automated grapevine pruning: Learning by example using recurrent graph neural networks [J]. International Journal of Intelligent Systems, 2021, 36(2): 715-735.

[7]賈挺猛, 荀一, 鮑官軍, 等. 基于機器視覺的葡萄樹枝骨架提取算法研究[J]. 機電工程, 2013, 30(4): 501-504.

Jia Tingmeng, Xun Yi, Bao Guanjun, et al. Skeleton extraction algorithm on grapevine based on machine vision [J]. Journal of Mechanical & Electrical Engineering, 2013, 30(4): 501-504.

[8]Xu S, Xun Y, Jia T, et al. Detection method for the buds on winter vines based on computer vision [C]. 2014 Seventh International Symposium on Computational Intelligence and Design. IEEE, 2014, 2: 44-48.

[9]Botterill T, Paulin S, Green R, et al. A robot system for pruning grapevines [J]. Journal of Field Robotics, 2017, 34(6): 1100-1122.

[10]Pérez D S, Bromberg F, Diaz C A. Image classification for detection of winter grapevine buds in natural conditions using scaleinvariant features transform, bag of features and support vector machines [J]. Computers and Electronics in Agriculture, 2017, 135: 81-95.

[11]Díaz C A, Pérez D S, Miatello H, et al. Grapevine buds detection and localization in 3D space based on structure from motion and 2D image classification [J]. Computers in Industry, 2018, 99: 303-312.

[12]Marset W V, Pérez D S, Díaz C A, et al. Towards practical 2D grapevine bud detection with fully convolutional networks [J]. Computers and Electronics in Agriculture, 2021, 182: 105947.

[13]Fernandes M, Scaldaferri A, Fiameni G, et al. Grapevine winter pruning automation: On potential pruning points detection through 2D plant modeling using grapevine segmentation [C]. 2021 IEEE 11th Annual International Conference on CYBER Technology in Automation, Control, and Intelligent Systems (CYBER). IEEE, 2021: 13-18.

[14]Yang Q, Yuan Y, Chen Y, et al. Method for detecting 2D grapevine winter pruning location based on thinning algorithm and lightweight convolutional neural network [J]. International Journal of Agricultural and Biological Engineering, 2022, 15(3): 177-183.

[15]傅隆生, 宋珍珍, Zhang Xin, 等. 深度學習方法在農業信息中的研究進展與應用現狀[J]. 中國農業大學學報, 2020, 25(2): 105-120.

Fu Longsheng, Song Zhenzhen, Zhang Xin, et al. Applications and research progress of deep learning in agriculture [J]. Journal of China Agricultural University, 2020, 25(2): 105-120.

[16]孫俊, 譚文軍, 毛罕平, 等. 基于改進卷積神經網絡的多種植物葉片病害識別[J]. 農業工程學報, 2017, 33(19): 209-215.

Sun Jun, Tan Wenjun, Mao Hanping, et al. Recognition of multiple plant leaf diseases based on improved convolutional neural network [J]. Transactions of the Chinese Society of Agricultural Engineering, 2017, 33(19): 209-215.

[17]龍潔花, 趙春江, 林森, 等. 改進Mask RCNN的溫室環境下不同成熟度番茄果實分割方法[J]. 農業工程學報, 2021, 37(18): 100-108.

Long Jiehua, Zhao Chunjiang, Lin Sen, et al. Segmentation method of the tomato fruits with different maturities under greenhouse environment based on improved Mask RCNN [J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(18): 100-108.

[18]Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651.

[19]He K, Gkioxari G, Dollár P, et al. Mask RCNN [C]. Proceedings of the IEEE International Conference on Computer Vision, 2017: 2961-2969.

[20]黃鵬, 鄭淇, 梁超. 圖像分割方法綜述[J]. 武漢大學學報(理學版), 2020, 66(6): 519-531.

Huang Peng, Zheng Qi, Liang Chao. Overview of image segmentation methods [J]. Journal of Wuhan University(Natural Science Edition), 2020, 66(6): 519-531.

[21]劉碩. 閾值分割技術發展現狀綜述[J]. 科技創新與應用, 2020(24): 129-130.

[22]Russell B C, Torralba A, Murphy K P, et al. LabelMe: A database and webbased tool for image annotation [J]. International Journal of Computer Vision, 2008, 77(1): 157-173.

[23]Chen L C, Zhu Y, Papandreou G, et al. Encoderdecoder with atrous separable convolution for semantic image segmentation [C]. Proceedings of the European Conference on Computer Vision (ECCV), 2018: 801-818.

[24]Zhao H, Shi J, Qi X, et al. Pyramid scene parsing network [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 2881-2890.