生成式人工智能視域下虛假信息的層級化運作機理與治理

【摘要】生成式人工智能在信息生產和傳播中的應用促使信息秩序發生變遷,極大地便利了虛假信息的生成與傳播。文章聚焦生成式人工智能視域下虛假信息的運行機理,主張對其實施層級化精準治理,即在創設層注重把關,以鏈式監測、分級管理的數據準入制度,共創新型把關進路,將虛假信息抑制在源頭;在撒播層注重研判,消除對話界面所置入的虛假信息落點,并對創設層中浮現的虛假信息進行信息標簽的顯性呈現與數字水印的隱性嵌入,將虛假信息困囚于對話界面之中,形成擴散阻礙;在流通層注重處置,消除虛假信息的可見性,優化算法對虛假信息的自動化決策過程,借助政府、媒體等公共力量,釋放真實透明的媒介信息,形成機動化的虛假信息遮蔽機制,強化信息治理效能。

【關鍵詞】生成式人工智能 虛假信息 信息治理 Sora

【中圖分類號】G206 【文獻標識碼】A 【文章編號】1003-6687(2024)8-075-09

【DOI】10.13786/j.cnki.cn14-1066/g2.2024.8.010

一、生成式人工智能視域下虛假信息對信息格局的深刻介入

互聯網是人類生成、交互和存儲信息的核心場域,媒介技術的深入發展使得線上與線下趨于融合、現實與虛擬交織纏繞,虛假信息在網絡場域中裂變生產、擴散傳播。與之相應,規制虛假信息的生產、傳播與消費成為全球信息治理的重要著力點。

當前,學界對虛假信息、誤導信息、謠言等異質性信息的概念界定較為混雜,本文出于論述簡便性,不做復雜辨析,均使用“虛假信息”概念展開探究。虛假信息是信息的否定形式,意味著“信息完整性的斷裂”,[1]從生成式人工智能論域下進行觀照,虛假信息包含技術性、導向性、建構性三個層面的完整意義,即在技術性層面,虛假信息由數據與算法架構而生,在組合信息真實性的過程中出現技術性斷裂;在導向性層面,虛假信息的文本意義導向錯誤的現實與偏誤的認知;在建構性層面,信息與真實間建構起錯誤的聯系導致虛假性生發,錯誤的建構割裂了虛假信息的意義真實性。

當生成式人工智能深嵌于智能傳播格局之中,互聯網信息秩序在技術促動下發生巨大轉向,對信息傳播全過程產生顛覆性影響,[2]對于生成式人工智能行為意義的探賾成為智能傳播時代傳播學研究的新問題。與之相應,虛假信息的傳播面向呈現出新情境——虛假信息的生成傳播主體由以真實人類用戶為主導者轉向智能技術深度介入下的行動者,機器由媒介而升格為重要傳播者,人工信息的生產與分發在生成式人工智能浪潮下徹底失去支配地位。

有學者將生成式人工智能引發的虛假信息風險分為積極生成型風險、消極生成型風險和人為操縱型風險三種,認為生成式人工智能引發虛假信息危害的因素極為復雜。[3]生成式人工智能在技術性層面會將偏見認知與經驗隱入數據集和數據獎勵模型之中,具有引導使用者將虛假、錯誤甚至帶有隱性價值偏向的信息視為客觀真實信息的能力。同時,生成式人工智能的高技術生產使得虛假信息的生成內容、數量與傳播效率都超越了以往任何一種信息產播模式。不論是語言處理模型還是圖像生成模型,生成式人工智能均以語言文本、圖像、視頻等內容為基質創造新信息,任何用戶都能極其方便地參與到生成式人工智能輔助下的內容生產中,在此過程中可能成為海量虛假信息的制造者與輔助者。可見,由生成式人工智能所生成的虛假信息已迥異于以往任何一種虛假信息形態,具有了特殊的信息形態分野。

有鑒于此,本文對生成式人工智能虛假信息作出如下界定:經由生成式人工智能大模型生產的,文本真實性遭到技術性操縱并對社會公序具有危害性的信息。生成式人工智能生產虛假信息的速度遠超法律法規與道德規范的完善速度,多元主體信息權利邊界已難以界定,信息失范行為的生發風險呈指數級增加。智能技術尤其是2024年年初出現的Sora,其對視覺場景的超高逼真模擬,使得虛假信息愈加難以辨別,可能比事實本身更為逼真,且更符合公眾的情感價值判斷,促逼公眾逐漸習慣沒有確定性的生存方式,解構社會的真相共識與機制。學界目前對于生成式人工智能虛假信息問題的探討主要集中在內容特征、風險誘因、技術邏輯、科技倫理等方面,且主要放置于生成式人工智能信息格局中進行局部關切。盡管有的研究提出了相關措施建議,但并未將治理問題與生成傳播的現象聯系起來,缺乏精確化、層級化遏制生成式人工智能虛假信息的目標導向,對虛假信息生產、傳播與接收的全過程缺乏針對性、系統性分析。基于此,本文對生成式人工智能視域下虛假信息的源發與傳播的全過程進行探賾,明晰每一階段發揮作用的行動主體與信息運作的邏輯機理,并對生成式人工智能虛假信息的治理路徑與范式作出思考。

二、生成式人工智能視域下虛假信息的層級化運作機理

生成式人工智能的技術革新喻示著技術物的自主性不斷增強,作為機器技術的生成式人工智能與人類社會的互動需要得到新的理論關切。1994年,克利夫·納斯等人結合心理學與社會學研究方法,通過實驗證明了人對計算機的社會化反應,提出“計算機為社會行動者”(CASA)范式,證明了人與計算機的交互本質上是社會性的,“個體對于計算機的社會性反應非常普遍,而且是自發的、下意識的”。[4]1996年,納斯與李維斯將CASA范式納入《媒體等同》一書中,指出媒體與現實生活等同,媒體會被視為現實生活中的人和場所,人與新媒體的互動與現實生活一致,是社會的、自然的,該觀點被總結為媒體等同理論。[5]四年后,納斯等從心理學角度繼續推進媒體等同理論的研究,將計算機被視為社會行動者的現象納入無意識行為的范疇。

社會行動者概念源于社會學,意指在能動性前提下從事社會行動的人,在媒介環境學派的媒介觀與社會學的雙重影響下,媒體等同理論中的CASA范式將計算機視為社會行動者。[6]本文并不探討媒體等同理論與CASA范式的得失,而是因其在當今仍具有“較高的理論解釋力與啟發性”,[4]故將其納入生成式人工智能同人類個體和社會的信息互動視野中。生成式人工智能在數據與算法的加持下,深度介入當今的信息秩序與傳播格局中,并具備了與人類進行社會性互動的可能。因此,生成式人工智能應被視為社會行動者之一,在虛假信息的創設、撒播與流通的全層級中發揮主體作用。

1. 創設層:生成式人工智能虛假信息的產生

創設層是生成式人工智能視域下虛假信息傳播全過程的第一個層級,是虛假信息得以產生的基底。創設意為開創條件,對于虛假信息的產生機制,本文在此不使用“生成”等更具鮮明意義的詞匯,而是使用“創設”一詞,指虛假信息的產生層級,意即說明在生成式人工智能的新技術語境下,開創的一種虛假信息的全新生成模式和全新生產條件,虛假信息生成的速度與形態都在彰顯創設性。

媒介和人類社會的歷史進程有著密切的關系,二者相互融合,彼此借勢。在人類的信息傳播史中,存在著多種創設媒介,促成了人類信息傳播的革命性跨越。口語媒介開創了人際傳播的新格局,文字媒介使傳播得以在時間性中無限延展,互聯網媒介使得信息傳播的損耗度大幅降低,而信息文本的存儲容量與傳播外延卻大幅增加,創設了網絡傳播的新時代。平臺型媒介的出現使信息內容生產實現了從以專業生產(PGC)為主到用戶生產(UGC)為主的革命性轉變。隨著生成式人工智能的演進,人工智能在信息傳播中對人類完成全過程替代,創設出以新智能媒介為基礎的智能傳播格局,帶來文本、圖像、音視頻等內容生成的信息革命,將信息生產轉向人工智能內容生成(AIGC)的全新秩序。

創設層中的社會行動者包括用戶以及在CASA范式下具備主體性和社會性的生成式人工智能。生成式人工智能可以分解為多個行動要素,即通用大模型與數據界面,二者和用戶共同構成創設層的社會行動者。通用大模型是生成式人工智能信息生產的“心臟”。目前,多數生成式人工智能采用大規模生成式預訓練語言模型(Generative Language Model,GLM)作為生成邏輯。作為一種自然語言處理技術,大規模生成式預訓練語言模型能夠通過大規模的文本數據進行自監督學習,使模型學習到語言的潛在結構、語法規則和語義關系,將語言由靜態表示升格為上下文感知的動態表示,使自身具備情景化生成能力,即能夠根據上下文提示生成信息。通用大模型的塑造通常需要經過三個階段:第一階段是大模型訓練,使大模型學習人類的語料文本,使其中的數據蘊含參數化、概率化;第二階段是指令學習,使大模型具備完成任務的能力,能夠根據指示進行信息的運算輸出;第三階段是價值觀念的習得,養成價值判斷與價值對齊的能力。生成式人工智能需要通過通用大模型才能生成信息,因此大模型在虛假信息創設層中處于核心的行動者位置,其能夠將源數據進行情景化生成,通過自身內置的深度學習能力,在某種價值判斷取向下賦予信息虛假性。即使源數據并非虛假數據,但通用大模型本身并不具備辨別能力,因此可能會在數據文本嫁接拼合的過程中將真實信息糅合并消解本身的整體真實意義;創設層中所提取的數據多有時間限制,可能導致生成式人工智能的內容生產無法與人類語料同步更新,由此導致信息嚴謹性缺失,[7]損害文本的真實性。

由上文可知,在信息生產方面,生成式人工智能主要以自然語言處理為核心機制,以轉換器為通用模塊/接口,將外界數據吸收至模型中不斷訓練,以此進行深度學習,進而具備輸出信息的能力。而全新的視頻生成模型Sora更是在轉換器架構的基礎上升維為具備多維度采樣能力的擴散轉換器,使其能夠依托數據與算法生成長時間且高逼真的視覺影像。生成式人工智能信息生產的原始材料是網絡空間存有的各類數據,通用大模型創設作用的發揮需要依靠這些源數據,而源數據的提供者則是活躍于網絡空間的各類用戶與群體,他們創造或上傳的信息內容都有可能被納入生成式人工智能的訓練體系。這些用以訓練的數據并非以碎片化、零散化的形式置入訓練結構之中,而是以界面的形式實施整體化置入與學習。在傳播學意義上,界面是內容得以呈現的平面,始終貫穿于傳播過程和主體的傳播實踐之中。[8]界面是一個技術、社會與文化過程高度相關的交匯處,創造出行動主體與環境之間的一種特殊的參與方式。[9]界面既存有外在物理時空,又存有內在意義時空,能夠通過創建場景實現主客體間的深度交互。[10]

從這個意義上來說,生成式人工智能內置的語言模型與外界海量的數據間存在一種數據界面。通用大模型的信息生成有賴于各種分散于網絡空間的數據對模型本身施加的單向傳播,即將自身所蘊含的參數、文本與知識結構單向“飼喂”于模型內供其學習感知。在此過程中,分散的數據會首先被后臺技術整合創設為一個統一的數據界面,再傳導至大模型中進行信息生成。這是因為大模型的信息生成需要調動后臺內置的海量數據,需要共時性而非歷時性地擷取數據進行感知輸出,對數據界面上的各種數據進行編碼,按照自身技術邏輯生成信息內容。質言之,數據界面就是對分布于網絡場域內的各種蘊含社會認知與文化意義的數據集進行整合的場景,為通用大模型與外界數據環境構建了便捷交互的橋梁。在此過程中,如果通用大模型在數據界面中“吞咽”了虛假數據,或者被具有擾亂社會信息真實目的的用戶或訓練人員在數據界面以虛假數據“喂養”,就會在自身技術邏輯和價值觀念的推導下生成虛假信息,阻滯真實信息的傳遞。

由此可見,創設層中的社會行動者(通用大模型、數據界面與用戶)會通過虛假數據界面置入、錯誤技術邏輯轉譯、真實信息虛假編碼等方式生成虛假信息,以生成式人工智能為代表的一系列通用人工智能技術(AGI),如PaLM-E等具身多模態語言模型和Sora等視頻生成模型,使創設虛假信息生產全面AGI化,將信息秩序帶入全新的智能治理圖景中。

2. 撒播層:生成式人工智能虛假信息的顯現

當前,學界對生成式人工智能的信息生成機制的分析通常基于“數據收集—信息制造—內容傳播”的邏輯,即強調“創設—流通”的順承關系。然而,這種看法忽視了邏輯的中介性,也就是在創設層與流通層之間存有一個信息轉換的重要樞紐,即生成式人工智能對用戶主體的信息撒播。

彼得斯在《對空言說:傳播的觀念史》中提出的兩種傳播模式成為理解生成式人工智能視域下虛假信息撒播層機理的重要方式。第一種是交流傳播模式,以交流為媒介進行雙向交互傳播,交流主體以對話的形式抵達靈魂的交融與真理的同一。第二種是撒播傳播模式,該模式不區分傳播對象,也不在乎傳播對象是否能夠成功理解傳播內容,而追求通過單向度的傳播使受眾聆聽和領悟“圣言”,是一種單向的、不平等的媒介傳播。[11]

在生成式人工智能使用中,人們往往會忽視撒播的存在,這主要是因為生成式人工智能語境下的人機互動具有一定的迷惑性。人機互動的過程看似用戶在通過對話界面與生成式人工智能進行平等對話,踐行交流傳播模式。但實際上,生成式人工智能對創設層所生成信息的傳播是撒播的,用戶所得到的回復不過是生成式人工智能對此前眾多相同或相似問題進行運算所得出的“經驗”,[2]用戶所期望的同聲相應的人機交流亦不可能在生成式人工智能的技術邏輯下實現。生成式人工智能依然占據著人機互動的高位,看似讓渡了交流的權利,其實仍隱蔽地向用戶主體施加著技術權威,粗暴地通過撒播的方式回應用戶的話語或指令,通過麻痹用戶來實現創設層信息的撒播與注入。

在撒播層的連接過程中,主要的社會行動者是對話界面與用戶間的二元關系,虛假信息可通過對話界面進入眾多用戶的認知結構中。列夫·馬諾維奇認為,人與機器之間的界面是一種“發展出自身組織信息、向用戶展示信息、將空間和時間聯系起來、在獲取信息的過程中構建人類經驗的獨特方式”。[12]當通用大模型運用數據界面的數據生成信息后,即會通過對話界面向用戶呈現所生成的信息。在用戶的視角下,與生成式人工智能進行互動的對話界面能夠“通過模擬現實交往、實時生成的方式,從系統中任意調取出千變萬化的‘現實圖景’和‘虛擬圖景’,直接接入人們的觀念世界”,[10]但實質上,對話界面只是媒介,交流式傳播只是表象,本質仍是通用大模型通過數據界面習得的價值觀念與用戶的認知結構發生作用并進行撒播。與之相應,用戶也可將對話界面中用戶的指令性內容進行解碼與轉譯并傳導至通用大模型,大模型即會調用數據界面來生成信息文本并再次經過轉譯后置入對話界面,實現同用戶的信息交互。

由此可見,生成式人工智能的撒播層具有超越性,超越了彼得斯的撒播范式。彼得斯認為,傳播者如果完全不考慮受眾的差別而進行單向的撒播,對用戶如何解碼以及其交流期望能否得到滿足并不在意,則很難達到良好的傳播效果。然而,生成式人工智能的撒播卻以用戶的主動提問為前提,以交流的表象為紐帶,通過對話界面進行信息輸出。用戶的主動提問或指令發出意味著自身認知結構與價值立場的預設,向生成式人工智能求取信息的行為本身即帶有服從于技術權威的潛在偏向,對生成式人工智能置于對話界面的信息的接受程度將大幅提高。從這個意義上看,生成式人工智能的信息撒播不再是單向的“圣言傳遞”,而是變成某種反饋機制——用戶主動伸出求取撒播的“橄欖枝”,生成式人工智能的撒播因而具有了針對性,即使不考慮用戶的解碼效果,也能夠通過交流紐帶與界面傳遞實現傳播效果。可以說,生成式人工智能的信息撒播是一種“超越撒播的撒播”。

更進一步來說,用戶的指令性內容可能是虛假的,或直截了當在對話界面要求生成式人工智能生成某種虛假信息,生成式人工智能撒播的傳播效果即具備了某種必然性。當生成式人工智能將對話界面的指令置入大模型,轉譯后的信息內容仍是虛假的,而用戶或許會欣然接受。以Sora為例,其根據用戶的指令文本生成的視覺影像已具備超擬真度,經過用戶話語引導所生成的場景,可能會被用于虛假新聞制作、負性情感煽動等偏頗行動。用戶于對話界面所放置的指令性內容也可能具有真實性,但生成式人工智能根據傳受雙方指令所置入的信息具有極大的不確定性,存在錯誤解讀用戶指令、錯誤擷取數據文本的可能,大模型可能會在數據界面提取到虛假數據進行嫁接,或由于自身技術邏輯的運作偏誤而產出虛假信息,從而稀釋對話界面的信息真實性。

由于生成式人工智能在創設層具有內置的語言訓練模型,導致其因自身技術邏9uyYA8eByvXmFPeY8QBeK6HktcHCHoTYPqicZ/rGfds=輯的框限,只能根據大規模接收到的數據價值取向與認知偏好在對話界面置入用以撒播的信息。因此,當具有非正當目的的用戶在對話界面持續密集地發出虛假指令或置入虛假語料時,生成式人工智能就可能在自身無法判斷前臺指令和語料合理性的前提下將生成的虛假信息呈現于對話界面,并根據技術邏輯的慣性將類似的虛假信息撒播至與其他用戶的對話界面之中。從這個意義上說,生成式人工智能可能被用于深度偽造,根據用戶在對話界面頻繁發出的指令,持續優化自身所生成的文本、圖像、視頻等內容,以用戶指令為導向不斷增加信息的虛假意義。深度偽造的內容將在更大程度上消解新聞的真實性,在對話界面指令的不斷規訓中將這些刻意輸送的用戶對話內容當作人類的真實反饋,由對話界面滲入創設層之中,甚至進行自我調整與引導。自此,越來越多的深度偽造信息將不斷被置入對話界面,以撒播態勢供用戶攝取,在更大維度內隱匿信息的真實性。

在撒播的過程中,部分用戶或能辨別出對話界面中信息的虛假性,而更多的用戶可能賦予虛假信息想象的真實,從而接受虛假信息的撒播,為虛假信息的流通創造條件。同時,具備不良意圖的用戶也會以此方式攫取撒播層中的虛假信息,并試圖將其置入公共空間的信息管道中進行流通,對話界面和用戶在撒播層共同構成傳播虛假信息的協作式社會行動者。

3. 流通層:生成式人工智能虛假信息的傳播

虛假信息經過撒播層后進入流通層,并在流通層滲入社會傳播機理之中。大范圍的信息撒播使虛假信息必然會流通于信息管道,通過平臺與算法的運作進一步呈現在網絡公共空間,導致信息秩序的失衡。

流通層的社會行動者是多元而復雜的,包括人類行動者與非人類行動者。撒播層中的部分虛假信息進入流通層,會被人類行動者傳播。首先表現為人際傳播與較為松散的群體傳播。個體用戶在無法辨別信息真偽時,會無意將虛假信息傳播給其他個體用戶,或者在網絡社交媒體、線下群聚活動中,對其他個體進行較為松散的虛假信息傳播。其他個體接收到虛假信息時,可能會因其缺乏判斷力、信息契應自身情感屬性等,向更多的個體和更大的群體傳播虛假信息,實現虛假信息在網絡公共空間的擴散。部分社會組織與機構出于營銷等目的,亦會參與生成式人工智能視域下的虛假信息傳播。這些虛假信息將深刻影響信息秩序的真實性意義,混淆人們對世界圖景的真實認知。

生成式人工智能虛假信息的傳播主體,還包括CASA范式下的其他非人類的社會行動者。有學者從傳染病學視角將虛假信息視為病原體,將網絡平臺視為有利的滋生環境,將媒介素養較低的受眾視為易感宿主,三者在交互作用中助推虛假信息的病毒式傳播。[13]生成式人工智能虛假信息將通過用戶的網絡身份流入互聯網平臺之中。平臺的技術賦權給予虛假信息傳播的可能性,由算法的運作機制所生發的“信息繭房”與“回聲室”效應會加劇用戶社群的分化與極化,使虛假信息對用戶認知結構深度介入的可能性大幅增加。由于用戶自身的專業知識面向有差異,對專業化信息與視像存在復雜認知,而用戶賦權又擠占了傳統媒體與學者專家的話語權,平臺媒介上公共話語的式微,為虛假信息的傳播提供了溫床。平臺使用戶得以聯結并組成圈層,使偏好性虛假信息在被算法識別之后,精準推薦至特定圈層,生成式人工智能視域下的虛假信息以更符合圈層用戶情感與認知的方式被分發投放,使虛假信息在圈層傳播中發揮更大影響,而每個圈層又同其他圈層間存在人員交疊,生成式人工智能下的虛假信息得以在平臺上突破圈層壁壘,獲得更為廣泛的傳播。

在平臺與算法的加持下,社交機器人作為重要的非人類社會行動者,對受眾的思考慣習和認知機制施加影響,人的主體性遭遇挑戰并可能淪為機器與人甚至是機器與機器之間連接的工具性介質。[14]在此意義上,生成式人工智能視域下的虛假信息或能夠憑借社交機器人進一步放大聲量,甚至直接在撒播層與社交機器人對接,將社交機器人架構為流通層的代言人。社交機器人則能夠通過虛假信息來干擾網絡話語和公共視聽,并偽裝為用戶積極參與媒介行動,以擴散虛假信息。生成式人工智能與社交機器人的聯結,能夠以機器間性提高虛假信息在網絡平臺的傳播范圍與影響,營造非真實的意見氣候,動搖真實用戶的思維認知。在非人類社會行動者發揮機器間性重構網絡空間的信息秩序與網絡用戶的認知圖景時,真實用戶也可能成為AGI背景下虛假信息傳播的助推手,互聯網的內容真實性將被進一步削弱。

生成式人工智能下虛假信息在流通層的深度傳播將帶來后事實世界體驗,即用戶對于真實性的感知并不依靠某事物的客觀性,而是基于看起來或感覺起來怎么樣,[15]即便信源的可信度存疑,但重復暴露的虛假信息將使人更容易感受到信息的真實性。尤其是Sora出現后,接收生成式人工智能虛假信息時將會有更多的感官被置入Sora所建構的場景中,通過情感與體驗感的補償對虛假情境產生真實化的偏向。觀點與事實之間的界限趨于模糊,價值觀念與情感經驗在流通層內的影響力持續增加,使權威機構的受信任度不斷降低,虛假信息在流通層擾動信息秩序并混淆視聽的可能性進一步增強。

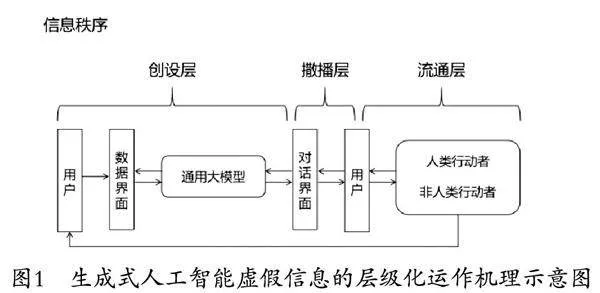

綜上所述,生成式人工智能虛假信息的生成與傳播在信息秩序中經歷了三個層級的運作:在創設層,通用大模型與數據界面相連,潛隱生成虛假信息的可能性;在撒播層,用戶通過對話界面與創設層實施偏誤的互動,虛假信息的生成與撒播成為事實;在流通層,原處于撒播層的虛假信息被置入信息管道并由多元行動者擴散至公共空間,滲入社會機理和認知圖景之中。由人類行動者與非人類行動者所解碼傳播的虛假信息,將在互聯網場域中重新被吸納到數據界面以待再次創設,實現層級閉環(見圖1)。

三、生成式人工智能視域下虛假信息的層級化治理

在層級化運作機理下,生成式人工智能視域下的虛假信息對信息秩序產生深刻影響,對虛假信息的治理成為全球關注的重要問題。本文不采用宏觀視野對生成式人工智能視域下虛假信息進行整體施治,而是追求精準治理、強效治理,即針對創設層、撒播層與流通層分別提出把關、研判、處置的具有側重性的治理方案,分別采取抑制、困囚、遮蔽的治理層次,使其上下聯通,彼此嵌套,實現覆蓋全生命周期的層級化治理。

1. 創設層把關:建立鏈式監測、分級管理的數據準入制度

在人機交互的過程中,用戶看似獲得了一種操控和改變界面的現實感,但實質上只是一種幻覺——人機交互界面讓內容真正的生產者(計算機系統)變得不可見,在技術編碼中以選擇的邏輯悄無聲息地替換了用戶的主觀意識。[16]對話界面所置入的信息看似由用戶的主觀性提問凝結而成,實際上卻蘊含著創設層的運行機制。作為虛假信息生成的重要層級,創設層中的虛假信息并沒有連接傳播渠道,未作用于任何行動者的認知結構或技術邏輯。因此,對創設層的虛假信息治理重在把關,將虛假信息扼制在搖籃中,從源頭消除撒播層中用戶產生幻覺的可能性。通過對進入創設層的原始數據進行規范,在數據界面扼制能夠產制虛假信息的語料文本,在通用大模型中削弱虛假信息技術生成邏輯的自洽性。

當前,生成式人工智能創設層中所吸納的數據存在不合規性與沖突性。在信息空間,生成式人工智能可能在未告知原始數據所有者的情況下便對其持有的數據進行采集,在數據界面所存有的部分數據具有不合規性。當信息空間內其他數據所有者意識到生成式人工智能的不合規采集行為時,則可能通過IP封禁、動態密鑰、賬號封禁等反采集措施阻斷機器人自動采集,但在維護自身數據安全與權利的同時阻斷了有益數據的流通共享,數據供需間發生沖突。基于此,學界對生成式人工智能數據采集問題的探討多集中于如何抑制數據泄露、防止數據不當使用等,傾向于對信息空間中各主體所持有的數據進行控制,以躲避生成式人工智能的不合規采集。然而,伴隨著生成式人工智能技術的快速迭代,海量的信息與紛雜的主體使得生成式人工智能數據采集的可控性大幅降低,其通過大模型生成虛假信息的能力已難以從外部進行管控。傳統的控制模式既難以維護數據安全,也無法促進數據發展。有鑒于此,創設層的治理應從數據控制的靜態視角轉向數據準入的動態視角,側重于對進入數據的把關而非對外部數據的整體治理。

生成式人工智能創設層的數據準入制度建設的本意并非探討生成式人工智能數據訪問與使用的權責邊界,而是以原始數據轉換為虛假信息的可能性為評判標準,重點規制數據利用行為,在數據界面建立把關制度。當數據進入數據界面時,不論該數據是否侵奪數據持有者的權益,數據獲取行為已經發生,所要強調的即轉變為該數據對內容生成與信息秩序將產生何種影響。因此,數據準入制度應以鏈式監測、分級管理為主要治理點。

鏈式監測旨在利用技術手段與人工手段相結合的方式對創設層的數據進行監測,對已經置入數據界面的數據進行實時監測與管理。一方面,這種監測必須設定虛假數據的技術監測裝置,該裝置應與公共辟謠平臺、虛假信息數據庫等信息設施連接,為技術監測提供豐富的文本規范與監測標準。同時,吸納學習政府開放的公共數據,將其中所蘊含的公共價值理念與信息文本意義轉化為技術性監測標準,強化技術消解虛假性的能力。另一方面,人工應發揮糾偏與完善作用,對技術監測裝置所生發的監測失誤和模糊之處進行檢查修正,提高真實數據的通過率與虛假數據的清除率,并對具有代表意義的虛假數據進行標記,將其通過鏈接反饋給各類打擊虛假信息的信息設施,形成虛假信息治理的有益循環。質言之,創設層數據界面應嵌入社會虛假信息治理的鏈網之中,與公共信息設施建立鏈式聯系,加強創設層的數據監測效能。當裝置監測到含有虛假意義的數據時,即可在數據界面予以清除,避免其流入通用大模型中進行生成;當裝置發現通用大模型中所生成的信息違背信息真實倫理或出現認知偏誤后能及時預警,由后臺技術人員進行審查清退。

數據準入制度應采取分級管理的方式,將生成式人工智能數據界面的數據類型進行分類,由此判斷數據的最終應用方式。首先,對涉及用戶或其他行動者隱私的數據給予嚴格限制,不允許生成式人工智能大模型任意侵奪。隱私數據同樣具有虛假性,部分用戶及其他行動者向網絡上傳隱私數據時,有意上傳虛假數據以規避重要隱私數據泄露的風險,當這類數據被生成式人工智能攫取后,不僅具備使大模型生成虛假信息的可能性,也違反了數據利用與信息生產的基本倫理。其次,對不涉及隱私安全的數據可實施進一步區分。經監測初步認定具有真實性的數據,可將其從數據界面傳遞至大模型中用以生產;經監測認定具有虛假性的數據,則留置于數據界面,由后臺管理人員進行定期清除。再次,對獲得政府授權運營許可的公共數據和面向社會主動公開的數據進行積極汲取,以公共價值的真實性稀釋大模型生成虛假信息的可能性。

2. 撒播層研判:進行“顯隱并彰”的標簽水印式信息困囚

在撒播層,生成式人工智能下的虛假信息已經成型并置入對話界面,接入對話主體用戶的認知視野,出現虛假信息的流通風險。因此,撒播層的虛假信息治理重在研判,旨在將虛假信息困囚于人機對話的界面之中,降低虛假信息惡性傳播的風險。撒播層的研判行為分為顯性層面與隱性層面,在顯性層面將信息進行標簽處理以供用戶進行研判,在隱性層面嵌入數字水印以供監管人員實施研判。

由于生成式人工智能背景下虛假信息的監管困難性,學界普遍將虛假信息的辨別與處理寄希望于用戶自身媒介素養的提高和傳播倫理的自律恪守。但作為具有感性認知的社會行動者,用戶自身容易在“信息繭房”中受困,在生成式人工智能所提供的虛假信息擬態環境的裹挾下自我極化。加之生成式人工智能下虛假信息意義紛繁復雜,用戶媒介教育體系建設任重道遠,短期內以提高用戶媒介素養的方式來對抗虛假信息或是一種幻想。相比之下,借助以標簽的技術理性方式將虛假信息困囚于對話界面更為可行。

針對從數據界面與通用大模型中所浮現的信息,可通過在對話界面建立生成式人工智能語言標簽系統,實施靶向治理,幫助用戶識別虛假信息。標簽在于從顯性層面成為用戶媒介素養的“義肢”,用戶能夠從對話界面看到創設層所生成信息的標簽,借此更為迅速準確地對信息真實性作出研判。標簽將額外的信息附加于生成式人工智能所生成的信息內容之上,包括信息核查結果、信息意義警告兩種標簽。對虛假信息進行標記能夠影響用戶的分享意圖,糾正用戶對真相的錯誤判斷,促進長效性的觀念改變。[17]政府與相關企業應將符合社會公序的價值觀置入語言標簽系統,并將虛假信息的判斷標準和識別技術納入其中,使其能夠為對話界面中的虛假信息進行標簽添加。對于違反信息真實原則的虛假信息,系統可添加信息標簽以告知用戶該信息為經核查后確認的虛假信息;對于違背社會公共價值觀的信息,系統亦能以標簽形式提醒用戶對該信息背后的意義導向提高判斷力。由此,用戶便可依據標簽的提示,判斷對話界面中信息的真偽和價值導向。

除了在顯性層面設置標簽提示用戶,還需在隱性層面嵌入數字水印。數字水印是一種將特殊信息嵌入數據集的技術,[18]能夠將標識性內容作為隱藏信息進行嵌入,并與原始數字產品相融合。[19]數字水印具有很強的“印刻力”,即使某信息在流通過程中被多次加入不同的水印,每個水印也可被獨立檢測出來以反映信息流通情況。[18]數字水印具備不可見性與可證明性特點,在確定數字作品的歸屬方面應用廣泛,多用于保護信息內容的知識產權。[20]在生成式人工智能勃興之時,數字水印技術能夠發揮獨特的信息治理作用。

在創設層,進入大模型的數據均需嵌入數字水印,用以標識該數據的來源。當用戶在對話界面置入話語后,大模型即可調動技術邏輯生成信息并放置于對話界面中。此時,通過拼接而成的信息內容會具有多重數字水印以顯示該信息生成的數據來源。用戶并不會看見數字水印,授權外的主體也難以修改水印信息,生成式人工智能信息中的數字水印能夠安全隱藏其中。當某條生成式人工智能虛假信息流入網絡空間并造成不良影響,治理主體即可通過該條信息的數字水印實現責任追蹤與判定,對生成虛假數據來源的主體進行精準規制與處罰。數據水印技術不僅用于標識創設層的數據,還可對用戶在對話界面投喂的文本語料進行標識。當發現對話界面頻繁密集出現特定虛假信息投喂情況時,即可通過該信息的數字水印對生成式人工智能所轄的所有對話界面進行查找,及時發現對話界面的虛假信息污染現象,將含有該數字水印的虛假信息進行批量清除,并追責相關主體。

3. 流通層處置:建強算法分發與公共力量的信息遮蔽效能

生成式人工智能視域下的虛假信息若未能被困囚于撒播層,其對信息秩序的擾動便已發生,需在流通層中施以信息遮蔽的治理措施,即降低虛假信息在公共空間的可見性,以強化智能虛假信息治理效能。流通層中包括人類行動者與非人類行動者多元主體,應將其充分納入治理體系,發揮不同行動者的積極效應,服務于流通層的虛假信息遮蔽。

“被看見”是輿論展開之基礎,特定議題、事件或人物必須首先“被看見”,即具有在公共空間中的可見性。[21]同理,可見性亦是虛假信息得以施加惡性影響的基礎。“可見”預示著何以被看見、何以被感知,“不可見”則意味著何以被隱匿、何以被隔絕。對虛假信息治理而言,消弭其可見性的治理成本要遠小于打擊其危害性的成本,在流通層隱匿虛假信息的可見性應成為優先考慮的治理對策。

算法等非人類社會行動者應在控制虛假信息可見性的過程中得到充分運用,當撒播層的虛假信息進入流通層時,流通層的監測技術就應承擔起“瞭望者”功能,對虛假信息進行識別,并交由算法對虛假信息的分發進行操縱,使虛假信息在社交網絡與互聯網平臺中“被看見”的可能性降低,傳播力度與傳播范圍得到削弱。算法對虛假信息的遮蔽是一個自動化決策的過程,包括排序、分類、關聯和過濾四個步驟:首先,將所識別出的虛假信息的優先級降低,使之難以出現在算法分發的前端;其次,將具有相同虛假性特征的虛假信息劃為同一組別;再次,將這些虛假信息間的意義進行關聯;最后,根據判斷標準過濾擾動信息秩序的虛假信息。通過降低信息的排名或降權來減少虛假信息進入算法推薦系統的可能,生成式人工智能背景下虛假信息在網絡空間的可見度就會大幅降低,對信息秩序的擾動隨之消弭。若虛假信息在公共空間的可見性持續放大,流通層內公共力量對虛假信息的直接識別與打擊則勢在必行。

政府要想在網絡治理中發揮主要的行動者作用,需扮演好公共服務者的角色,[22]對虛假信息在公共空間的有效治理離不開政府的擔綱。政府應根據社會主流價值導向與公共安全需求,對虛假信息進行具體化界定,以理性的判斷標準促動其他社會行動者參與到虛假信息的空間治理中,以側面遮蔽虛假信息的可見性。此外,政府亦應積極推進信息公開,因為信息公開的“核心價值在于主體在獲得足夠信息的基礎上進行互動與對話”。[23]當虛假信息在公共場域流通擴散時,政府的信息公開能夠對虛假信息內容做出正確的文本解釋,使虛假信息不攻自破,以透明真實的信息擠占虛假信息的生存空間。

戴揚認為,媒體的核心不是信息而是展示,關鍵在于顯示或隱藏。[24]在顯示層面,公共媒體及時披露關于事件的真實權威的信息是虛假信息治理的首要任務。[25]對于已經在社會面呈現的嚴重威脅社會秩序的虛假信息,媒體要向接觸到相關虛假信息的個體與群體推送澄清式信息,消除虛假信息對人們認知結構和社會真實圖景的損害,并積極進行輿論引導,從事實與道理層面進行共情傳播,增強真實信息的顯示面。在隱藏層面,以媒體為代表的組織化的社會行動者在接收到虛假信息時,不應為謀求注意力資源而將虛假信息的可見性擴大,而是在符合公共價值的基礎上進行判斷,對虛假新聞報道進行隱藏,對公共新聞中的信源進行核查,及時隱匿虛假信息,構建理性客觀的公共話語空間。

結語

生成式人工智能將虛假信息的生成與傳播帶入新的傳播格局,對信息秩序產生巨大沖擊。在層級化的視角下,生成式人工智能視域下虛假信息的運作機理可分為創設層、撒播層與流通層,虛假信息在其中層層嵌套,對信息秩序的影響逐層顯現,阻滯著社會真實性的勃發,隱匿著公眾對社會圖景的真實認知。有鑒于此,對生成式人工智能視域下虛假信息的治理需要實施層級化治理。在創設層重于把關,建立鏈式監測、分級管理的數據準入制度;在撒播層重于研判,對創設層中浮現的虛假信息進行信息標簽的顯性呈現與數字水印的隱性嵌入,將虛假信息困囚于對話界面;在流通層重于處置,發揮政府、媒體等公共力量,釋放真實透明的媒介信息,強化信息治理效能。

當前,虛假信息的創生傳播已全面AGI化,Sora的介入又使虛假信息趨于場景化,為虛假信息的治理帶來新挑戰。倫理道德和法律法規如何維系智慧社會的新秩序,已經成為社會科學又一重大難題。當下生成式人工智能虛假信息治理更需契合時代與科技的發展,在看到技術對信息秩序負面影響的同時,關切技術向善的可能性,并謹慎地將其納入信息治理的格局中,探索技術促動治理效率提升的可能性。在保持技術理性的同時,更不能舍棄人本主義的追求,應繼續發揮人的主觀能動作用,以正確的技術倫理和規范的法律規約參與到生成式人工智能視域下虛假信息治理中。

參考文獻:

[1] Tudjman M, Mikelic N. Information science: Science about information, misinformation and disinformation[J]. Proceedings of Informing Science+ Information Technology Education, 2003(3): 1513-1527.

[2] 張文祥,沈天健,孫熙遙. 從失序到再序:生成式人工智能下的信息秩序變局與治理[J]. 新聞界,2023(10):41-51.

[3] 朱嘉珺. 生成式人工智能虛假有害信息規制的挑戰與應對——以ChatGPT的應用為引[J]. 比較法研究,2023(5):34-54.

[4] 徐琦. 超越“計算機為社會行動者”范式:智媒時代人機傳播理論創新的突破點[J]. 現代傳播,2023(6):160-168.

[5] Reeves B, Nass C. The media equation: How people treat computers, television, and new media like real people[M]. London: Cambridge University Press, 1996: 10.

[6] 申琦. 服務、合作與復刻:媒體等同理論視閾下的人機交互[J]. 西北師大學報(社會科學版),2022,59(3):106-115.

[7] 金雪濤,周也馨. 從ChatGPT火爆看智能生成內容的風險及治理[J]. 編輯之友,2023(11):29-35.

[8] 胡翼青,姚文苑. 重新理解媒介:論界面、內容、物質的三位一體[J]. 新聞與寫作,2022(8):5-16.

[9] 朱亞希. 從移動界面出發理解傳播:論新媒介時代移動界面傳播的三重屬性[J]. 新聞界,2020(9):26-34.

[10] 胡翼青,王沐之. 發現界面:審視媒介的新路徑[J]. 湖南師范大學社會科學學報,2022(6):116-124.

[11] Deng J. Translation as A Problem of Communication: Some Reflections on Translating Speaking into the Air[J]. Media Theory, 2022, 5(2): 55-72.

[12] 列夫·馬諾維奇. 新媒體的語言[M]. 車琳,譯. 貴陽:貴州人民出版社,2020:73.

[13] Rubin V L. Disinformation and misinformation triangle: A conceptual model for fake news: epidemic, causal factors and interventions[J]. Journal of documentation, 2019, 75(5): 1013-1034.

[14] 漆亞林,王鈺涵. 社交機器人:數字用戶的建構邏輯與智能陷阱的治理路向[J]. 新聞與傳播研究,2022(9):59-71,127.

[15] 謝進川,唐恩思. 深度偽造的社會傷害與治理爭議[J]. 新聞與寫作,2023(4):96-105.

[16] 胡翼青. 西方媒介學名著導讀[M]. 北京:北京大學出版社,2023:202.

[17] Ecker U K H, O'Reilly Z, Reid J S, et al. The effectiveness of short-format refutational fact-checks[J]. British Journal of Psychology, 2020, 111(1): 36-54.

[18] 尹浩,林闖,邱鋒,等. 數字水印技術綜述[J]. 計算機研究與發展,2005(7):1093-1099.

[19] 牛夏牧,趙亮,黃文軍,等. 利用數字水印技術實現數據庫的版權保護[J]. 電子學報,2003(S1):2050-2053.

[20] 張怡夢,陳美欣,胡業飛. 區塊鏈、數字水印與全過程陽光:技術賦能下的政府數據開放風險管控體系設計[J/OL].[2024-02-04].情報雜志,http://kns.cnki.net/kcms/detail/61.1167.G3.20230221.1013.012.html.

[21] 周葆華. 算法、可見性與注意力分配:智能時代輿論基礎邏輯的歷史轉換[J]. 西南民族大學學報(人文社會科學版),2022,43(1):143-152.

[22] 田永鴻,韓冬雪,吳滿意,等.“人工智能與馬克思主義理論學科交叉研究”筆談[J]. 西南交通大學學報(社會科學版),2023(4):1-11.

[23] 張文祥,楊林. 多元對話:突發公共衛生事件的信息傳播治理[J]. 山東大學學報(哲學社會科學版),2020(5):24-30.

[24] Dayan D. Comm Research—Views from Europe| Conquering Visibility, Conferring Visibility: Visibility Seekers and Media Performance[J]. International Journal of Communication, 2013(7): 17.

[25] 丁曉蔚,李明. 基于大數據AI的重大突發事件媒介化治理——一項系統性的應用研究[J]. 編輯之友,2022(12):59-70.

Hierarchical Operation Mechanisms and Governance of Disinformation in the Era of Generative AI

ZHOU Yan, SHEN Tian-jian(School of Culture and Communication, Shandong University, Weihai 264200, China)

Abstract: The widespread integration of generative AI in information production and communication has ushered in a significant paradigm shift in information order, notably expediting the generation and communication of disinformation. This paper delves into the operational mechanisms of disinformation within the realm of generative AI and advocates for a nuanced, hierarchical governance approach. Specifically, at the creation layer, to create a new type of gate-keeping strategy to suppress disinformation at the source of information production, it is necessary to establish a Data Access System with chained monitoring and hierarchical management as its main component. At the dissemination layer, to eliminate the disinformation put in by the user in the dialog interface, trap the disinformation in the dialog interface and form a diffusion obstacle, the disinformation produced in the creation layer is explicitly presented with information labels and implicitly embedded with digital watermarking at the same time. At the circulation layer, the emphasis lies in disposition, obscuring the visibility of disinformation by refining algorithms governing its automated decision-making processes. It also brings into play the power of the government, the media and other public forces to release truthful and transparent information, thereby forming a flexible disinformation filtering mechanism and enhancing the effectiveness of information governance.

Key words: generative AI; disinformation; information governance; Sora

(責任編輯:侯苗苗)

基金項目:山東省社會科學規劃項目“網絡敘事的底層群體主體化及其對互聯網輿論的影響研究”(23CXWJ07);教育部人文社會科學重點研究基地重大項目“國家治理體系現代化中的傳媒治理研究”(22JJD860016)

作者信息:周妍(1982— ),女,河南開封人,山東大學文化傳播學院副教授、碩士生導師,主要研究方向:媒介文化、網絡治理;沈天健(1993— ),男,山東濟寧人,山東大學文化傳播學院新聞傳播研究所助理研究員,主要研究方向:媒介文化、網絡治理。