基于改進(jìn)YOLOv5的輕量級(jí)黃花成熟檢測方法

摘要:黃花菜具有較短的采摘周期和相對(duì)嚴(yán)格的采摘要求,針對(duì)傳統(tǒng)人工采摘效率低、主觀性高的問題,提出一種基于深度學(xué)習(xí)的SSH-YOLOv5黃花成熟度檢測算法。以YOLOv5模型為基礎(chǔ),結(jié)合輕量級(jí)網(wǎng)絡(luò)ShuffleNet V2基本殘差單元壓縮網(wǎng)絡(luò)模型大小,提升模型目標(biāo)檢測速度;引入SE Net通道注意力機(jī)制模塊,增強(qiáng)模型對(duì)有用特征信息的敏感度,提高目標(biāo)檢測精度;將普通卷積替換為深度可分離卷積模塊,進(jìn)一步減少模型計(jì)算量。試驗(yàn)結(jié)果表明,改進(jìn)后的SSH-YOLOv5模型參數(shù)量和浮點(diǎn)運(yùn)算量分別減少61.6%和68.3%,網(wǎng)絡(luò)層數(shù)減少18%,同時(shí)SSH-YOLOv5的檢測精度由原算法的88.8%提高到91.2%,實(shí)時(shí)檢測速度達(dá)到66.4 f/s,相比原算法提高18.1%,達(dá)到實(shí)時(shí)檢測要求。改進(jìn)后的算法不僅實(shí)現(xiàn)模型的輕量化,同時(shí)也使黃花成熟度檢測更加準(zhǔn)確和快速,可以較好地滿足黃花檢測需求。

關(guān)鍵詞:黃花;深度學(xué)習(xí);YOLOv5算法;輕量化;注意力機(jī)制

中圖分類號(hào):TP399

文獻(xiàn)標(biāo)識(shí)碼:A

文章編號(hào):20955553 (2024) 070235

09

Lightweight method for maturity detection of Hemerocallis citrina Baroni

based on improved YOLOv5

Wu Ligang1, Lü Yuanyuan2, Zhou Qian3, Chen Le2, Zhang Liang2, Shi Jianhua1

(1. School of Mechanical and Electrical Engineering, Shanxi Datong University, Datong, 037003, China;

2. School of Coal Engineering, Shanxi Datong University, Datong, 037003, China;

3. School of Business, Shanxi Datong University, Datong, 037003, China)

Abstract:

Hemerocallis citrina Baroni has a short picking cycle and relatively strict picking requirements. Aiming at the problems of" the low efficiency and high subjectivity of manual harvesting of Hemerocallis citrina Baroni, a deep learning-based SSH-YOLOv5 Hemerocallis citrina Baroni maturity detection algorithm was proposed. Based on the YOLOv5 model, combined with the lightweight network ShuffleNet V2 basic residual unit to compress the size of the network model, and improve the model target detection speed. The attention mechanism module of Squeeze-and-Excitation network was integrated into the model to enhance the sensitivity of the model to useful feature information, and improve target detection precision, and ordinary convolution was replaced with depth-separable convolution module to further reduce the model computation. The experimental results showed that the number of parameters and floating point operations of the improved SSH-YOLOv5 model were reduced by 61.6% and 68.3% respectively, and the number of network layers was reduced by 18%, while the detection precision of SSH-YOLOv5 was improved from 88.8% to 91.2% of the original algorithm. The real-time detection speed reached 66.4 f/s, which was 18.1% higher than the original YOLOv5 algorithm and met the real-time detection requirements. The improved algorithm not only makes the model lightweight, but also makes Hemerocallis citrina Baroni maturity detection more accurate and faster, which can better meet the demand of Hemerocallis citrina Baroni detection.

Keywords:

Hemerocallis citrina Baroni; deep learning; YOLOv5 algorithm; lightweight; attention mechanism

0 引言

當(dāng)前黃花采摘以人工采摘為主,黃花的最佳采摘時(shí)間在光照強(qiáng)度較弱的凌晨或傍晚,工人需在短時(shí)間內(nèi)根據(jù)黃花的形態(tài)、顏色和大小等特征迅速識(shí)別黃花是否達(dá)到采摘標(biāo)準(zhǔn),因此存在主觀性高、采摘效率低的問題[1]。隨著目標(biāo)識(shí)別領(lǐng)域的迅速發(fā)展,通過智能采摘代替人工采摘,是提高黃花種植產(chǎn)量和采摘效率的有效途徑[2]。

近年來,基于卷積神經(jīng)網(wǎng)絡(luò)的智能采摘算法表現(xiàn)出優(yōu)秀的性能[3, 4],目前被廣泛應(yīng)用于果實(shí)與農(nóng)作物檢測的深度學(xué)習(xí)算法主要有兩類,一類是以R-CNN[5]、Faster R-CNN[6]為代表的Two-stage算法,將檢測過程分為兩個(gè)階段,側(cè)重于目標(biāo)檢測的精度;另一類是以SSD[7]、YOLO[810]為代表的One-stage算法,將目標(biāo)檢測任務(wù)轉(zhuǎn)換為端到端的回歸問題,因此在目標(biāo)檢測的速度方面有更好的表現(xiàn)[11]。朱紅春等[12]以復(fù)雜背景下的茶葉嫩芽為檢測對(duì)象,通過對(duì)比基于Fast R-CNN的深度學(xué)習(xí)算法和傳統(tǒng)檢測算法對(duì)茶葉嫩芽的檢測結(jié)果,表明了基于深度學(xué)習(xí)目標(biāo)檢測算法的優(yōu)越性;岳有軍等[13]提出一種基于改進(jìn)Cascade R-CNN網(wǎng)絡(luò)對(duì)番茄果實(shí)識(shí)別方法,增強(qiáng)了網(wǎng)絡(luò)對(duì)重疊果實(shí)的識(shí)別能力,識(shí)別準(zhǔn)確率相較原網(wǎng)絡(luò)提高了約2個(gè)百分點(diǎn)。湯旸等[14]提出一種基于改進(jìn)YOLOv3-tiny輕量化柑橘識(shí)別方法,平均檢測精度為96.52%,在不同的背景下,均具有良好的檢測性能;王卓等[15]提出基于YOLOv4的輕量化蘋果檢測算法,平均檢測精度達(dá)到92.23%,在嵌入式平臺(tái)的檢測速度為15.11FPS,可滿足采摘機(jī)器人實(shí)時(shí)性需求;Zhang等[16]提出一種基于YOLOv5的輕量化雙注意力機(jī)制算法,將網(wǎng)絡(luò)模型壓縮了63.4%,對(duì)自然背景環(huán)境下黃花菜的檢測精度達(dá)到84.9%。基于深度學(xué)習(xí)的智能采摘已被廣泛應(yīng)用,為進(jìn)一步提高目標(biāo)檢測網(wǎng)絡(luò)的實(shí)時(shí)性,智能采摘目標(biāo)檢測模型的輕量化改進(jìn)也成為熱門研究方向,為黃花的輕量級(jí)成熟度檢測方法提供了參考。

大規(guī)模種植下的黃花植株密集,在復(fù)雜的自然環(huán)境背景下,存在花朵重疊、枝葉遮擋、光線不均的情況,因此會(huì)對(duì)模型檢測精度造成一定的影響[17],另外,在黃花檢測網(wǎng)絡(luò)的實(shí)際應(yīng)用場景中,通常需要搭載于算力資源有限的嵌入式平臺(tái),而復(fù)雜、大型的檢測模型難以部署其中[18],因此,如何在保證模型檢測精度的同時(shí)精簡模型,成為自然環(huán)境下黃花成熟度檢測算法的主要研究問題和難點(diǎn)[19]。

針對(duì)上述問題,本文提出一種結(jié)合ShuffleNet V2網(wǎng)絡(luò)和SE Net注意力機(jī)制的SSH-YOLOv5黃花成熟度檢測方法,以YOLOv5算法為基礎(chǔ),將主干網(wǎng)絡(luò)的C3模塊替換為輕量級(jí)網(wǎng)絡(luò)ShuffleNet V2基礎(chǔ)模塊,壓縮模型、提升模型檢測速度,把普通卷積模塊替換為深度可分離卷積模塊,進(jìn)一步減少模型計(jì)算量;引入通道注意力機(jī)制模塊,彌補(bǔ)模型輕量化對(duì)檢測精度造成的部分損失。

1 SSH-YOLOv5算法

1.1 YOLOv5算法

YOLO算法是由Joseph Redmon等提出的一種One-stage實(shí)時(shí)目標(biāo)檢測方法,YOLOv5是目前YOLO系列較新且穩(wěn)定性高的一個(gè)算法,具有良好的泛化性能,被廣泛應(yīng)用于各個(gè)領(lǐng)域的目標(biāo)檢測。

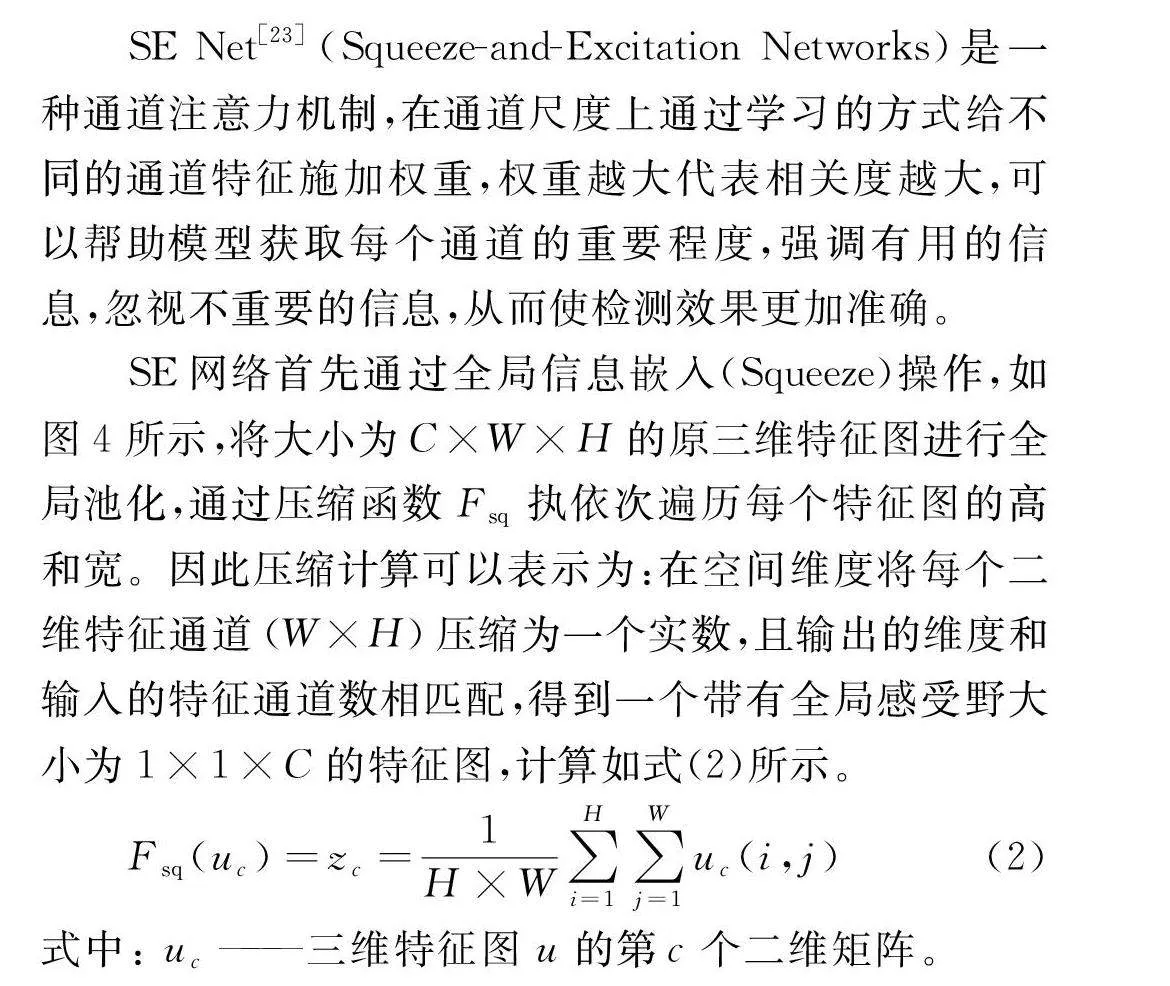

YOLOv5網(wǎng)絡(luò)有輸入端(Input)、特征提取網(wǎng)絡(luò)(Backbone)、頸部網(wǎng)絡(luò)(Neck)、輸出端(Head)四個(gè)部分。YOLOv5的檢測流程如圖1所示,圖像在輸入端經(jīng)過數(shù)據(jù)增強(qiáng)后由特征提取網(wǎng)絡(luò)提取圖像特征,特征提取網(wǎng)絡(luò)主要由CBS模塊、C3模塊和SPPF模塊組成,CBS模塊與C3模塊通過大量的卷積操作提取特征并生成特征圖,處在Backbone末端的SPPF模塊則將不同尺度的特征圖輸出一個(gè)固定長度的向量,然后將固定長度的向量輸入到全連接層,進(jìn)行后續(xù)的分類檢測任務(wù),經(jīng)過特征提取后得到三個(gè)不同尺度的特征圖像,分別用來識(shí)別不同大小的目標(biāo)信息,頸部網(wǎng)絡(luò)將三個(gè)尺度的特征進(jìn)行融合,增強(qiáng)語義表達(dá)和目標(biāo)框定位能力,最后在輸出端將三個(gè)維度的預(yù)測結(jié)果輸出,包括預(yù)測目標(biāo)的位置、類別以及置信度。

YOLOv5網(wǎng)絡(luò)模型雖然具有極佳的目標(biāo)檢測效果,但神經(jīng)網(wǎng)絡(luò)多層不同尺度的卷積操作會(huì)產(chǎn)生大量的冗余特征圖,會(huì)對(duì)模型的檢測速度造成一定影響,因此需針對(duì)此問題對(duì)YOLOv5的特征提取網(wǎng)絡(luò)模塊進(jìn)行輕量化改進(jìn),以保證黃花成熟度檢測模型在嵌入式設(shè)備中有較高的實(shí)時(shí)性。

1.2 網(wǎng)絡(luò)輕量化

1.2.1 ShuffleNet V2輕量化網(wǎng)絡(luò)

本文的檢測任務(wù)僅針對(duì)黃花,YOLOv5網(wǎng)絡(luò)模型在單類別檢測任務(wù)中,參數(shù)量以及計(jì)算量冗余的問題更為顯著,在Backbone中,C3模塊是結(jié)構(gòu)更為復(fù)雜的特征提取模塊,因此將YOLOv5特征提取網(wǎng)絡(luò)中的C3模塊替換為輕量化網(wǎng)絡(luò)ShuffleNet V2的基礎(chǔ)模塊,壓縮模型大小,減少模型計(jì)算量,提升目標(biāo)檢測速度,保證黃花成熟度檢測網(wǎng)絡(luò)的實(shí)時(shí)性。

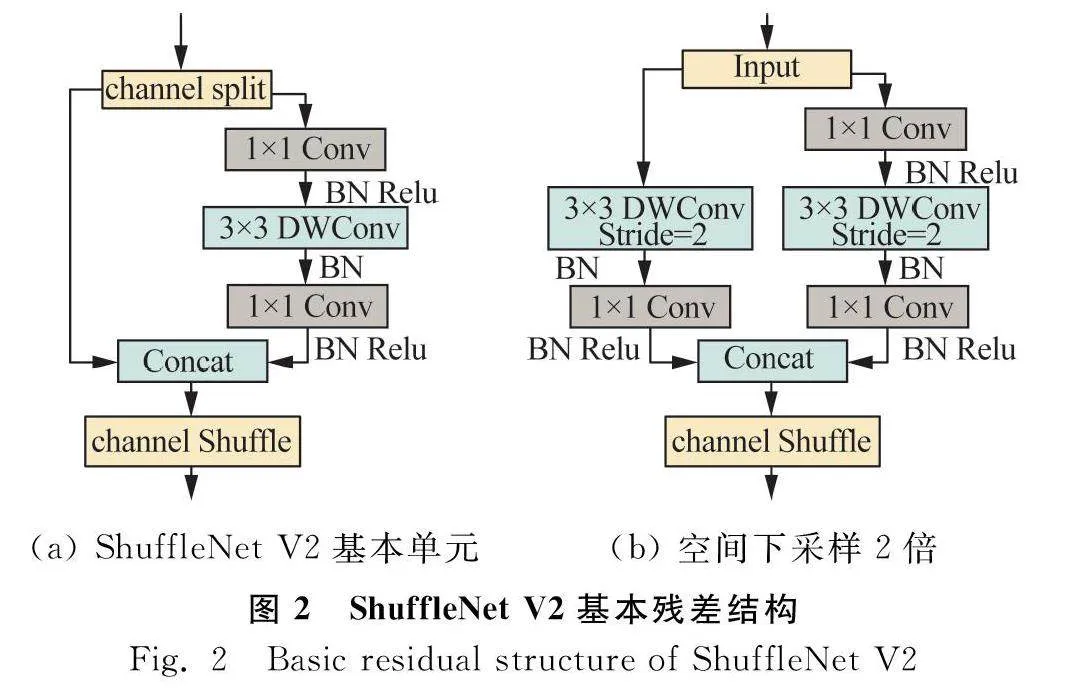

ShuffleNet V2[20]充分考慮內(nèi)存訪問成本(MAC),提出在盡量保證1×1卷積操作通道寬度相等的情況下,減少組卷積、模型分支和通道相加(add)等元素級(jí)運(yùn)算,相較ShuffleNet V1[21]網(wǎng)絡(luò),ShuffleNet V2網(wǎng)絡(luò)具有更加高效的網(wǎng)絡(luò)模塊,第一個(gè)核心網(wǎng)絡(luò)模塊如圖2(a)所示,輸入的特征圖由通道分離(channel split)操作分成兩個(gè)分支,右邊的分支由深度卷積和普通卷積構(gòu)成,左邊分支做同等映射,兩個(gè)分支輸出的特征圖經(jīng)過通道合并(concat)后,進(jìn)一步將不同通道的信息進(jìn)行融合(channel shuffle),加強(qiáng)通道之間的信息交流。ShuffleNet V2的第二個(gè)核心模塊是下采樣模塊,如圖2(b)所示,該模塊不再有通道分離,而是將特征圖直接輸入到兩個(gè)通道,每個(gè)分支都有步長為2的下采樣,最后兩通道進(jìn)行合并,可以使特征圖空間大小減半,但是通道數(shù)翻倍。

將YOLOv5特征提取網(wǎng)絡(luò)的C3模塊替換為ShuffleNet V2中心網(wǎng)絡(luò)模塊,可以有效地降低模型的參數(shù)量和計(jì)算量,提升目標(biāo)檢測速度,但同時(shí)會(huì)帶來精度的損失,因此需進(jìn)一步對(duì)網(wǎng)絡(luò)模型進(jìn)行改進(jìn),以彌補(bǔ)網(wǎng)絡(luò)輕量化對(duì)模型精度造成的影響,將檢測速度與精度實(shí)現(xiàn)較好的平衡。

1.2.2 深度可分離卷積

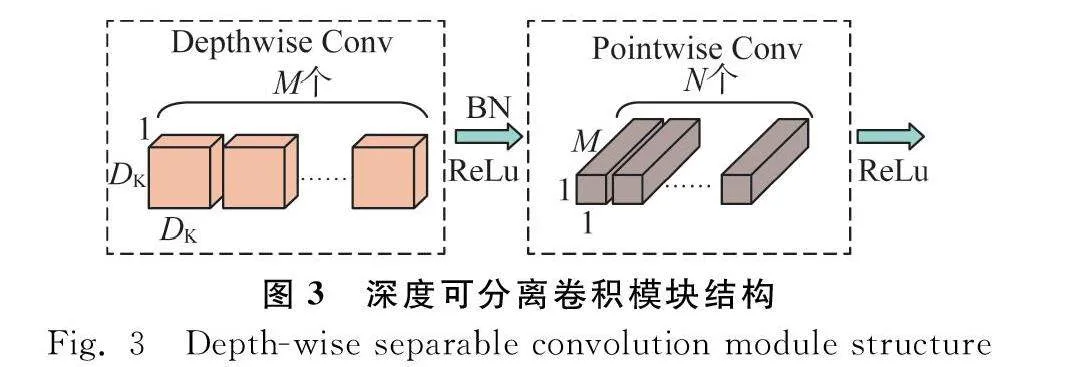

深度可分離卷積(Depth-wise separable convolution)是MobileNet-v1[22]、MobileNet-v2[23]等輕量化網(wǎng)絡(luò)的卷積模塊,目的在于減少卷積計(jì)算量。

深度可分離卷積模塊由深度卷積(Depth-wise Conv)和逐點(diǎn)卷積(Pointwise Conv)兩部分卷積組成,如圖3所示,大小為DF×DF的特征圖像在深度卷積部分由M個(gè)深度為1、大小為DK×DK的分通道卷積核卷積,每個(gè)卷積核和輸出的通道對(duì)應(yīng),沒有有效的利用相同空間位置上不同層的有效信息,因此第二部分逐點(diǎn)卷積將第一部分各自獨(dú)立的特征圖再通過N個(gè)深度為M、大小為1×1的卷積核進(jìn)行融合,生成新的特征圖,進(jìn)一步提取特征。深度可分離卷積與傳統(tǒng)卷積的參數(shù)量之比C計(jì)算如式(1)所示。

C=1N+1DK2

(1)

由式(1)可知,傳統(tǒng)卷積的參數(shù)量是深度可分離卷積模塊的C倍(Cgt;1),而CBS模塊由傳統(tǒng)卷積、BN層和SiLU函數(shù)構(gòu)成,因此將YOLOv5特征提取網(wǎng)絡(luò)中的CBS模塊替換為輕量化的深度可分離卷積模塊,可以有效降低卷積運(yùn)算計(jì)算量,壓縮模型大小,保證模型目標(biāo)跟蹤的實(shí)時(shí)性,更符合嵌入式設(shè)備對(duì)黃花目標(biāo)檢測模型的輕量化要求。

1.3 SE Net注意力機(jī)制

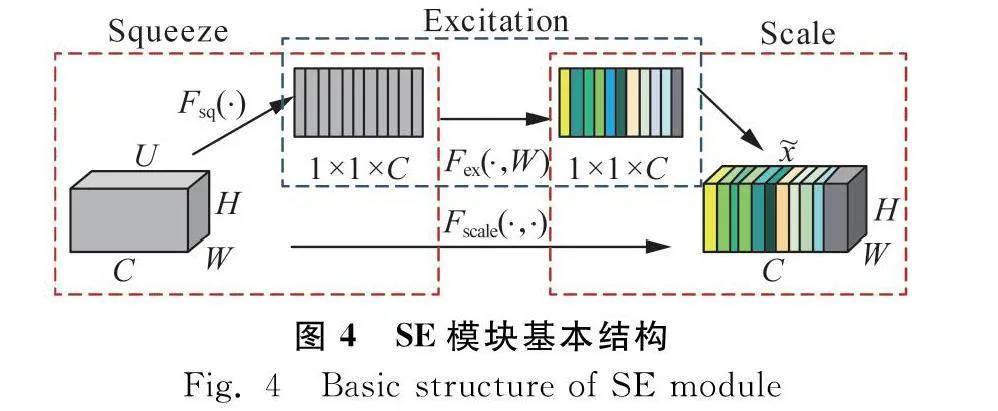

SE Net[23](Squeeze-and-Excitation Networks)是一種通道注意力機(jī)制,在通道尺度上通過學(xué)習(xí)的方式給不同的通道特征施加權(quán)重,權(quán)重越大代表相關(guān)度越大,可以幫助模型獲取每個(gè)通道的重要程度,強(qiáng)調(diào)有用的信息,忽視不重要的信息,從而使檢測效果更加準(zhǔn)確。

SE網(wǎng)絡(luò)首先通過全局信息嵌入(Squeeze)操作,如圖4所示,將大小為C×W×H的原三維特征圖進(jìn)行全局池化,通過壓縮函數(shù)Fsq執(zhí)依次遍歷每個(gè)特征圖的高和寬。因此壓縮計(jì)算可以表示為:在空間維度將每個(gè)二維特征通道(W×H)壓縮為一個(gè)實(shí)數(shù),且輸出的維度和輸入的特征通道數(shù)相匹配,得到一個(gè)帶有全局感受野大小為1×1×C的特征圖,計(jì)算如式(2)所示。

Fsq(uc)=zc=1H×W∑Hi=1∑Wj=1uc(i,j)

(2)

式中:

uc——

三維特征圖u的第c個(gè)二維矩陣。

第二步進(jìn)行自適應(yīng)重新校正(Excitation),該模塊由兩個(gè)全連接神經(jīng)網(wǎng)絡(luò)連接,通過sigmoid函數(shù)為每個(gè)特征通道生成權(quán)重,表示各個(gè)特征通道間的相關(guān)性,計(jì)算如(3)所示。

Fex(z,W)=sigmoid[W2×ReLU(W1z)]

(3)

式中:

W1、W2——線性層;

z——Squeeze操作后的特征圖。

最后Scale操作將c個(gè)權(quán)重逐通道加權(quán),完成在通道維度上對(duì)原始特征的自適應(yīng)重標(biāo)定,把重要的特征增強(qiáng),不重要的特征減弱,使每個(gè)通道重要性不同,從而讓提取的特征指向性更強(qiáng),得到最終的特征圖如式(4)所示。

Fscale(uc,sc)=x~c=scuc

(4)

式中:

sc——通道權(quán)重。

施加SE Net注意力機(jī)制可以一定程度上彌補(bǔ)輕量化特征提取網(wǎng)絡(luò)對(duì)檢測精度造成的損失,同時(shí),自然環(huán)境下的黃花背景復(fù)雜,存在花朵枝葉折疊遮擋的情況,注意力機(jī)制可以提高模型對(duì)目標(biāo)的敏感度,忽視背景特征,提高自然環(huán)境下對(duì)黃花識(shí)別的準(zhǔn)確度。

1.4 SSH-YOLOv5網(wǎng)絡(luò)結(jié)構(gòu)

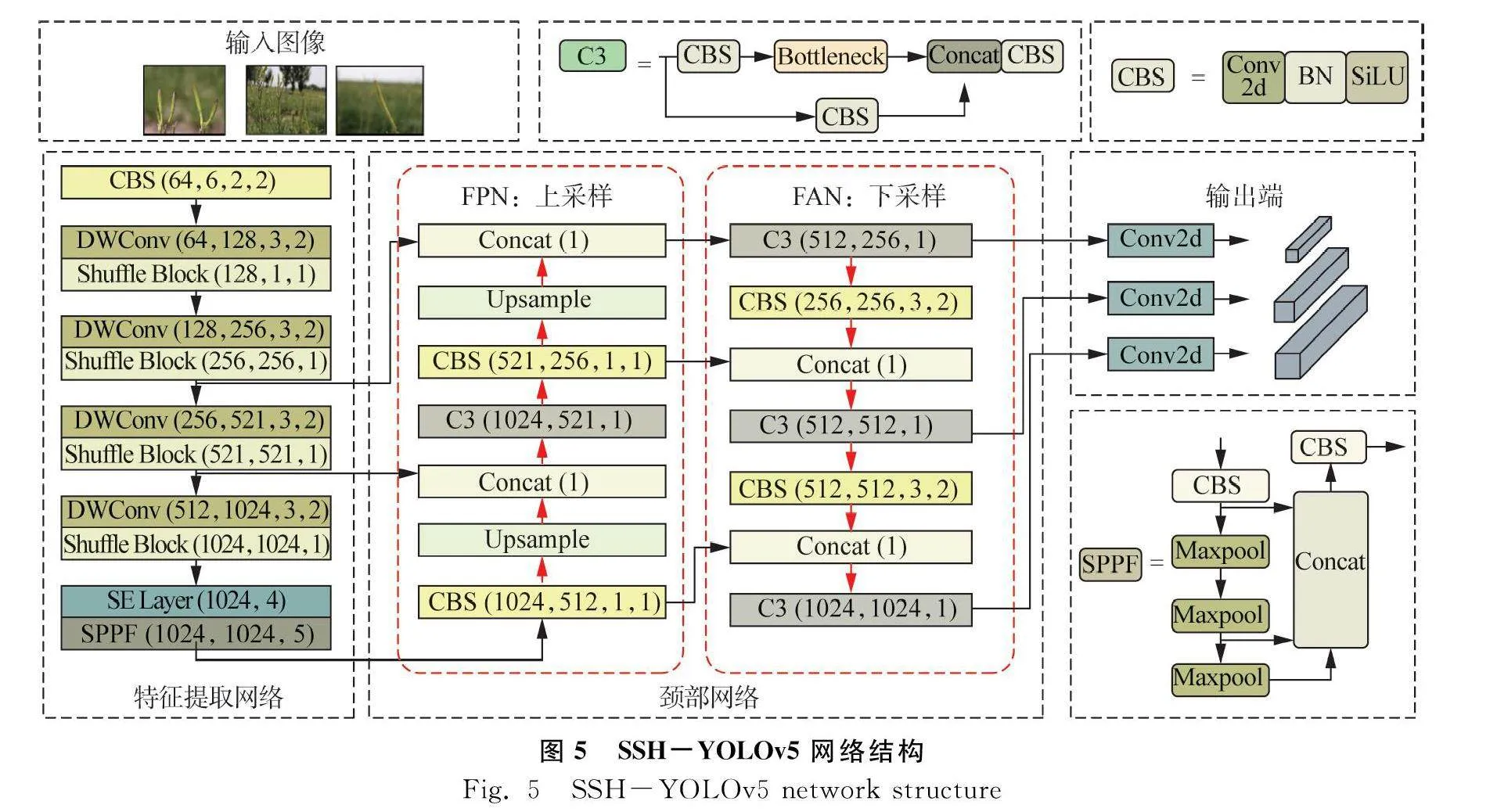

SSH-YOLOv5算法基于YOLOv5網(wǎng)絡(luò),根據(jù)檢測任務(wù)對(duì)網(wǎng)絡(luò)模型進(jìn)行改進(jìn),在特征提取網(wǎng)絡(luò)中,C3模塊由CBS模塊和Bottleneck殘差結(jié)構(gòu)組成,作為更為重要的特征提取模塊,將其替換為ShuffleNet V2輕量化網(wǎng)絡(luò)的基本殘差單元,同時(shí)用深度可分離卷積模塊替代CBS傳統(tǒng)卷積模塊,減少特征提取網(wǎng)絡(luò)中的傳統(tǒng)卷積操作,進(jìn)而減少其生成的冗余特征圖,壓縮模型大小,提升目標(biāo)檢測速度,同時(shí)引入通道注意力機(jī)制SE Net,將不同重要程度的特征施加權(quán)重,提升主干網(wǎng)絡(luò)提取重要特征的能力在頸部網(wǎng)絡(luò)中,由FPN+PAN結(jié)構(gòu)將提取到的特征進(jìn)行融合,F(xiàn)PN把高層特征的語義信息自上而下的傳達(dá),通過上采樣與底層特征融合,PAN則是從下向上傳輸定位信息的特征金字塔,是對(duì)FPN操作進(jìn)行進(jìn)一步的補(bǔ)充。

SSH-YOLOv5算法步驟如下:首先輸入黃花數(shù)據(jù)集,圖像進(jìn)入圖5所示的特征提取網(wǎng)絡(luò),由改進(jìn)后的輕量化特征提取網(wǎng)絡(luò)對(duì)不同種類、不同大小的特征進(jìn)行提取,下一步在頸部網(wǎng)絡(luò)進(jìn)行上采樣、卷積、融合等操作,最后模型在輸出端部分輸出三個(gè)維度的預(yù)結(jié)果,包括目標(biāo)框、目標(biāo)類型和目標(biāo)置信度。

2 試驗(yàn)結(jié)果與分析

本次試驗(yàn)的數(shù)據(jù)集均為實(shí)地場景拍攝,采集時(shí)間均為清晨或傍晚黃花菜采集的最佳時(shí)間段。采集設(shè)備為Conon EOS 90D,獲得的圖像數(shù)據(jù)集分辨率為6960像素×4640像素。采集了不同光線、背景以及不同遮擋情況下的黃花圖像,保證了數(shù)據(jù)集的多樣性。

在對(duì)數(shù)據(jù)集的處理過程中,對(duì)圖像進(jìn)行篩選與對(duì)比,共獲得834張圖像。其中訓(xùn)練集和驗(yàn)證集分別為500張和200張,測試集134張。此外,應(yīng)用LabelImg軟件對(duì)數(shù)據(jù)集中的834張黃花圖像進(jìn)行標(biāo)注,文件格式為YOLO格式,用數(shù)據(jù)標(biāo)注工具包對(duì)黃花圖像進(jìn)行標(biāo)簽制作,分為未成熟(immature)與成熟(mature)兩個(gè)類別,保存標(biāo)注信息為txt格式。

為驗(yàn)證所提出SSH-YOLOv5算法的優(yōu)勢,消融試驗(yàn)在相同的試驗(yàn)環(huán)境和訓(xùn)練參數(shù)下進(jìn)行,模型訓(xùn)練均在AUTODL服務(wù)器完成,運(yùn)行環(huán)境為PyTorch1.7.0、Python 3.8、Cuda 11.0,硬件配置為RTX 3080 GPU,12核Intel(R) Xeon(R) CPU、45GB內(nèi)存和10GB顯存。

訓(xùn)練時(shí)迭代次數(shù)(epochs)設(shè)置為300輪,批量大小(batch size)為8,起始學(xué)習(xí)率(learning rate)為0.01,權(quán)重衰減系數(shù)(weight decay)為0.005,動(dòng)量系數(shù)(momentum)為0.937。YOLOv5-6.0版本新增的早停機(jī)制會(huì)實(shí)時(shí)監(jiān)控訓(xùn)練效果,根據(jù)訓(xùn)練情況自動(dòng)提前終止訓(xùn)練,可以提升模型訓(xùn)練效率。在早停機(jī)制的作用下,原始算法在完成265次停止訓(xùn)練,改進(jìn)的算法完成295輪后停止訓(xùn)練。

2.1 評(píng)價(jià)指標(biāo)

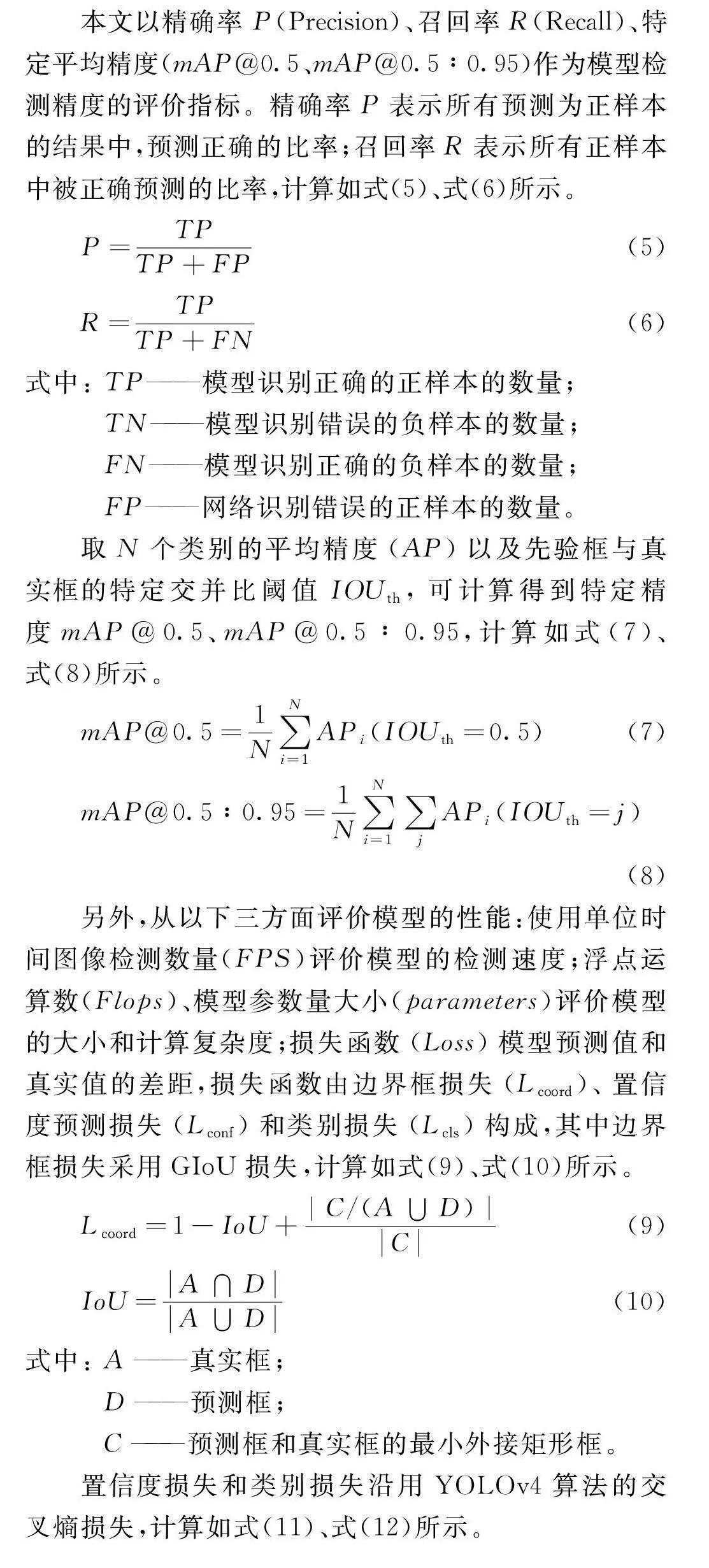

本文以精確率P(Precision)、召回率R(Recall)、特定平均精度(mAP@0.5、mAP@0.5∶0.95)作為模型檢測精度的評(píng)價(jià)指標(biāo)。精確率P表示所有預(yù)測為正樣本的結(jié)果中,預(yù)測正確的比率;召回率R表示所有正樣本中被正確預(yù)測的比率,計(jì)算如式(5)、式(6)所示。

P=TPTP+FP

(5)

R=TPTP+FN

(6)

式中:

TP——

模型識(shí)別正確的正樣本的數(shù)量;

TN——

模型識(shí)別錯(cuò)誤的負(fù)樣本的數(shù)量;

FN——

模型識(shí)別正確的負(fù)樣本的數(shù)量;

FP——

網(wǎng)絡(luò)識(shí)別錯(cuò)誤的正樣本的數(shù)量。

取N個(gè)類別的平均精度(AP)以及先驗(yàn)框與真實(shí)框的特定交并比閾值IOUth,可計(jì)算得到特定精度mAP@0.5、mAP@0.5∶0.95,計(jì)算如式(7)、式(8)所示。

mAP@0.5=1N∑Ni=1APi(IOUth=0.5)

(7)

mAP@0.5∶0.95=1N∑Ni=1∑jAPi(IOUth=j)

(8)

另外,從以下三方面評(píng)價(jià)模型的性能:使用單位時(shí)間圖像檢測數(shù)量(FPS)評(píng)價(jià)模型的檢測速度;浮點(diǎn)運(yùn)算數(shù)(Flops)、模型參數(shù)量大小(parameters)評(píng)價(jià)模型的大小和計(jì)算復(fù)雜度;損失函數(shù)(Loss)模型預(yù)測值和真實(shí)值的差距,損失函數(shù)由邊界框損失(Lcoord)、置信度預(yù)測損失(Lconf)和類別損失(Lcls)構(gòu)成,其中邊界框損失采用GIoU損失,計(jì)算如式(9)、式(10)所示。

Lcoord=1-IoU+|C/(A∪D)|C

(9)

IoU=A∩DA∪D

(10)

式中:

A——真實(shí)框;

D——預(yù)測框;

C——預(yù)測框和真實(shí)框的最小外接矩形框。

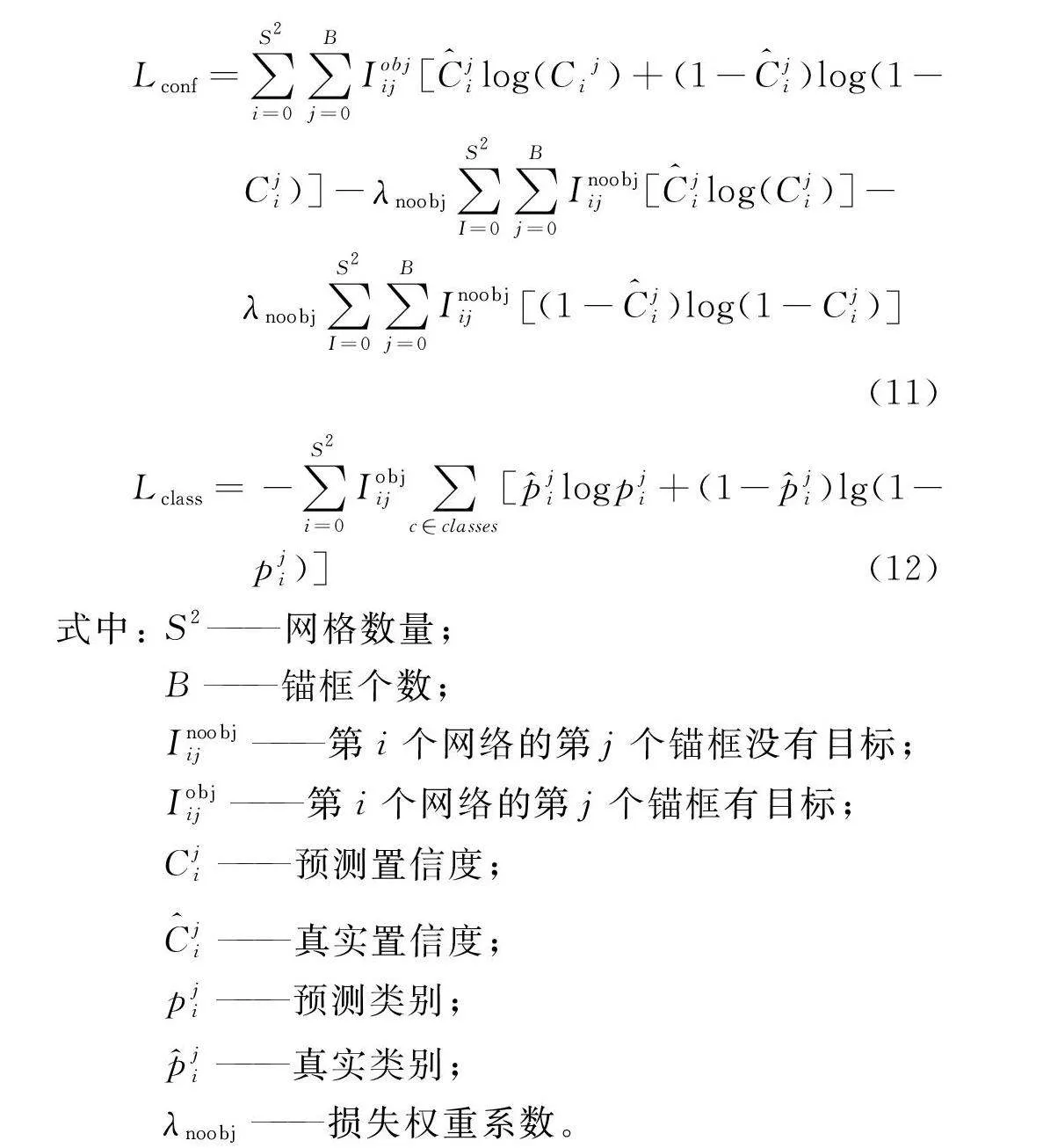

置信度損失和類別損失沿用YOLOv4算法的交叉熵?fù)p失,計(jì)算如式(11)、式(12)所示。

Lconf=

∑S2i=0∑Bj=0Iobjij[C^jilog(Cij)+(1-C^ji)log(1-

Cji)]-λnoobj∑S2I=0∑Bj=0Inoobjij[C^jilog(Cji)]-

λnoobj∑S2I=0∑Bj=0Inoobjij(1-C^ji)log(1-Cji)

(11)

Lclass=

-∑S2i=0Iobjij∑c∈classes[p^jilogpji+(1-p^ji)lg(1-pji)]

(12)

式中:

S2——網(wǎng)格數(shù)量;

B——錨框個(gè)數(shù);

Inoobjij——

第i個(gè)網(wǎng)絡(luò)的第j個(gè)錨框沒有目標(biāo);

Iobjij——

第i個(gè)網(wǎng)絡(luò)的第j個(gè)錨框有目標(biāo);

Cji——預(yù)測置信度;

C^ji——真實(shí)置信度;

pji——預(yù)測類別;

p^ji——真實(shí)類別;

λnoobj——損失權(quán)重系數(shù)。

2.2 輕量化試驗(yàn)對(duì)比分析

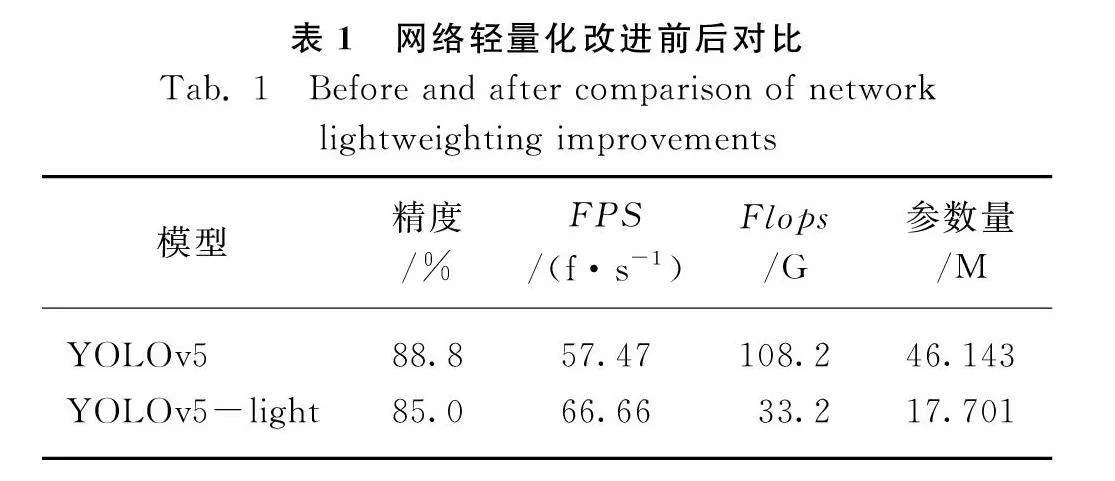

將YOLOv5特征提取網(wǎng)絡(luò)中的C3模塊替換為ShuffleNet V2基本殘差結(jié)構(gòu),CBS模塊替換為深度可分離卷積模塊,由表1可知,改進(jìn)后的輕量化網(wǎng)絡(luò)YOLOv5-light的參數(shù)量和浮點(diǎn)運(yùn)算量分別下降61.6%和75%,模型檢測速度提升了16%,但精度下降約3.8個(gè)百分點(diǎn)。

輕量化網(wǎng)絡(luò)可以有效降低模型復(fù)雜度,但同時(shí)會(huì)造成檢測精度的損失,因此為實(shí)現(xiàn)模型各方面性能的平衡,在輕量化網(wǎng)絡(luò)的基礎(chǔ)上對(duì)模型進(jìn)行優(yōu)化。

2.3 注意力機(jī)制試驗(yàn)對(duì)比分析

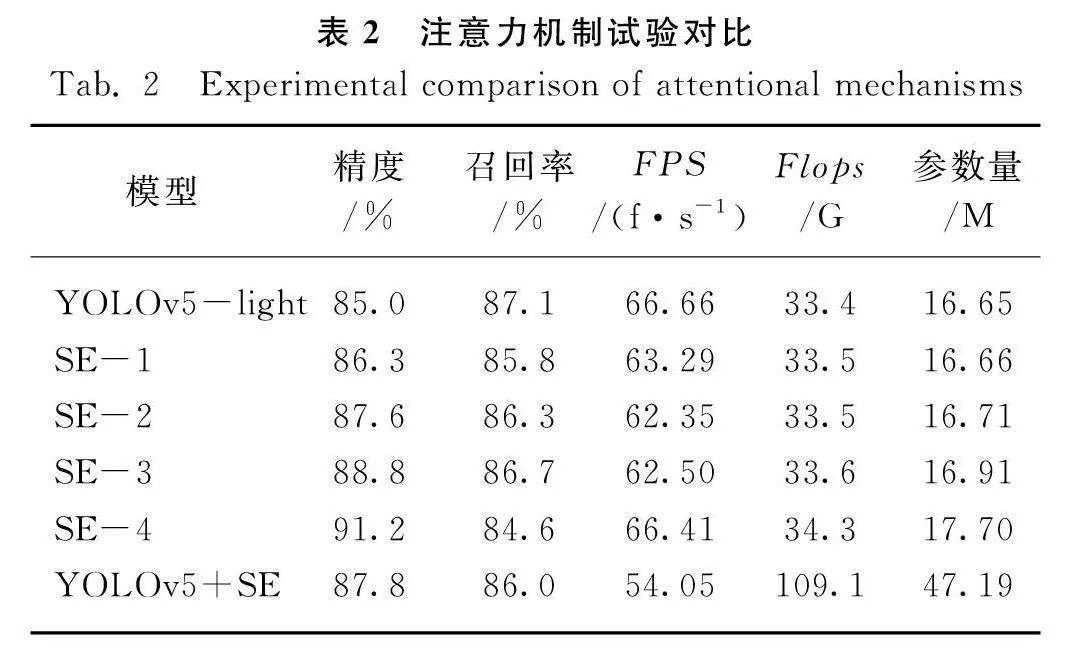

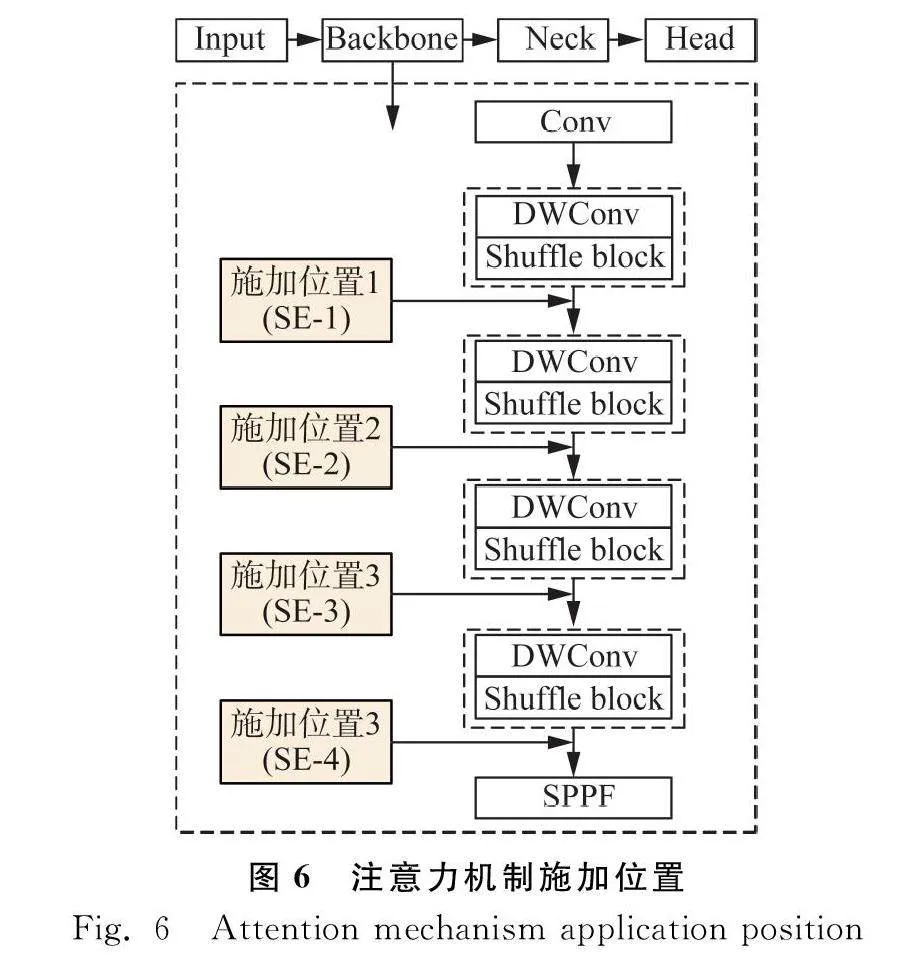

為減輕網(wǎng)絡(luò)輕量化對(duì)模型檢測精度的影響,將SE Net注意力機(jī)制引入特征提取網(wǎng)絡(luò),提高模型對(duì)黃花特征的敏感度,彌補(bǔ)輕量化網(wǎng)絡(luò)對(duì)模型檢測精度的損失。注意力機(jī)制施加在不同的位置對(duì)模型的大小和檢測性能均會(huì)有不同的影響,因此通過試驗(yàn)對(duì)比選取施加SE Net注意力機(jī)制的最佳位置。

在輕量化網(wǎng)絡(luò)的基礎(chǔ)上,將注意力機(jī)制施加在圖6所示的四個(gè)不同位置,即特征融合網(wǎng)絡(luò)每個(gè)ShuffleNet V2基本殘差結(jié)構(gòu)之后,記四個(gè)模型為分別SE-1、SE-2、SE-3和SE-4,對(duì)比不同的施加位置對(duì)模型檢測效果的影響。

如表2所示,在檢測精度方面,將SE Net注意力機(jī)制施加在位置1和位置2,模型檢測精度分別為86.3%和87.6%,相較輕量化網(wǎng)絡(luò)精度分別提高1.5%和3.0%,但仍低于原始算法;施加在位置3處,檢測精度幾乎與原始YOLOv5原始網(wǎng)絡(luò)精度相同,施加在位置4,相較原始算法模型檢測精度上升了約2.4%。

由此可知,在輕量化模型特征提取網(wǎng)絡(luò)較后的位置施加注意力機(jī)制,精度可以有更好的提升,SE Net注意力機(jī)制對(duì)細(xì)粒度特征更加敏感,位置4處于特征提取網(wǎng)絡(luò)的末端,相較前三個(gè)位置能獲取到更加豐富的特征信息,因此可以較好的提升模型檢測精度。

在YOLOv5原始網(wǎng)絡(luò)模型的基礎(chǔ)上,將SE Net注意力機(jī)制施加在特征提取網(wǎng)絡(luò)第四個(gè)C3模塊后,與圖5中的位置4相對(duì)應(yīng),模型大小和檢測性能均沒有得到改善,因此SE Net注意力機(jī)制不是必定會(huì)為模型帶來檢測性能的提升,要針對(duì)目標(biāo)檢測網(wǎng)絡(luò),選擇合適的施加位置來為模型檢測精度帶來改善。同時(shí)由表2可知,注意力機(jī)制帶來的額外參數(shù)量和運(yùn)算量較小,可以以極小的計(jì)算開銷帶來檢測精度的提升。

在模型大小和模型復(fù)雜度方面,SE-4模型的網(wǎng)絡(luò)層數(shù)、參數(shù)量以及浮點(diǎn)運(yùn)算量有明顯的輕量化特征,在檢測性能方面,SE-4有相對(duì)其他模型較高的檢測精度和檢測速度。綜上所述,將YOLOv5特征提取網(wǎng)絡(luò)中的C3模塊替換為ShuffleNet V2輕量化網(wǎng)絡(luò)基礎(chǔ)模塊,CBS模塊替換為深度可分離卷積,可以有效減少網(wǎng)絡(luò)計(jì)算量,降低模型復(fù)雜度,提升目標(biāo)檢測速度,同時(shí)在圖5所示的位置4施加SE Net注意力機(jī)制可以彌補(bǔ)輕量化網(wǎng)絡(luò)造成的精度損失,因此選取該網(wǎng)絡(luò)結(jié)構(gòu)為最終的黃花成熟度檢測模型。

2.4 目標(biāo)檢測綜合性能對(duì)比分析

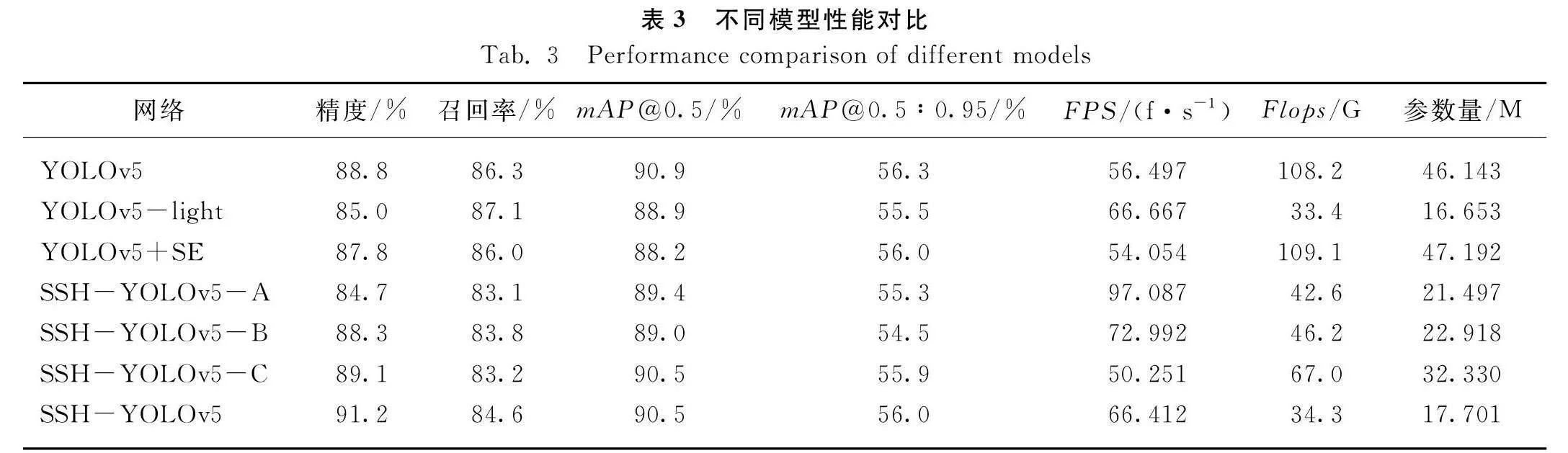

不同的網(wǎng)絡(luò)參數(shù)下模型所表現(xiàn)出的性能如表3所示,YOLOv5原始模型在黃花成熟度任務(wù)中的檢測精度較高,但網(wǎng)絡(luò)參數(shù)量大,在檢測過程中存在計(jì)算冗余問題,因此檢測速度較慢;將YOLOv5進(jìn)行網(wǎng)絡(luò)輕量化改進(jìn),改進(jìn)后的YOLOv5-light網(wǎng)絡(luò)的運(yùn)算量和參數(shù)量大幅下降,檢測速度提高了約18%,但輕量化網(wǎng)絡(luò)造成了精度的損失;在YOLOv5原始模型直接施加SE Net注意力機(jī)制,在模型大小和檢測性能方面都沒有較好的提升;在YOLOv5輕量化網(wǎng)絡(luò)的基礎(chǔ)上,將SE Net注意力機(jī)制施加在特征提取網(wǎng)絡(luò)合適的位置中,征提取網(wǎng)絡(luò)的四個(gè)輕量化殘差模塊Shuffle block_ni和特征融合網(wǎng)絡(luò)中的C3_mj模塊可以迭代使用多次,ni和mj分別表示第n個(gè)模塊使用了i次和第m個(gè)模塊使用了j次,SSH-YOLOv5模型中n1=3,n2=6,n3=6,n4=3,mj的參數(shù)均為1;SSH-YOLOv5-A模型ni和mj的參數(shù)都為1,因此模型參數(shù)量較小,但綜合檢測性能相對(duì)較差;SSH-YOLOv5-B模型中,ni的參數(shù)均為3,mj的參數(shù)均為1;SSH-YOLOv5-C模型n1=3,n2=6,n3=9,n4=3,mj的參數(shù)均為3,不僅模型參數(shù)量較大,且檢測性能不佳。

因此,綜合考慮模型的大小和檢測性能,在網(wǎng)絡(luò)輕量化和SE Net注意力機(jī)制的雙重作用下的SSH-YOLOv5擁有更輕量的網(wǎng)絡(luò)、相對(duì)較高的檢測精度和檢測速度,模型參數(shù)量和浮點(diǎn)運(yùn)算量相較原始算法分別有61.6%和86.3%的下降,實(shí)時(shí)檢測速度達(dá)到66.4f/s,檢測精度為91.2%,不僅在檢測速度提高了17.1個(gè)百分點(diǎn),同時(shí)檢測精度提升了2.7%,雖然召回率相較原始YOLOv5算法有略小幅度的下降,但總體上較好地實(shí)現(xiàn)了各方面性能的綜合平衡。

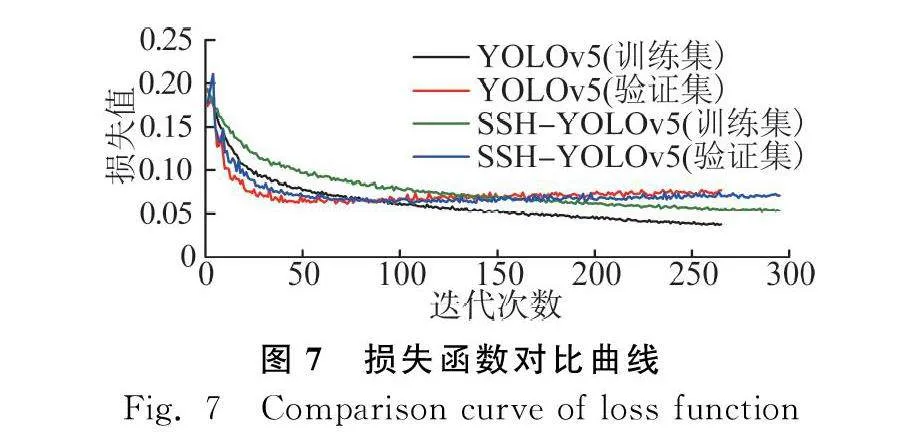

YOLOv5和SSH-YOLOv5算法在訓(xùn)練過程中的損失曲線如圖7所示,兩種算法訓(xùn)練集和驗(yàn)證集的整體損失都隨著迭代訓(xùn)練而減小,表示模型預(yù)測的結(jié)果與真實(shí)結(jié)果的差距逐漸縮小。YOLOv5和SSH-YOLOv5訓(xùn)練集損失在前50輪迅速下降,50輪到訓(xùn)練結(jié)束持續(xù)小幅度的下降,最終趨于收斂,分別穩(wěn)定在0.04左右和0.05左右;兩種算法的驗(yàn)證集的損失值在前25輪快速下降,SSH-YOLOv5驗(yàn)證集的損失曲線比原YOLOv5算法的損失曲線收斂速度更快,并且在訓(xùn)練后期損失值略低于YOLOv5,具有更好的收斂性,說明改進(jìn)后的算法具有更強(qiáng)的學(xué)習(xí)能力,對(duì)于黃花的目標(biāo)檢測有更好的檢測效果。

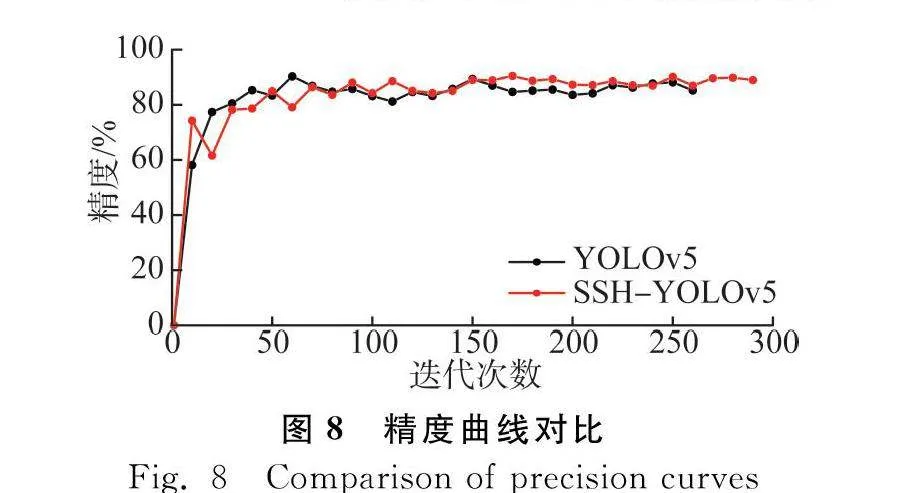

YOLOv5和SSH-YOLOv5模型訓(xùn)練精度曲線如圖8所示,可以看出在訓(xùn)練前期改進(jìn)后的算法精度較低,經(jīng)過約75次迭代訓(xùn)練后精度曲線與原始算法基本持平,最終SSH-YOLOv5的精確率明顯高于原始算法。

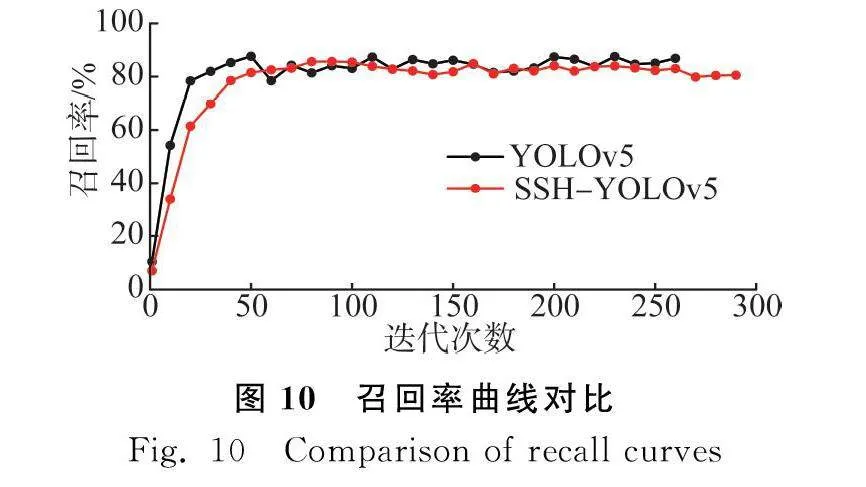

圖9是SSH-YOLOv5算法和YOLOv5算法的特定精度mAP@0.5和mAP@0.5∶0.95的曲線,兩種算法的特定精度曲線最終都趨于收斂,但在后期SSH-YOLOv5算法的曲線更加穩(wěn)定。召回率曲線如圖10所示,SSH-YOLOv5的召回率比YOLOv5略低,改進(jìn)后的輕量化網(wǎng)絡(luò)的特征提取網(wǎng)絡(luò)和頸部網(wǎng)絡(luò)的層數(shù)比YOLOv5原始算法有所減少,會(huì)丟失部分特征信息,相對(duì)容易錯(cuò)誤區(qū)分背景與目標(biāo),因此召回率有小幅下降。

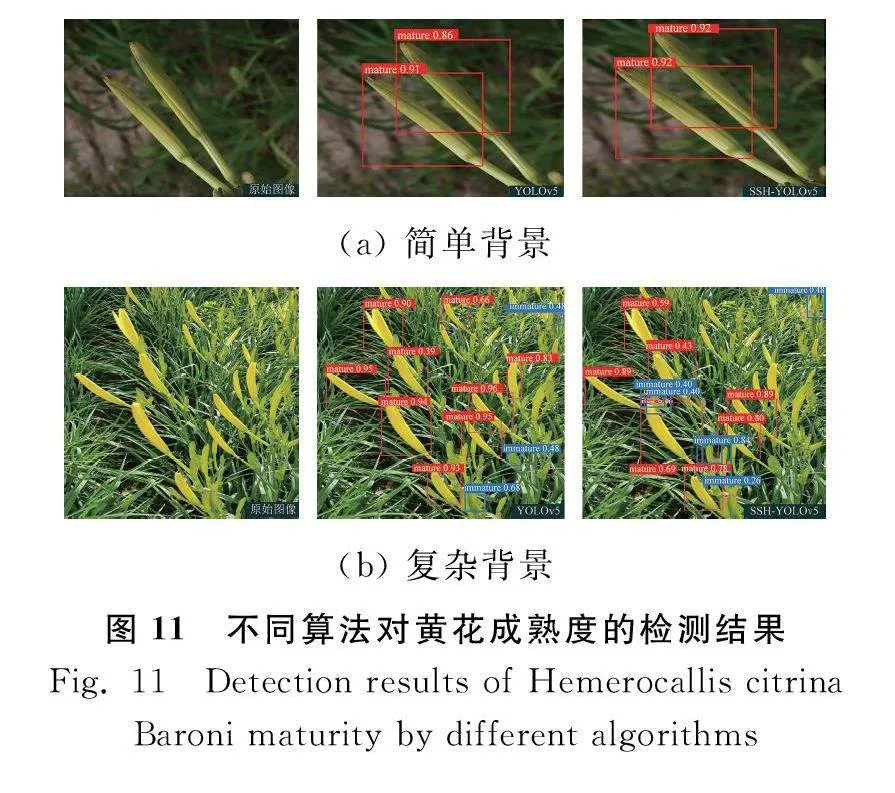

由圖11可知,在不同環(huán)境下SSH-YOLOv5算法都表現(xiàn)出較好的檢測性能,在簡單場景中,改進(jìn)后的算法對(duì)較大的成熟黃花目標(biāo)有更高的置信度,誤檢和漏檢的情況較少;在復(fù)雜環(huán)境下,黃花目標(biāo)重疊,部分未成熟的黃花與背景枝葉顏色相近,YOLOv5和SSH-YOLOv5算法都有較好的檢測效果,YOLOv5對(duì)小目標(biāo)更加敏感,而SSH-YOLOv5能夠正確檢測到更多的目標(biāo)。

因此,經(jīng)過試驗(yàn)可以驗(yàn)證所提方法有較好的檢測性能和魯棒性,不僅可以滿足嵌入式平臺(tái)對(duì)網(wǎng)絡(luò)的輕量化要求,同時(shí)在速度和精度上有更好的表現(xiàn),能夠完成自然背景下的黃花成熟度檢測任務(wù)。

3 結(jié)論

1)" 針對(duì)黃花采摘對(duì)檢測網(wǎng)絡(luò)的輕量化要求,提出一種SSH-YOLOv5黃花檢測算法,通過改進(jìn)YOLOv5的特征提取網(wǎng)絡(luò)和頸部網(wǎng)絡(luò),減少模型的復(fù)雜度和計(jì)算量,同時(shí)將模型的檢測精度和速度分別提高2.7個(gè)和18.1個(gè)百分點(diǎn)。

2)" 將特征提取網(wǎng)絡(luò)的C3模塊替換為輕量化網(wǎng)絡(luò)ShuffleNet V2模塊,使用深度可分離卷積降低計(jì)算量,同時(shí)施加SE Net注意力機(jī)制,減少因網(wǎng)絡(luò)輕量化以及復(fù)雜背景對(duì)檢測精度的負(fù)面影響,并對(duì)比不同注意力施加位置、不同網(wǎng)絡(luò)深度的檢測效果,選取最佳注意力施加位置和網(wǎng)絡(luò)深度,綜合考慮各項(xiàng)網(wǎng)絡(luò)性能評(píng)價(jià)指標(biāo),最終提出SSH-YOLOv5黃花成熟度檢測算法。試驗(yàn)結(jié)果表明,改進(jìn)后的輕量化算法可以滿足對(duì)黃花實(shí)際采摘需求。

參 考 文 獻(xiàn)

[1]馬聰, 陳學(xué)東. 黃花菜采摘機(jī)器人視覺系統(tǒng)研究[J]. 寧夏農(nóng)林科技, 2021, 62(12): 60-64.

Ma Cong, Chen Xuedong. Vision system of daylily picking robot [J]. Ningxia Journal of Agriculture and Forestry Science and Technology, 2021, 62(12): 60-64.

[2]鄭太雄, 江明哲, 馮明馳. 基于視覺的采摘機(jī)器人目標(biāo)識(shí)別與定位方法研究綜述[J]. 儀器儀表學(xué)報(bào), 2021, 42(9): 28-51.

Zheng Taixiong, Jiang Mingzhe, Feng Mingchi. Vision based target recognition and location for picking robot: A review [J]. Chinese Journal of Scientific Instrument, 2021, 42(9): 28-51.

[3]岑海燕, 朱月明, 孫大偉, 等. 深度學(xué)習(xí)在植物表型研究中的應(yīng)用現(xiàn)狀與展望[J]. 農(nóng)業(yè)工程學(xué)報(bào), 2020, 36(9): 1-16.

Cen Haiyan, Zhu Yueming, Sun Dawei,et al. Current status and future perspective of the application of deep learning in plant phenotype research [J]. Transactions of the Chinese Society of Agricultural Engineering, 2020, 36(9): 1-16.

[4]趙立新, 邢潤哲, 白銀光, 等. 深度學(xué)習(xí)在目標(biāo)檢測的研究綜述[J]. 科學(xué)技術(shù)與工程, 2021, 21(30): 12787-12795.

Zhao Lixin, Xing Runzhe, Bai Yinguang, et al. Review on survey of deep learning in target detection [J]. Science Technology and Engineering, 2021, 21(30): 12787-12795.

[5]Girshick R, Donahue J, Darrell T, et al. Region based convolutional networks for accurate object detection and segmentation [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(1): 142-158.

[6]Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real time object detection with region proposal networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 39(6): 1137-1149.

[7]Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multi box detector [C]. European Conference on Computer Vision, 2016: 21-37.

[8]Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016: 779-788.

[9]Redmon J, Farhadi A. YOLO9000: Better, faster, stronger[C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 7263-7271.

[10]Redmon J, Farhadi A. YOLOv3: An incremental improvement [C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018.

[11]董文軒, 梁宏濤, 劉國柱, 等. 深度卷積應(yīng)用于目標(biāo)檢測算法綜述[J]. 計(jì)算機(jī)科學(xué)與探索, 2022, 16(5): 1025-1042.

Dong Wenxuan, Liang Hongtao, Liu Guozhu, et al. Review of deep convolution applied to target detection algorithms [J]. Journal of Frontiers of Computer Science and Technology, 2022, 16(5):1025-1042.

[12]朱紅春, 李旭, 孟煬, 等. 基于Faster R-CNN網(wǎng)絡(luò)的茶葉嫩芽檢測[J]. 農(nóng)業(yè)機(jī)械學(xué)報(bào), 2022, 53(5): 217-224.

Zhu Hongchun, Li Xu, Meng Yang, et al. Tea bud detection based on Faster R-CNN network [J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(5): 217-224.

[13]岳有軍, 孫碧玉, 王紅君, 等. 基于級(jí)聯(lián)卷積神經(jīng)網(wǎng)絡(luò)的番茄果實(shí)目標(biāo)檢測[J]. 科學(xué)技術(shù)與工程, 2021, 21(6): 2387-2391.

Yue Youjun, Sun Biyu, Wang Hongjun, et al. Object detection of tomato fruit based on cascade RCNN [J]. Science Technology and Engineering, 2021, 21(6): 2387-2391.

[14]湯旸, 楊光友, 王焱清. 面向采摘機(jī)器人的改進(jìn)YOLOv3-tiny輕量化柑橘識(shí)別方法[J]. 科學(xué)技術(shù)與工程, 2022, 22(31): 13824-13832.

Tang Yang, Yang Guangyou, Wang Yanqing. Improved YOLOv3-tiny lightweight citrus recognition method for picking robot [J]. Science Technology and Engineering, 2022, 22(31): 13824-13832.

[15]王卓, 王健, 王梟雄, 等. 基于改進(jìn)YOLOv4的自然環(huán)境蘋果輕量級(jí)檢測方法[J]. 農(nóng)業(yè)機(jī)械學(xué)報(bào), 2022, 53(8): 294-302.

Wang Zhuo, Wang Jian, Wang Xiaoxiong, et al. Lightweight real-time apple detection method based on improved YOLOv4 [J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(8): 294-302.

[16]Zhang L, Wu L, Liu Y. Hemerocallis citrina Baroni maturity detection method integrating lightweight neural network and dual Attention mechanism [J]. Electronics, 2022, 11(17): 2743.

[17]鄧穎, 吳華瑞, 朱華吉. 基于實(shí)例分割的柑橘花朵識(shí)別及花量統(tǒng)計(jì)[J]. 農(nóng)業(yè)工程學(xué)報(bào), 2020, 36(7): 200-207.

Deng Ying, Wu Huarui, Zhu Huaji. Recognition and counting of citrus flowers based on instance segmentation [J]. Transactions of the Chinese Society of Agricultural Engineering, 2020, 36(7): 200-207.

[18]宋爽, 張悅, 張琳娜, 等. 基于深度學(xué)習(xí)的輕量化目標(biāo)檢測算法[J]. 系統(tǒng)工程與電子技術(shù), 2022, 44(9): 2716-2725.

Song Shuang, Zhang Yue, Zhang Linna, et al. Lightweight target detection algorithm based on deep learning [J]. Systems Engineering and Electronics, 2022, 44(9): 2716-2725.

[19]李東升, 胡文澤, 蘭玉彬, 等. 深度學(xué)習(xí)在雜草識(shí)別領(lǐng)域的研究現(xiàn)狀與展望[J]. 中國農(nóng)機(jī)化學(xué)報(bào), 2022, 43(9): 137-144.

Li Dongsheng, Hu Wenze, Lan Yubin, et al. Research status and prospect of deep learning in weed recognition [J]. Journal of Chinese Agricultural Mechanization, 2022, 43(9): 137-144.

[20]Ma N, Zhang X, Zheng H, et al. Shuffle Net v2: Practical guidelines for efficient CNN architecture design[C]. European Conference on Computer Vision, 2018: 116-131.

[21]Zhang X, Zhou X, Lin M, et al. Shuffle Net: An extremely efficient convolutional neural network for mobile devices [C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018: 6848-6856.

[22]Andrew G Howard, Zhu M, Chen B, et al. Mobilenets: Efficient convolutional neural networks for mobile vision applications [J]. Computer Vision and Pattern Recognition, 2017.

[23]Sandler M, Howard A, Zhu M, et al. Mobilenetv2: Inverted residuals and linear bottlenecks [C]. IEEE Conference on Computer Vision and Pattern Recognition, 2018: 4510-4520.

中國農(nóng)機(jī)化學(xué)報(bào)2024年7期

中國農(nóng)機(jī)化學(xué)報(bào)2024年7期

- 中國農(nóng)機(jī)化學(xué)報(bào)的其它文章

- 傳統(tǒng)農(nóng)具造物美學(xué)價(jià)值挖掘及當(dāng)代應(yīng)用研究

- 農(nóng)業(yè)綠色技術(shù)研究進(jìn)展、熱點(diǎn)與展望

- 農(nóng)業(yè)機(jī)械化可以解決農(nóng)業(yè)勞動(dòng)力短缺嗎?

- 鄉(xiāng)村振興戰(zhàn)略背景下促進(jìn)農(nóng)民增收的個(gè)性化研究

- 生計(jì)分化下農(nóng)戶低碳生產(chǎn)技術(shù)采納行為績效研究

- 生態(tài)農(nóng)業(yè)培訓(xùn)效果的耦合協(xié)調(diào)度研究