融合圖像語義的動態視頻拼接方法

楊 毅,王冬生,宋文杰,付夢印

(北京理工大學自動化學院,北京 100081)

0 引 言

隨著機器人技術的進步與發展,機器人對于視覺信息的需求越來越高,普通攝像頭受限于視場角,全方位相機又存在分辨率過低且拍攝死角較大等問題,而圖像拼接技術能夠將多個的圖像拼接成一幅大視場圖像,可以更準確地檢測和追蹤圖像中的目標[1]。視頻拼接是圖像拼接的技術延伸,其對拼接的實時性、連續性、魯棒性有更高的要求,在視頻監控和無人駕駛系統中有重要的應有價值。

圖像拼接作為視頻拼接技術的基礎,按照拼接模式可以分為兩類。第一類是以文獻[2]為代表的通過估計全局2D投影變形來對齊輸入圖像的拼接模式[2],該模式主要利用一個全局3×3單應矩陣將多張圖像對齊到同一坐標平面[3],并使用多頻帶融合算法獲取大場景拼接圖像,但這類方法是基于拍攝內容近似處于同一個平面的假設實現,對于不滿足假設的情況,由于全局投影模型不一致,會導致拼接圖像出現重影或模糊等問題。第二類是利用多個局部單應矩陣對齊圖像的模式[4-9],代表方法是文獻[7]在2015年國際計算機視覺與模式識別會議上提出自適應圖像拼接方法(adaptive as-natural-as-possible,AANAP)[7],該方法將圖像劃分為密集網格,每個網格都計算出一個單應矩陣。并將局部單應性與全局相似性變換組合,根據圖像目標自動估計出所有參數。這類方法可以允許一定程度的局部視差,但由于引入網格的形變估計,極大增加了計算成本,拼接一張圖需要十幾秒甚至幾分鐘,不能直接應用到視頻拼接算法中。為了降低拼接的計算成本,本文從當前圖像拼接技術出發,將圖像分為上下兩個半平面,用兩個局部單應矩陣擬合,在局部視差允許的情況下,加快算法的處理速度。

目前視頻拼接按相機設置和應用場景可以分為3大類,第1類是靜態場景下攝像機間幾何關系固定的拼接方法[10-11],該類方法由于應用環境比較單一,只需預先標定校準一次攝像機間的位置,然后輔助過渡區域局部融合算法,就能夠實現實時的圖像拼接。第2類是運動環境下攝像機間幾何關系固定的拼接方法[12-14],該類方法同第1類相似,也需要預先標定好攝像機之間的幾何關系,但由于應用于運動環境,環境所屬平面變化時都會不可避免地產生局部視差。第3類是靜態和運動環境下攝像機間相互獨立的拼接方法[15-17],該類方法主要應用于非剛性固連的攝像機組,例如手持攝像設備,懸掛式拖車環視設備等,由于輸入設備之間的位置關系不確定性,場景投影平面時變性,需要實時校準標定參數。對于手持設備拍攝的離線視頻,為了實現更好的拼接效果,視頻需作平滑運動軌跡的穩定處理[16]。對于在線拼接方法,由于無法預知相機運動軌跡,很難獲取滿意的拼接圖像,本文采用基于拼接質量反饋的方法優化拼接結果。

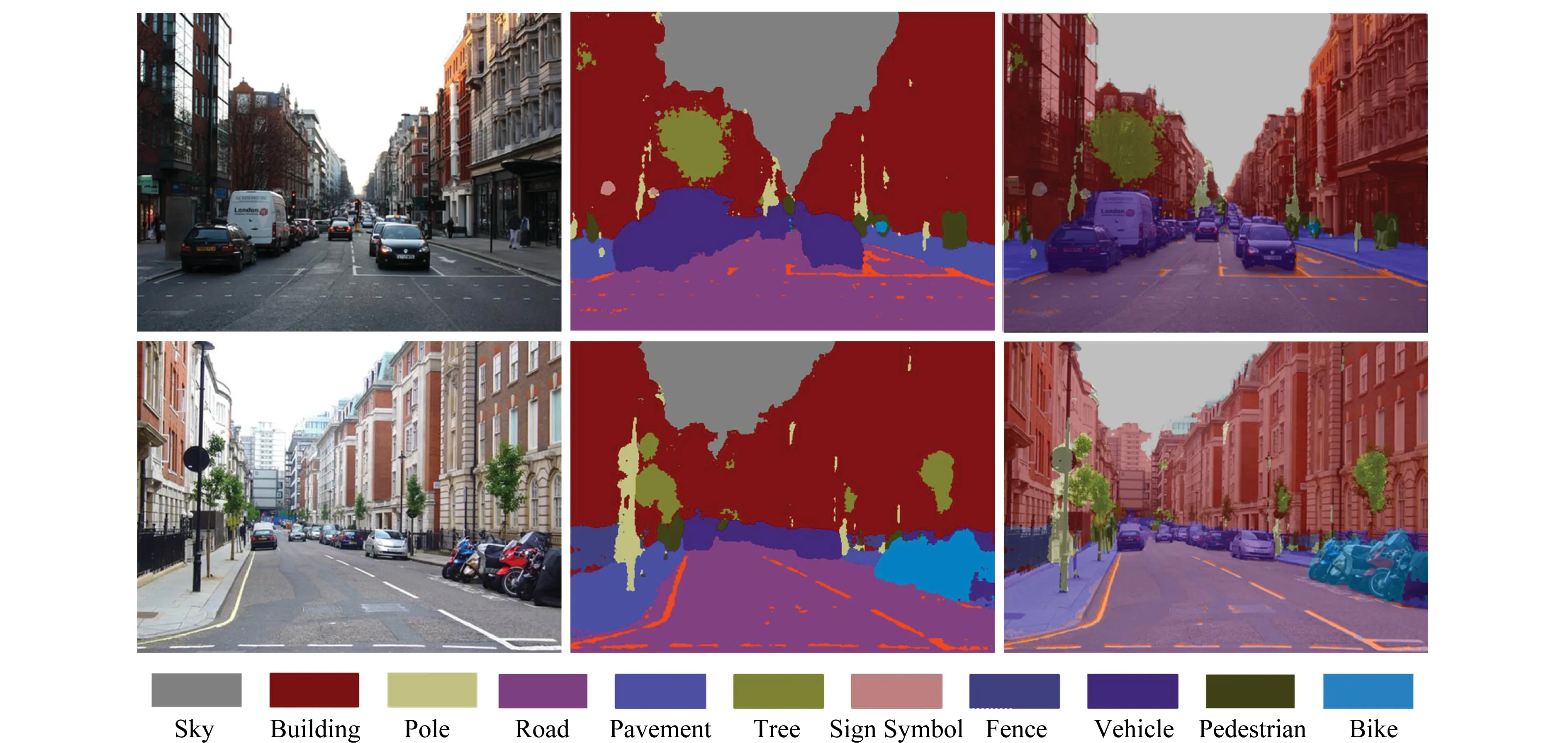

圖像語義分割技術是指使用一定的分類方法對圖像進行像素分類。在深度學習應用到計算機視覺領域之前,人們使用紋理基元森林(texton forest,TF)和隨機森林(random forest,RF)分類器進行語義分割,隨后提出的卷積神經網絡極大地促進了語義分割領域的發展。文獻[18]提出了用于語義分割的全卷積網絡(fully convolutional networks,FCN),FCN主要使用了卷積化、上采樣、跳躍結構等技術,改善了語義分割的結果,將端對端的卷積網絡應用到語義分割領域,這使得卷積神經網絡無需全連接層即可進行密集的像素分類,使用這種方法可生成任意大小的分割圖,在這之后,語義分割領域幾乎所有先進方法都采用了該模型。2015年文獻[19]提出一種用于圖像分割的深度卷積編碼器-解碼器架構(A deep convolutional encoder-decoder architecture for image segmentation,SegNet),包含一個編碼網絡和對應的解碼網絡,并跟隨一個像素級別的分類層。編碼層由13個卷積層構成,其作用是提取圖像特征,解碼器網絡將低分辨率的特征圖譜還原到輸入圖像的分辨率,可以處理任意大小的輸入圖像并輸出相同大小的分割圖。在FCN中,盡管使用了解卷積層和一些跳躍連接,但輸出的分割圖仍然比較粗糙,SegNet沒有復制FCN 中的編碼器特征,而是復制了最大池化索引,只存儲特征映射的最大匯集指數,這使得SegNet比 FCN更節省內存,效率更高,其在城區場景理解方面效果表現明顯,因此本文采用文獻[19]提供的SegNet 語義模型對城市環境進行語義分割,圖1為語義分割效果圖。

圖1 語義分割效果圖Fig.1 Effect of the Semantic segmentation

綜上所述,圖像語義分割結果可以提供圖像的高階語義信息,對環境有更高的解析,但該技術還未曾應用到視頻拼接領域。為了提高現有視頻拼接技術的準確性與魯棒性,本文提出一種融合圖像語義信息的在線動態視頻拼接方案。

1 系統框架

為了加快拼接速度,本文采用多線程方式分時并行處理拼接過程,拼接系統由主線程、特征配準線程、特征評價線程3部分組成,系統框架如圖2所示。主線程的主要步驟包括:圖像預處理、圖像降采樣、圖像語義分割、單應矩陣預測模型更新、拼接質量優化、圖像融合等。其中圖像預處理是指利用改進的張正友棋盤格標定算法[20]校正原始圖像的圖像畸變;圖像語義分割前需要先將原圖降采樣到360×480大小,然后利用語義模型(本文采用文獻[19]提供的SegNet城區語義模型)對圖像進行語義分割,可將街道圖像像素點分為11類,最后得到與原始圖像相同尺寸的語義圖,結果如圖1所示。在第1次圖像畸變矯正后初始化特征配準線程,該線程主要作用是求解拼接所需的單應性投影模型。

圖2 本文視頻拼接算法流程圖Fig.2 Video stitching algorithm flowchart in this paper

在拼接評價線程中,本文通過投影變換將待配準圖投影到參考圖平面上,并對兩圖重疊區域處的語義、紋理、色彩等信息進行相似度分析,獲得拼接結果的定量評估。主線程能夠實時檢測拼接評價線程的量化評價結果,判斷是否需要優化拼接,當拼接質量評價結果大于設定的評價閾值Th時融合對齊的圖像,最終輸出拼接圖;否則,利用單應矩陣預測模型預測當前單應矩陣,達到優化拼接結果得目的。當拼接評價線程接收到來自主線程的優化拼接請求時,會利用優化的單應矩陣重新對齊圖像。在n次優化嘗試后,輸出評價質量最高的一組對齊結果。假設單應矩陣在一段時間內是線性變化的,該模型可以表示為

(1)

式中,H(t)表示當前時刻計算出的單應矩陣;HC(t)表示利用模型預測出的當前單應矩陣;score表示拼接評價評估結果;T(l)指第l-1次到第l次單應矩陣計算的時間間隔,本文僅利用最近十次的數據進行預測。

本小節介紹了融合圖像語義的自適應動態視頻拼接方法系統框架和主線程的主要步驟,提出了利用拼接評價結果實現基于歷史拼接信息的拼接參數預測。

2 特征匹配

圖像特征匹配,是指利用一定方法將多幅圖像的相似特征進行匹配,是圖像對齊的前提,匹配的準確度直接影響到圖像拼接的質量。

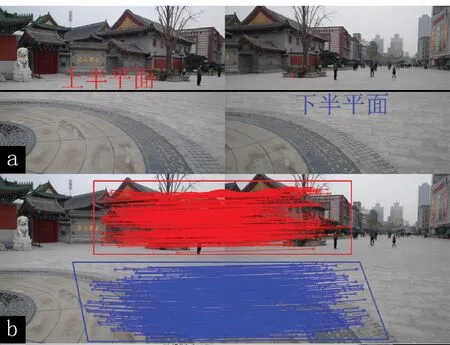

為了解決全局投影模型不一致的問題,本文將圖像場景劃分為上下兩個半平面,分別提取兩個半平面(見圖3(a))內的特征點,并對特征點進行配準(見圖3(b)),計算出相應的兩個單應矩陣。

圖3 場景局部匹配圖Fig.3 Scene partial area matching map

本文匹配流程如圖2特征配準線程所示,以圖4為例說明。首先使用David Lowe提出的具有尺度不變性的加速穩健特征(speeded-up robust features,SURF)算法提取特征點如圖4(a)所示。該算法利用Harr特征以及積分圖像加速特征提取過程,能實時提取特征點并為特征點計算位置和尺度信息,最終生成一個64維的SURF特征描述符,包括采用Henssian矩陣獲取圖像局部最值和利用Harr小波特征求取的特征點的主方向。然后使用快速最近鄰搜索包(fast library for approximate nearest neighbors,FLANN)匹配方法直接對原始圖SURF特征進行匹配,再使用k-最近鄰算法(k-nearest neighbor,KNN)篩選匹配點后的匹配結果,結果顯示存在大量誤匹配,如圖4(b)所示,主要集中在鄰域信息相近但語義不同的像素點對之間。

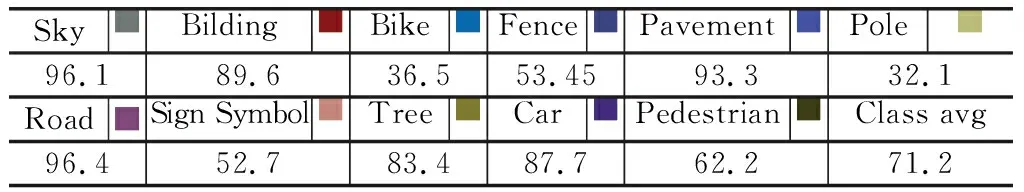

傳統方法僅使用特征向量歐式距離的相似度進行匹配,由于沒有考慮到點自身的高階語義屬性,不可避免地會產生一些錯誤匹配,因此本文提出一種融合圖像高階語義的匹配算法,旨在增加匹配正確率。給定紅綠藍通道(red,green,blue,RGB)圖像,X={x1,x2,…,xN}對應于所有圖像像素的集合,N為圖像像素點數量,待配準圖與參考圖像素集合分別用XM,XR表示。圖像語義分割后對原圖每個像素指定預定義的類,如圖4(c)所示,分割提取的高階語義信息基本與實際物體所屬類別一致,以不同顏色標記不同類像素,標簽集合L={l1,l2,…Ij…,lC},j∈{1,2,…,C},C表示對象類標簽的個數,由于語義分割的結果存在分類誤差,本文用PLj表示像素分割為語義標簽j的準確度,表1說明了語義標簽的準確度。

圖4(d)部分是本文提出的融合圖像高階語義信息圖像特征匹配方法在場景I下的效果圖,可以看出,本文的方法能夠剔除圖像中大量的誤匹配,提高匹配正確率的同時優化匹配點數量。在分析過程中為了增加實驗的可信度本文對包含場景I的5個不同場景進行分析測試。

圖4 本文匹配方法效果圖Fig.4 Matching method in this paper

表1 文獻[19]模型語義標注正確率Table 1 Semantic annotation accuracy of model in[19]

本文使用語義分割產生的像素級語義標簽對傳統基于特征向量歐氏距離的匹配方法進行擴展,將語義分割結果與圖像特征匹配對集合M={m1,m2}相關聯,其中m1表示正確匹配對集合,m2表示錯誤匹配對集合。特征匹配過程表示為

P(mij∈m1)=ω1φij+ω2φ(xi,xj)

(2)

式中,1≤i,j≤N,xi∈XM,xj∈XR;mij為點xi與點xj組成的特征匹配對;當概率P(mij∈m1)大于匹配閾值Mth時認為該匹配是正確的;ω表示各項權值,ω1+ω2=1;φ(xi,xj)表示匹配點對應特征向量歐式距離相似概率;φ表示匹配對屬于同一語義分類的概率,表示為

(3)

式中,seg(xj)表示對像素xj進行語義分割后的分類結果,由于匹配點對的語義分割結果同時錯誤的概率很小,本文僅考慮圖像單個像素語義分類誤差。匹配點對特征向量歐式距離的相似度可以用匹配點間歐式距離與匹配集合中相關匹配歐式距離集合中次最小值的關系來確定,即

φij(xi,xj)=

(4)

式中,Min2表示取集合中次最小值的函數;Disij為點xi與點xj所組成匹配對的歐式距離,匹配對的歐式距離越近,φij(xi,xj)的值越大,匹配正確的概率越高,歐式距離的計算方法為

(5)

傳統匹配方法中僅用到式(5),當最小歐式距離與次最小歐式距離的比值小于設定閾值時,認為特征點與對應的最小歐式距離的特征點是匹配的,但匹配過程僅利用了特征點的鄰域點信息,文獻[21-22]提出結合圖像的紅外光優化配準算法,并取得了一定成果,但紅外采集設備的引入,帶來了數據同步困難和經費成本增加等問題。本文提出的融合高階語義信息的特征匹配方法能夠充分結合圖像自身的語義屬性,優化配準算法,提高匹配正確率。

3 拼接質量評價

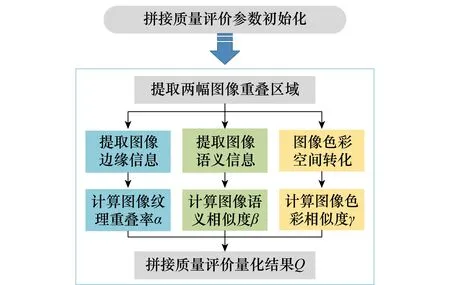

拼接質量評價本質是對拼接圖與參考圖的重疊區域進行圖像相似度評價,傳統評價法僅從圖像的色彩、紋理等幾何特征角度分析,而沒有考慮目標的語義屬性。本文將圖像語義信息與傳統的圖像幾何信息相融合,提出一種融合圖像語義的圖像拼接質量評價方法,結果更符合人眼實際評價標準,實現流程如圖5所示。

圖5 本文拼接評價算法流程圖Fig.5 Stitching evaluation algorithm flowchart in this paper

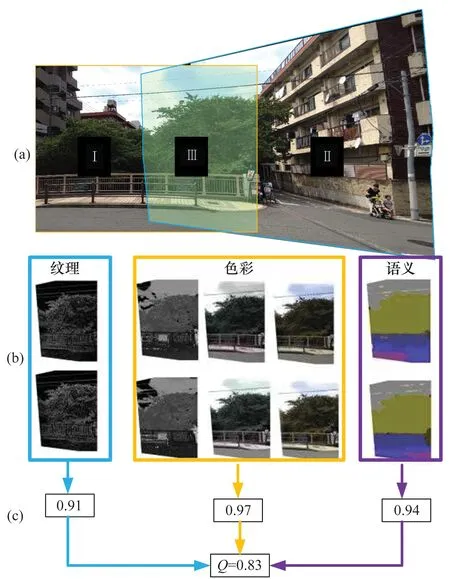

本文評價算法主要從圖像的紋理、色彩、語義3方面出發,綜合考慮圖像在這3方面的相似程度,最終計算出更為符合人眼視覺的評價結果Q,圖6是一個具體場景下的示意圖。

圖6 拼接質量評價示意圖Fig.6 Stitching quality evaluation

在利用兩個單應矩陣變形對齊圖像后,分別提取待配準圖與參考圖中的重疊感興趣區域(圖6(a) Ⅲ區域),用IM與IR表示,然后分別提取圖IM與圖IR的紋理信息、語義信息、色彩信息等,并計算相似度。其中邊緣紋理信息的提取方法是先對原始圖進行灰度化處理,按照Y=0.3R+0.59G+0.11B轉換方法將三通道的RGB圖像轉化為單通道的灰度圖像。然后采用兩個3×3的高斯卷積核對圖像做平面卷積處理,得到橫向與縱向的亮度差分近似值,再結合橫向與縱向的亮度差分近似值計算出圖像中每個點的近似梯度,最后,對圖像進行二值化處理進而獲取邊緣檢測圖[23],其計算過程為

(6)

(7)

則重疊率計算方法為

(8)

式中,sum(I)表示圖像Ⅰ中所有像素點的灰度值總和,經過計算可以獲取IM_D與IR_D邊緣紋理的重疊率α(見圖6(c))。

經過語義分割圖IM與IR后可以獲取相應的語義圖IM_S與IR_S(見圖6(b))。語義分割的結果使得圖像中每個像素具有不同的語義強度,但分割結果也存在著分類誤差。基于以上信息考慮,圖像語義相似度檢測方法可參考紋理邊緣重疊率的計算方法,求取語義圖IM_S與IR_S的相似匹配圖IS,過程為

(9)

則相似率的計算方法為

(10)

其中,sum_ele(I)表示圖像Ⅰ中所有非零像素點數量總和,經過計算可以獲取語義圖IM_S與IR_S語義相似度β(見圖6(c))。

對于圖像來說,色調飽和度明暗通道(hue,saturation,value,HSV)色彩空間比RGB色彩空間更能直觀地表達色彩的明暗、色調以及鮮艷程度,面對光照的變化更穩定[24],本文通過研究相同顏色在不同色彩空間下的表征方法,將HSV與CIE 1976(L*,a*,b*)色彩空間相結合對圖像的色彩進行分割。為了減少光照以及圖像亮度對檢測的影響,在色彩分割之前需要對圖像IM與IR進行相應的預處理,采用均衡化方法處理圖像的RGB通道直方圖,加強色彩效果,然后通過對通道H以及通道A、B的顏色信息進行分析如圖6(b)所示,計算圖像IM與IR的色彩匹配圖IC,過程為

(11)

根據物體色彩在圖像中平滑過渡的特點,對不同的色彩空間,用高斯核定義HSV的H通道項與LAB通道的A、B通道項,其表達形式為

(12)

式中,H(x,y)表示HSV空間下H通道在點(x,y)處的像素值;A(x,y)與B(x,y)則分別表示LAB空間下A與B通道在點(x,y)處的像素值;σH,σA和σB控制高斯核的影響,其值設定為H、A、B通道的強度變化幅值;每個核l(k)(x,y)由ω(k)加權。計算結果傾向于將相同位置下色彩變化不明顯的點作為相似點處理,有助于色彩相似度的檢測,最終色彩相似度γ的計算方法為

(13)

由于圖像相似程度與圖像的紋理、語義、色彩等特征直接相關,因此本文用Q=αβγ表示計算出的圖像拼接質量評價結果。

4 實驗與分析

本文在Liunx系統下通過c++編程實現了提出的方法,并在配置為2.8GHz CPU、16G RAM 和低耗版GTX-1050Ti的筆記本上進行實驗。從融合語義的匹配準確性、拼接質量評價客觀性以及自適應拼接的算法效率出發,做了相關的實驗。

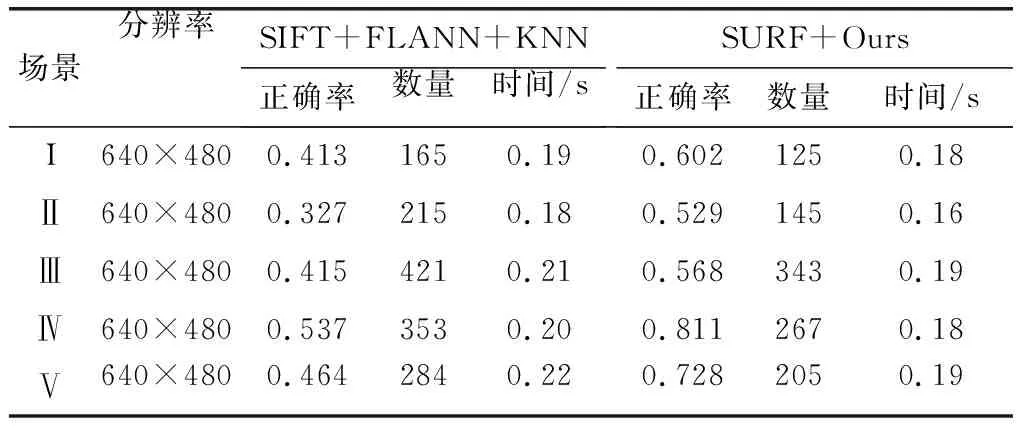

4.1 融合語義的圖像特征匹配

在驗證融合圖像語義匹配方法的實驗中,本文使用文獻[5-7]提供的5個場景的圖像數據進行特征匹配實驗,場景如圖7所示。在提取特征之前,本文將圖片都轉化為640×480大小,本文和文獻[17]都采用SURF算法提取圖像特征,該算法相比于傳統尺度不變特征變換(scale-invariant feature transform,SIFT)方法同樣具有尺度旋轉不變性,但其計算效率快了一個數量級,能夠高效地提取特征。文獻[17]匹配的算法采用的是FLANN,結合KNN匹配對篩選算法,匹配結果存在大量誤匹配,主要集中在不同類但特征相似的像素點對之間。本文從匹配正確率、匹配數量、匹配時間出發,對文獻[17]與本文提出的匹配方法進行對比實驗,結果如表2所示,根據調試經驗,閾值Dth設為經驗值0.7,Mth設為經驗值0.8。

表2 5個場景下匹配算法的性能比較Table 2 Comparison of matching algorithms in five scenes

在比較不同特征匹配方法準確度實驗中,本文使用隨機抽樣一致(random sample consensus,RANSAC)算法,通過計算不同投影模型M的投影誤差,得到誤差閾值范圍內的內點集I,通過k次迭代,k=ln(1-p)/ln(1-wm),求取最優投影模型MB使得其內點集中元素最多,式中p為置信度,設為0.999;w為內點所占比例,設為0.3;m為最小樣本數,設為4;誤差閾值設為3。因此在迭代了850次后,此時在內點集中的匹配點對認為是正確匹配的,通過計算正確匹配點在不同方法產生匹配對集合中所占的比例,得出匹配準確度。表2的結果顯示,本文提出的方法與文獻[17]中使用的方法相比,獲取的匹配對數量相近,但匹配準確性卻提高了50%左右,這使得本文的方法在迭代次數相同的情況下能夠更準確且快速地計算出圖像間的單應矩陣。

由于引入了圖像語義信息,圖像中大量的誤匹配被剔除掉,在提高匹配精度的同時優化匹配點數量,縮短了單應矩陣的計算時間。

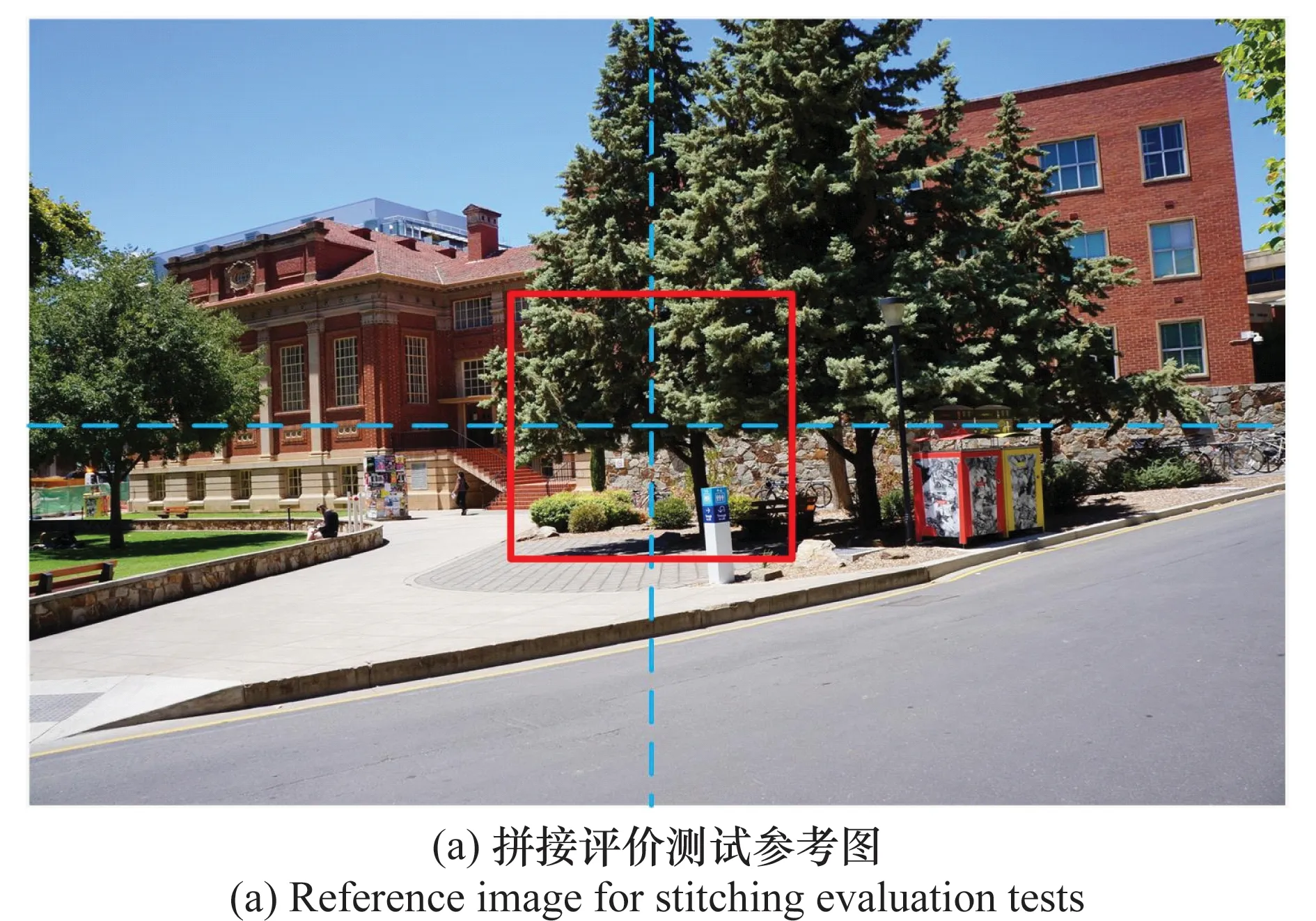

4.2 融合圖像語義拼接質量評價方法

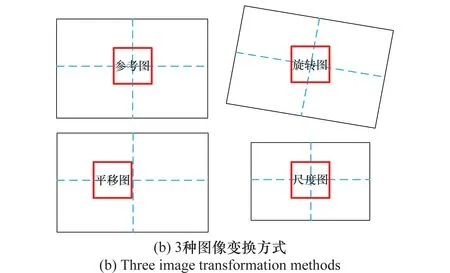

本文提出的拼接質量評價方法本質是對兩幅圖像的相似度進行評估,而圖像對齊效果直接影響到拼接的質量。單應性是指從一個平面q到另一個平面Q的映射,可以表示為q=sMWQ,式中單應矩陣表示為H=sMW,其中s表示尺度的比例系數;M表示相機的內參數矩陣;W=[Rt]表示由旋轉平移組成的物理變換矩陣。實驗在大小為1 600×1 200的圖像中進行(見圖7),選取圖8(a)中400×400紅色窗口內圖像作為參考圖,由于相機內參數矩陣在相機標定后不會變化,假設相機內參已經標定。本實驗在充分考慮拼接過程中出現誤差原因的基礎上,對圖8(a)中圖像在不同尺度、旋轉以及平移參數下進行變換,并利用同一位置相同大小的窗口產生3組數量為400的圖像序列,過程如圖8(b)所示,利用4種圖像相似度計算方法進行圖像檢索實驗。

圖7 5個測試場景Fig.7 Five tested scenes

圖8 生成圖像測試序列Fig.8 Generating the image test sequence

除本文方法外,另外3種圖像相似度計算方法如下。

(1) 峰值信噪比

峰值信噪比(peak signal to noise ratio,PSNR)是一種全參考的客觀圖像相似度評價指標,該方法計算的是兩幅圖像間均方誤差相對于最大信號平方的對數值,結果數值越大兩個圖像間的相似程度越高。

(2) 結構相似性

結構相似性(structural similarity index,SSIM)是一種全參考的圖像相似度評價指標,該方法分別從圖像的亮度、對比度、結構3方面度量圖像相似性[25],更符合人眼視覺感受。

(3) 感知哈希

哈希方法描述了一類可比較的哈希函數,該方法提取圖像的低頻信息作為比較內容,對圖像的尺寸、對比度、亮度具有良好的魯棒性[26]。

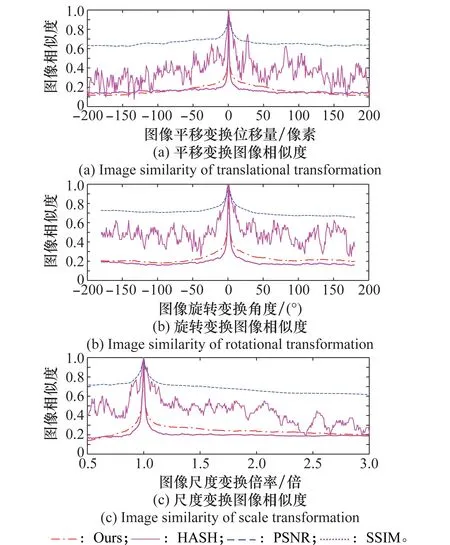

在相似度評價實驗前,先將圖8所示的3組圖像序列做高斯濾波和亮度變暗處理,模擬實際拼接過程中投影變換帶來的邊緣模糊以及曝光不均勻造成的亮度差異的情況。為了方便比較,本文將4種評價方法的結果進行歸一化處理,最終結果如圖9所示。

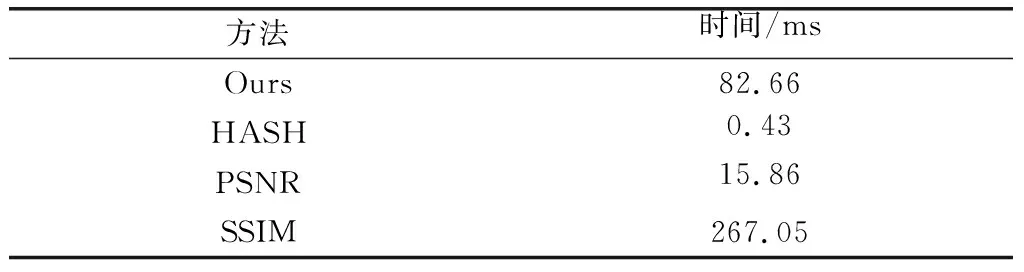

表3 4種評價方法耗時Table 3 Time-consuming of four evaluation methods

本實驗對3組不同變換方式產生的圖像序列與參考圖進行相似度評估。圖9結果顯示本文提出的方法相對于感知哈希算法魯棒性更強,相對于PSNR方法評價結果區分更明顯。本文方法和SSIM方法都能夠很快地收斂到真值附近但本文算法評價結果隨圖像差異變化過渡更符合人眼視覺。表3顯示的是4種算法在處理大小為400×400圖片過程中的平局處理時間,結果顯示感知哈希算法結果最快,而SSIM由于其計算量大,每個過程需要267 ms,本文提出的方法則只需要82.6 ms,滿足實時處理的需求。綜上所述,本文提出的基于圖像語義的拼接質量評價方法在評價結果以及處理耗時方面表現良好。

圖9 4種評價方法測試結果Fig.9 Test results of four evaluation methods

4.3 自適應動態視頻拼接方法

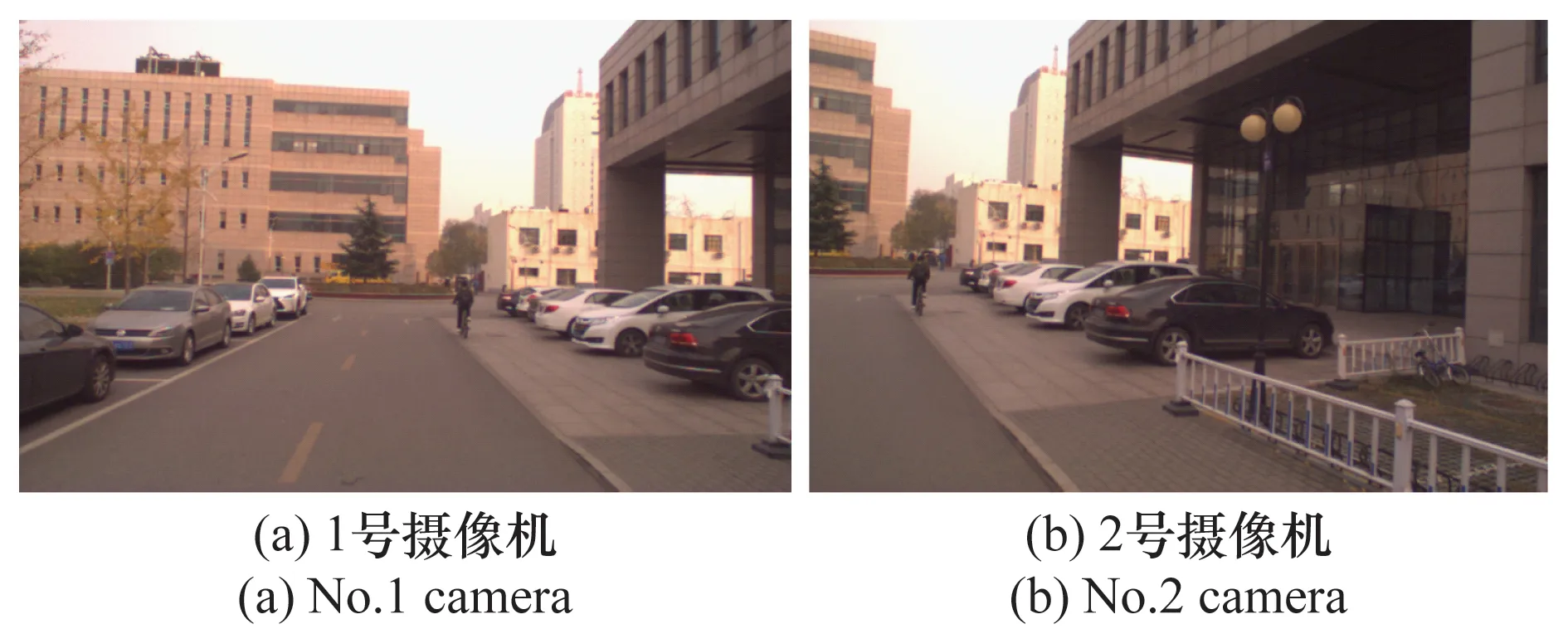

本實驗的數據由安裝在紅旗H7上的兩個攝像機拍攝得到,實驗平臺如圖10所示,攝像機采用的是菲力爾公司推出的Flea3系列相機,該相機能以60每秒傳輸幀數(frames per second,FPS)的速度采集分辨率為1 280×1 024的圖像,為了加快處理,本文將視頻幀壓縮到640×480。圖10所示的兩個攝像機采用非剛性連接,其中左側攝像機與車體固連,右側攝像機可以多自由度運動,模擬兩個攝像機相對位姿不固定的情況。測試地點選在北京理工大學中關村校區,測試環境如圖11所示,環境既包括靜態背景也包括車輛行駛中產生的動態背景,在獲取視頻過程中加入了人為對攝像機位姿的擾動,此時有來自兩個方面的因素會導致拼接參數的更新:①攝像機間相對位姿的變化;②由于場景移動導致視場中投影平面的變化。拼接的過程是按照第1節提出的拼接框架進行,以拼接質量評價結果作為反饋,進而優化拼接結果,使得結果盡可能達到本文設定的拼接評價閾值Th,本實驗設定閾值Th為經驗值0.7。

圖10 實驗平臺Fig.10 Experiment platform

本實驗在圖11所示的校園環境采集2 205張視頻序列做測試。為了測試程序的魯棒性,測試時車輛以10 km/h的速度行駛,拍攝環境有特征豐富的地面與建筑,也有特征缺失的墻面,相機的相對位姿也在動態變化,使得重疊區域有超過整張圖像二分之一的序列也有低于五分之一的序列,圖12是從視頻序列中抽取的4張拼接結果圖,其中左側為使用本文提出的視頻拼接方法所生成的效果圖,右側為使用文獻[17]視頻拼接方法所生成的拼接效果圖。

圖11 實驗環境Fig.11 Experimental environment

圖12 視頻序列拼接效果圖Fig.12 Video sequence stitching effect

圖12結果顯示在相機重疊區域有限,相機位姿差異明顯,測試環境復雜等情況下,本文算法仍能很好地計算出吻合程度較高的拼接圖。本文采用多線程編程方式將視頻拼接部分為主線程、特征配準線程、拼接評價線程等,使得算法能夠以約2幀(537 ms)的速度拼接運動場景下的視頻幀,其中語義分割耗時占總耗時的80%左右。

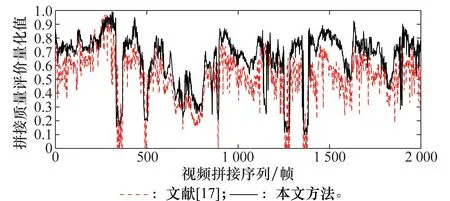

本文采用所提出的拼接質量評價方法對兩種拼接方法下視頻序列的拼接結果進行評估,評估結果如圖13所示。

圖13 視頻序列拼接評價結果Fig.13 Stitching evaluation result of video sequence

圖13實驗統計結果顯示,本文拼接方法評價均值為0.664 9,文獻[17]拼接方法的評價均值為0.534 7。在一些視頻序列中,文獻[17]拼接方法的拼接結果評價過低,其原因主要有3種可能:①參考圖與待配準圖視野重疊區域過小。由于攝像機組加入相對位姿的動態調整,導致某些攝像頭相對位姿下的視野重疊區域過小,其特點是存在時間較長且評價結果接近于0。②參考圖與待配準圖重疊區域特征缺失。由于參考圖與待配準圖重疊區域特征單一且稀疏,導致拼接結果有局部投影誤差,其特點是存在時間較短但評價結果不會太低,可以通過本文提出的基于反饋的拼接模式優化。③測試環境中攝像機距離前景目標較近,視差過大。其特點是存在時間短且評價結果急驟下跌;本文提出的帶有拼接質量反饋的自適應動態視頻拼接方法能很好優化這些問題。綜上所述,本文視頻拼接方法相比于文獻[17]提出的拼接方法,拼接質量提升了24.35%,在一些復雜環境下拼接結果更為魯棒。

5 結 論

現有的視頻拼接方案大多基于圖像的低階幾何特征實現,而沒有考慮圖像像素自身的高階語義信息,并且拼接過程都是單方向。為了減少匹配誤差、提高拼接精度,本文提出一種融合圖像語義的自適應動態視頻拼接方法,其重要優勢在于:①該方法將圖像像素點的語義信息融合到傳統基于特征向量歐式距離的匹配方法中,利用圖像的多種屬性對特征進行匹配與篩選,提高算法對錯誤匹配點的魯棒性;②該方法包含一種圖像拼接質量評價方案,即充分考慮圖像間紋理、色彩、語義等信息的相似程度,更貼合人眼的主觀感受;③該方法在視頻拼接過程中引入了拼接結果的反饋,能夠根據拼接的歷史信息優化特征缺失情況下的拼接結果;④該方法采用多線程編程的方式分時并行處理拼接過程,加快拼接過程。實驗結果顯示,相比于傳統算法,本文提出的匹配算法正確率提升了50%左右,拼接評價算法更符合人眼視覺,拼接質量提升了25%左右。但本文的方法由于引入了圖像的語義分割,降低了算法的實時性,在未來將著重改進現有的語義分割模型,使得語義分割更加高效準確,進而提高融合圖像語義視頻拼接方法的準確性與高效性。