多維度特征融合的教學行為智能分析模式構建

趙剛 朱文娟 胡碧靈 夏青 劉閃 初潔

[摘? ?要] 分析課堂教學行為是揭示課堂教學規律的一個重要途徑。如何利用信息技術手段處理與分析累積的海量教學視頻公開課中的教學行為,成為當前改革教學過程評價服務的熱點之一。由于教學中教學行為具有教學性、有序性、關聯性等固有教育特性,使得基于深度學習的視頻分割與識別技術仍然無法有效理解教學場景和教學行為。因此,文章設計了包含“基于視聽覺特征的教學行為分析編碼系統、教學行為聽覺特征識別、教學行為視覺特征識別、教學分析過程數據可視化呈現”四個核心要素的一種多維度特征融合的教學行為智能分析模式,提出了“視覺特征為主、聽覺特征為主、融合特征為主”三條實踐路徑,以厘清教學行為智能分析要素的關系,并以視覺特征為主的實踐路徑初步分析了43節課堂教學視頻,提取了時間維度上的教學行為視覺特征,以期為“一師一優課、一課一名師”“教師研修”等教學行為智能分析活動提供借鑒。

[關鍵詞] 教學行為; 多維度特征; 智能分析; 人工智能技術

[中圖分類號] G434? ? ? ? ? ? [文獻標志碼] A

[作者簡介] 趙剛(1981—),男,江西奉新人。教授,博士,主要從事多媒體技術與處理、智能學習分析研究。E-mail:zhaogang@mail.ccnu.edu.cn。朱文娟為通訊作者,E-mail:zwj@mails.ccnu.edu.cn。

一、引? ?言

課堂教學行為研究通過分析教學場景中教師和學生行為的顯著性特征,歸納師生教學行為的種類、活動率、轉換率等深層次特征,幫助教師全面了解教學情況,促進教師專業技能發展[1]。基于視頻的課堂教學行為分析為優化課堂教學過程、提高教學質量提供了可能[2]。然而,目前基于視頻的教學行為分析仍普遍采用人工參與機制[3],即按照固定時間分割后,安排分析人員觀察和分析教學內容,分析人員根據主觀的經驗識別其中的教學行為[4]。在人工智能方面,視聽覺的視頻分割與識別方法在新聞[5]、體育[6]、監控[7]等領域已從技術研究走向技術應用。在教學領域中,也有研究利用該方法對學生異常行為進行識別[8-9],但是,教學中的教學行為具有教學性、有序性、關聯性等固有教育特性,沒有充分考慮教學行為的教學含義,仍然難以取得理想的分割與識別效果,難以為后續分析提供理想的支持依據。因此,文章深入分析教學行為(非言語行為、言語行為)在教學場景中的表現形式和特點,提取各行為主體(教師、學生)的視覺、聽覺、語義等多維度特征信息,結合時序行為檢測、語義分析等技術,提出一種智能化的教學行為分析模式,實現教學場景中教學行為的高效、精準分割與識別,滿足海量教學視頻分析的需求。

二、教學行為分析方法概述

(一)教學行為分析方法的起源與發展

課堂教學行為研究起源較早,并且一直是教育領域的研究熱點,對教學行為的深入研究是開展教學分析的重要基礎。目前,教學行為分析方法主要分為教學行為分類與編碼和教學行為量化分析兩種方法。

教學行為分類與編碼是一種對教學行為進行分類,再進行編碼的方法,主要歸納為弗蘭德斯分析方法及其衍生分析方法和TIMSS方法。弗蘭德斯分析方法及其衍生分析方法起源于1963年弗蘭德斯提出的弗蘭德斯互動分析系統(FIAS)[10],該系統明確了課堂中師生言語行為類型,弗蘭德斯的局限性在于過于重視教師在課堂教學中的行為(7個類別),忽視了學生行為(2個類別)。我國學者提出了不同的分析系統以適應不同環境下、不同學科的課堂教學行為分析。面向不同教學環境,2004到2016年,我國學者顧小清[11]、方海光[12]、穆肅[13]、張屹[14]和蔣立兵[3]對FIAS進一步細分了行為類型,分別提出了基于信息技術的互動分析編碼系統(ITIAS)、針對數字化課堂教學環境的改進型弗蘭德斯互動分析系統(iFIAS)、針對信息化教學環境的課堂教學行為分析系統(TBAS)、智慧教室環境下的課堂教學互動分析編碼系統和智慧教室環境下的高校課堂教學行為分析系統(CTBAS)。面向不同學科,鄭長龍提出了CPUP化學課堂結構模型[15];劉向永結合小學英語教學的特征,修改和完善了iFIAS系統[16]。TIMSS方法提出的編碼系統比弗蘭德斯互動分析系統更為細致[13],將教師言語行為和學生言語行為分類至三級編碼[17]。

獲取課堂教學行為編碼后,利用教學行為量化分析方法對教學行為以及教學過程進行量化分析。教學行為量化分析法主要包括S-T教學分析、時序列分析、分類分析等方法。S-T教學分析方法是一種利用數據采集的方式把課堂師生教學行為量化為教師行為和學生行為數據,并通過數據圖形化的技術手段,簡潔明了地反映課堂教學的定量化教學分析方法[18]。時序列分析法是在時間的維度上,對教學過程進行統計分析,從而總結教學過程規律的一種動態教學行為量化分析方法[19-20]。

根據以上研究分析可知,教學行為分析的研究已較為成熟,然而,目前的教學行為分類體系忽視了對行為的視覺特征與聽覺特征的細化,與人工智能技術結合分析應用具有一定的困難。因此,本研究在以上教學行為分析方法的基礎上,對教學過程中教師和學生行為的視覺特征和聽覺特征進行細化,初步構建與優化適合人工智能技術分析應用的教學行為分析方法。

(二)教學行為分析的應用局限

為了分析教學行為分析領域關注的研究主題與研究熱點,本文以Web of Science數據庫核心數據合集和中國知網(CNKI)為數據來源,選取“教學行為”“教學互動行為”“互動分析”“S-T”“TIMSS”等相關主題的碩博畢業論文和教育技術領域學術期刊論文共2682篇。

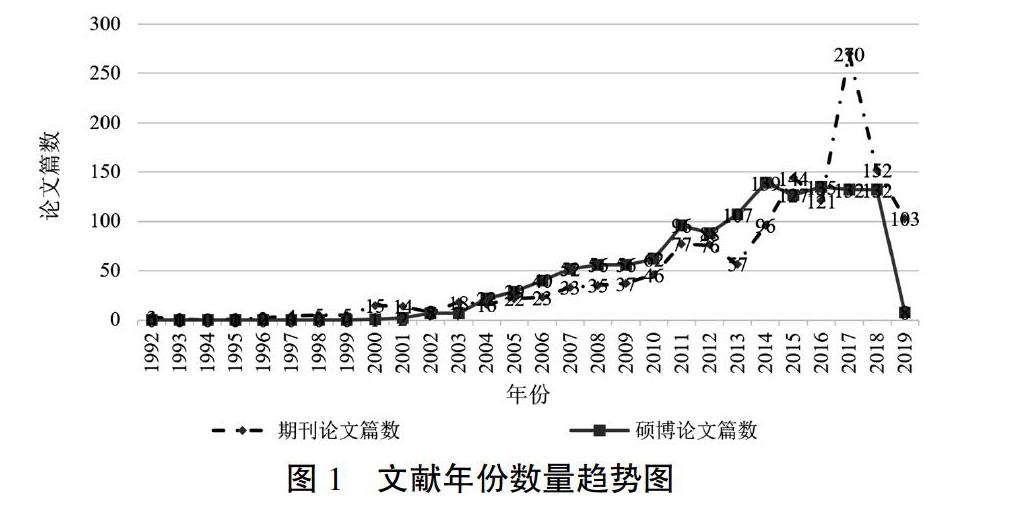

如圖1所示,1992年—2019年,期刊論文和碩博論文數量均呈現緩慢增長趨勢,隨著MOOC等網絡在線平臺的發展,在2017年,對教學行為分析的相關研究達到了最高峰。本文首先利用CiteSpace文獻分析軟件,選擇節點類型為“Term”對相關論文進行共詞分析。Term來源包括文章標題、摘要及關鍵詞,得到了代表中心性和被引頻次都比較高的關鍵詞;然后,利用詞云圖對論文關鍵詞進行可視化分析,直觀地展示高頻關鍵詞在文獻中的共現情況(如圖2所示)。從詞云元素大小來看,頻率較高的關鍵詞有“課堂交互”“教師教學行為”“有效教學”“個案研究”“新手教師”“Nvivo”等。

具體文獻分析顯示:教學行為分析的熱點領域是利用教學行為分析系統,結合個案研究法,評測師生教學行為與教學現象、教學環境、學科教學等之間的關聯關系,典型研究如司治國等對比分析英語新手教師的課堂教學行為的特點和存在的問題[21]。大部分研究利用Nvivo質性分析工具或采用計算機輔助結合定時分割的方式對教學行為數據進行采集與處理,例如:一節50分鐘的課,3秒采集一次,采集1000個采樣點,實現課堂教學視頻中的師生教學行為分析[22],此類研究的數據樣本規模較小,并且需要研究者人工識別教學行為。為了節省教學行為分析的人力投入,以及可能面臨的數據樣本增加等問題,部分研究者利用傳統機器學習算法和單幀的圖像對課堂教學行為進行識別與分析[23],然而,算法和數據的局限性使其只能區分教師行為和學生行為,忽視了教學行為的細節定位。

綜上所述,教學行為分析應用局限主要包括三個方面:(1)應用領域較廣,數據樣本大小受人工分析限制;(2)利用定時分割的計算機輔助技術,忽略了課堂中的教學行為的整體性特征,課堂教學是由多個有意義的教學環節單元以及有意義的教學事件單元組成,這些教學環節單元中又包括非言語行為中的師生教學姿態、言語行為中的教學語義內涵,定時分割的計算機輔助技術無法滿足教學視頻場景中的多類別教學行為分類與分割的需求;(3)利用傳統機器學習算法,忽視了教學行為分類的細節定位。

(三)基于深度學習的視頻分割與識別技術主導的分析模式在教學行為分析中的應用

隨著深度學習的發展,語音識別、語義分析、時序動作檢測和動作識別等人工智能技術實現了技術上質的飛躍。如今,計算機領域中基于深度學習的視頻分割與識別技術主導的分析模式的實踐路徑流程如下:第一步,提取視頻的圖像特征和聲音特征;第二步,對場景中的人物動作(動作包括行走、打球、梳頭等日常行為)進行識別與分析。在教育領域已初步有以下研究:Haibing Ren在智慧教室環境以及多個攝像頭環境下,結合教師臉部、雙肩關節、雙手等三維圖像特征,識別教師從講臺上拿物體、放回物體、指向學生、指向黑板、與學生交流、解釋物體、喝水七種動作[24];Asim Raza提出了基于隱馬爾可夫模型的教師活動識別的圖像幀序列方法,識別教師走路、寫作、指向黑板、站立和指向演示文稿五種動作類型[25];Nida通過提取教室場景視頻中教師的運動輪廓,利用極限學習機算法識別走路、指向黑板、指向屏幕、使用手機、使用筆記本電腦、閱讀筆記、坐下和板書八種不同教師行為類型[26];劉清堂構建了一種課堂教學行為智能分析模型,并以此分析了課堂中教師行為和學生行為兩類行為[27];魏艷濤利用深度學習網絡識別聽課、左顧右盼、舉手、睡覺、站立、看書和書寫七種學生課堂行為[28];也有研究通過圖像識別方法對學生異常行為(奔跑、打鬧等)進行分析[8-9]。

然而,在教學場景中,無論是學生行為,還是教師行為,以上教育領域中的基于深度學習的視頻分割與識別技術主導的分析模式研究止于淺層的教師或者學生動作,沒有深層次地分析其教學含義,同時教學場景中除了圖像特征和聲音特征,視頻的時序特征、語義特征等都有一定的教學含義。因此,本研究結合教學過程特性、教學過程中的教學行為特征和教學場景中的視覺特征、聽覺特征等,利用語音識別、時序動作檢測、語義分析、數據挖掘等人工智能技術,研究融合教學行為多維度特征的教學行為智能分析模式,為大規模課堂視頻教學行為分析與挖掘的開展和應用提供了新的技術手段和方法。

三、多維度特征融合的教學行為

智能分析模式構建

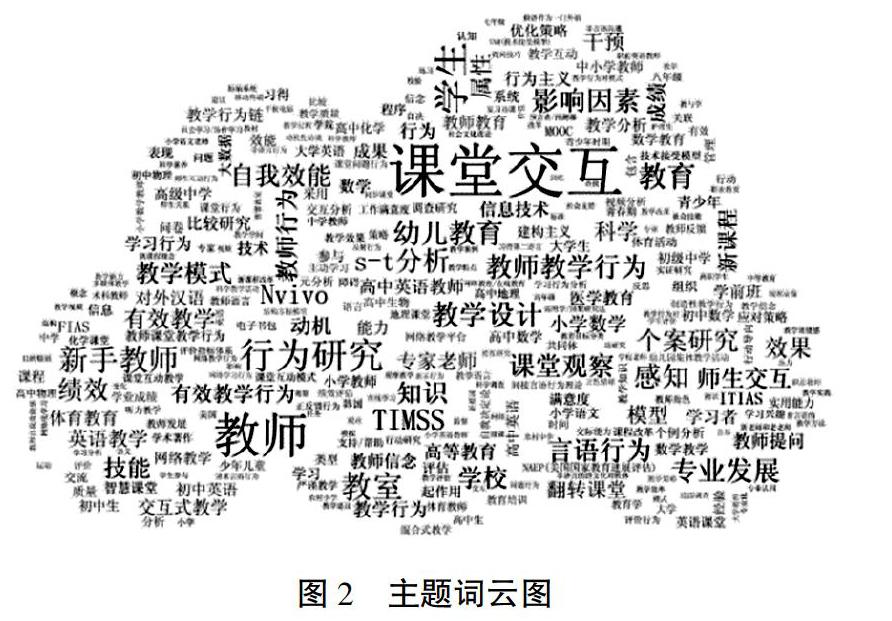

本文以教學行為分析理論和計算機領域中基于深度學習的視頻分割與識別技術主導的分析模式為基礎,通過大規模課堂觀察,在教育領域和計算機領域專家的雙重指導下提出一種教學行為智能分析解決方案,利用演繹法構建多維度特征融合的教學行為智能分析模式,結合教育特點,從基于視聽覺特征的教學行為分析編碼系統(Analysis Coding System of Teaching Behavior Based on Visual and Auditory Features,簡稱VATBAS)、教學行為聽覺特征識別(Auditory Feature Recognition of Teaching Behavior,簡稱TA)、教學行為視覺特征識別(Visual Feature Recognition of Teaching Behavior,簡稱TV)、教學分析過程數據可視化呈現(Visual Display of the Process Data of Teaching Analysis,簡稱TDV)四個核心要素,聽覺特征為主(VATBAS+TA+TDV)、視覺特征為主(VATBAS+TV+TDV)、融合特征為主(VATBAS +(TA+TV)+VATBAS+TDV)三條實踐路徑進行構建,該模式強調利用教育特性融合基于深度學習的視頻分割與識別技術,幫助解決目前教學行為智能分析中存在的問題,從而對智能分析教學行為進行理論指導。多維度特征融合的教學行為智能分析模式如圖3所示。

(一)核心要素

1. 基于視聽覺特征的教學行為分析編碼系統(VATBAS)

有效的智能化教學分析模式必然依賴于對教學場景中教師、學生行為的特點和方式的深入研究和理解,本研究在S-T、TIMSS、FIAS、ITIAS、iFIAS、智慧教室環境下的課堂教學互動分析編碼系統和CTBAS的基礎上,分析各類教學行為(非言語行為、言語行為)在教學場景中的外顯形式和特點,提取教學場景中各行為主體(教師、學生)的視覺、聽覺、語義特征,構建基于視聽覺特征的教學行為分析編碼系統(VATBAS)(見表1),為后續智能化教學行為分析提供重要的理論基礎和依據。該系統依據不同的行為主體(教師和學生)和行為活動方式(言語行為和非言語行為),將教學行為分為教師言語行為、教師非言語行為、學生言語行為、學生非言語行為和無意義的沉寂或混亂五個類別。對比以上七種編碼系統,該系統進行部分調整和優化設計,具體體現在以下三個方面:

第一,提取了行為主體在不同行為特征下與之相對應的視覺與聽覺特征。在復雜教學場景中,師生教學行為識別往往受到背景混雜、遮擋、噪音等因素影響,視覺、聽覺特征(語義特征與聽覺特征在此編碼系統中合并成聽覺特征)的相互融合能夠從數據中多角度提取出教學場景中的目標信息和環境信息。通過提取多模態特征以彌補單模態特征的不足,實現系統化、數字化的教學行為分類。

第二,將師生與技術的交互行為歸類到教師、學生非言語行為的二級或三級編碼。由于目前大多數的教學場景都是多媒體教室,師生互動形式更加復雜多樣。除了教師和學生、學生和學生互動之外,還存在教師、學生和計算機多媒體設備的互動。若將其增加在一級編碼上,勢必會增加編碼個數,給觀察者在某種程度上造成記錄負擔。單純的技術行為并不能真正體現技術與師生互動的真正融合[29]。在師生的非言語行為中都伴隨著技術設備的輔助行為,如教師使用多媒體設備進行講解、學生用計算機技術展示成果等。將人與技術的交互行為融入教師、學生的非言語行為中,可以使本研究建立的教學行為分析編碼系統更加合理和客觀。

第三,細化師生言語行為。教師言語行為:考慮到內容來源的多樣性,將“講授”細分為“基于多媒體內容講授”和“基于教材內容講授”;考慮到內容的深度與廣度,將“反饋評價”細分為“判斷對錯”“總結或延伸”“鼓勵表揚”“批評維權”。學生言語行為:考慮到提問內容與課程的相關性,將“主動提問”細分為“問課程相關問題”和“問課程非相關問題”兩個方面;考慮到主被動關系以及與課程內容的相關性,將“應答”細分為“主動應答與課程相關問題”“被動應答與課程相關問題”“主動應答與課程非相關問題”“被動應答與課程非相關問題”;考慮到目前教學進一步重視培養學生的語言表達能力,添加一項“匯報展示”的表現形式。

2. 教學行為的聽覺特征識別:語音識別、聲紋識別與語義分析技術

教學場景中具有“一對多”的對象關系(一個教師對應多個學生)、教師說話時間較長等特性,多維度特征融合的教學行為智能分析模式利用語音識別、聲紋識別技術,采集語音信號數據以及語音聲學特征(語音情感特征),獲取課堂教學視頻的時間、與時間相對應的文本信息以及與時間相對應的說話人的身份,利用語義分析技術,結合VATBAS對文本信息進行語義相似度計算,從而獲取基于聽覺特征的教學行為序列。

3. 教學行為的視覺特征識別:時序動作檢測與動作識別技術

教學場景具有場景布局穩定、教師與學生活動范圍有限且運動路徑較為穩定等特性,多維度特征融合的教學行為智能分析模式利用時序行為檢測與動作識別技術,提取課堂教學錄像視頻幀的圖像特征、光流特征、時序特征等,對教學行為數據進行訓練,生成教學行為決策模型,利用教學行為決策模型對視頻場景中教師和學生的行為邊界進行定位、分割,獲取基于視覺特征的教學行為序列。

4. 教學分析過程數據可視化呈現:數據可視化、數據挖掘與決策支持技術

數據可視化分為探索型可視化和理解型可視化,探索型可視化是指從數據集中不確定能夠獲取到何種信息,試圖探索數據所潛藏的信息;理解型可視化可以生成便于用戶理解的形式,是一種最直觀、最清晰的方式,可以提高處理效率,如教學行為時序列圖。多維度特征融合的教學行為智能分析模式利用數據可視化技術研制可視化界面工具,將數據置于視覺空間中,產生教師教學行為分析報告、學生教學行為分析報告等直觀的可視化分析報告;同時,利用數據挖掘技術挖掘深層信息,深度挖掘教師的學科知識、教師教學能力和學生異常行為等數據信息,產生相對應的可視化數據挖掘分析報告,輔助教學決策。

(二)實施路徑

“VATBAS+TV+TDV”“VATBAS+TA+TDV”在VATBAS的基礎上,對課堂教學行為進行定義和關聯。首先,利用語音識別、聲紋識別與語義分析技術獲取課堂教學視頻的聽覺特征和語義特征,或者利用時序動作檢測、動作識別、圖像識別技術深度提取課堂教學視頻的視覺特征;然后,利用VATBAS進一步篩選課堂教學視頻中與教學行為相關的有效特征;最后,可視化提取教學行為數據。

“VATBAS+(TA+TV)+VATBAS+TDV”將“VATBAS+TV+TDV”和“VATBAS+TA+TDV”相結合,首先,提取課堂教學視頻的聽覺特征、語義特征和視覺特征,篩選課堂教學視頻中與教學行為相關的有效特征后,利用融合全局最優識別策略(如特征比重)初步確定教學行為類型;其次,利用VATBAS進行二次篩選;最后,利用數據挖掘、數據可視化與決策支持技術,對深層次的信息進行挖掘并產生可視化的分析報告,以求獲得智能化的教學行為分析服務形態。

四、融合視覺特征的時序教學行為檢測與識別

融合視覺特征的時序教學行為檢測與識別是多維度特征融合的教學行為智能分析模式的實踐路徑“視覺特征為主”的應用案例。以時序列分析法為例,利用深度學習中時序動作檢測R-C3D網絡[30]作為時序教學行為視覺特征檢測與識別模型,闡述多維度特征融合教學行為智能分析模式中教學行為的視覺特征識別過程。

融合視覺特征的教學行為識別主要包括以下步驟:(1)時序教師行為數據采集與預處理。采集課堂教學視頻并對課堂教學視頻進行預處理和標注,從而構建時序教師行為數據集。(2)遷移學習。以時序動作檢測公共數據集預訓練的R-C3D網絡模型對課堂教學視頻數據進行訓練。(3)實驗結果及分析。評估訓練的時序教學行為識別模型。

(一)時序教師行為數據采集與預處理

基于VATBAS中分類的視覺特征,本次實驗將課堂中的時序教學行為分為學生舉手(對應VATBAS中SS01、SS020101或者SS020201的視覺特征)、學生坐下(輔助視覺特征)、學生站起來(對應VATBAS中SS02的視覺特征)、教師指向交互式白板(對應VATBAS中TS0101的視覺特征)、教師指向黑板(對應VATBAS中TS0102的視覺特征)、教師邀請學生回答問題(對應VATBAS中TS02的視覺特征)、教師在黑板上寫字(對應VATBAS中TA0101的視覺特征)和教師在教室巡視(對應VATBAS中TA04的視覺特征),以上淺層的視覺特征能為后續深層次的具有教學含義的行為分析提供一定的數據支撐。

本研究選取上海市D學校和武漢市G學校,采集了43節課堂教學視頻,包括信息技術、數學、語文等科目,總時長1770.29分鐘,視頻分辨率為720×576,幀率為25fps。利用自主研發的時序教學行為標注工具對課堂教學視頻進行人工標注,標定教學行為的起止時間及行為類別,總標注3360個行為片段。目前,行為時間跨度在0.5s~70.0s之間,標注完成后,工具自動生成相應的時序教學行為標注文件。本研究使用23節課堂教學視頻(1936個行為片段)訓練相關網絡,使用20節課堂教學視頻(1424個行為片段)進行測試。

(二)遷移學習

為了解決由于小樣本數據集難以提供足夠學習特征而導致模型能力欠缺的問題以及加快R-C3D網絡訓練過程,本文利用ActivityNet數據集[31]預訓練的R-C3D網絡模型對課堂教學視頻數據進行遷移學習,使模型在遷移學習過程中加速修正模型權值,以提高時序教學行為檢測與識別能力。

(三)實驗效果及分析

利用VATBAS進行篩選后的時序教師行為檢測與識別,如圖4所示,預測算法檢測的時序教學行為起始時間與標記數據真實值相差較小,同時,預測算法識別的時序教學行為種類概率在69%以上。后續工作將進一步優化相關算法,研究適用視頻時長較長、標注行為個數較多的時序教學行為檢測與識別算法,提高時序教學行為檢測精度。

圖5是時序教學行為檢測與識別算法測試后生成的時序教學行為起始時間和行為種類的可視化數據,橫軸表示45分鐘課堂時間的度量,縱軸表示以上提到的時序教學行為類別。從圖5(a)可以看出,上海市D學校高中數學“直線的參數方程”課堂前200秒的時序教學行為包括教師在黑板上寫字、教師指向黑板、教師邀請學生回答問題、學生站起來,但是由于視覺特征的局限性(鏡頭切換),部分時序教學行為順序稍顯不合理。例如:學生站起來后沒有學生坐下;圖5中1000秒~2000秒之間多為教師時序行為,課堂中間時間段一般為新課教學環節。綜上所述,融合視覺特征的時序教學行為檢測與識別具有一定的合理性。專業教師在該實驗成果應用過程中表示,該方法不僅可以對一節課堂中的時序教學行為進行分析,也可以對大批量相同課程的教學過程進行分析,以減少教師統計分析的工作量。與此同時,也能夠為教師借鑒優質課程和反思自身教學提供技術支撐工具。

五、結? ?語

本文針對已有的教學行為智能分析應用局限,提出了一種多維度特征融合的教學行為分析模式,并初步嘗試了模型中部分實踐路徑的應用,為大規模課堂視頻教學行為分析的開展提供了新的解決思路,多維度特征融合的教學行為分析模式的創新點在于:(1)構建基于視聽覺特征的教學行為分析編碼系統(VATBAS),深入分析教學過程中的師生行為主體在不同行為特征下與之相對應的視覺、聽覺特征,細化了教學行為類型,實現教學行為類型、教學行為聽覺特征、教學行為視覺特征的精確描述和理解,為后續智能化的教學行為分析的實現提供重要的理論依據;(2)提出智能教學行為分析的解決方案,針對現有的計算機領域中基于深度學習的視頻分割與識別技術主導的分析模式難以滿足有教學含義的教學行為分析而導致的問題,利用VATBAS作為視聽覺特征提取的先驗知識和約束規則,采用語音識別、時序動作檢測、語義分析、數據挖掘等人工智能技術提取教學場景中的有效特征,提供可視化的結果呈現方式,形成智能化的教學行為分析服務形態。后續研究將對其他兩條實踐路徑進行應用研究,不斷跌代修正該模式,同時,繼續優化相關算法,形成有效的教學過程評價服務科研產品,以期應用到“一師一優課,一課一名師”“教師研修”、在線課堂等活動領域,為教學行為分析提供更優質的服務。

[參考文獻]

[1] MINTZES J J. Relationships between student perceptions of teaching behavior and learning outcomes in college biology[J]. Journal of research in science teaching,2010,19(9):789-794.

[2] 王萍.人工智能在教育視頻中的應用分析與設計[J].電化教育研究,2020,41(3):93-100,121.

[3] 蔣立兵,毛齊明,萬真,沈歡.智慧教室促進高校課堂教學變革的績效研究——基于課堂教學行為的分析[J].中國電化教育,2018(6):52-58.

[4] 姚佳佳,李艷,金松濤,潘金晶.信息技術融入課堂的教師教學轉型發展研究[J].中國電化教育,2019(3):37-47,80.

[5] POULISSE G, MOENS M, DEKENS T, et al. News story segmentation in multiple modalities[J]. Multimedia tools & applications,2010,48(1):3-22.

[6] KHAN M, TANVEER H, SUNG W B. Efficient CNN based summarization of surveillance videos for resource-constrained devices[J]. Pattern recognition letters,2018(9):1-6.

[7] TANG Y S, DING D, RAO Y M, et al. COIN: a large-scale dataset for comprehensive instructional video analysis[C]//The IEEE Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE Press,2019:1207-1216.

Construction of Intelligent Analysis Model of Teaching Behavior

Based on Multi-dimensional Feature Fusion

ZHAO Gang,? ZHU Wenjuan,? HU Biling,? XIA Qing,? LIU Shan,? CHU Jie

(School of Educational Information Technology, Faculty of Artficial Intelligence in Education, Central China Normal University, Wuhan Hubei 430079)

[Abstract] Analyzing classroom teaching behavior is an important way to reveal the law of classroom teaching. How to use information technology to process and analyze the teaching behaviors in the massive teaching videos in open classes has become one of the hotspots in the evaluation service of the current teaching reform. However, due to the inherent educational characteristics of teaching behaviors in teaching, such as teaching, orderliness and relevance, the video segmentation and recognition technology based on deep learning still cannot effectively understand the teaching scene and teaching behavior. Therefore, this paper designs an intelligent analysis model of teaching behavior with multi-dimensional feature fusion, which includes four core elements of "teaching behavior analysis coding system based on visual and auditory features, teaching behavior auditory feature recognition, teaching behavior visual feature recognition, and teaching analysis process data visualization presentation". Furthermore, three practical approaches dominated by "visual feature, auditory feature and fusion feature" are proposed to clarify the relationship between intelligent analysis elements of teaching behavior. And 43 classroom teaching videos are preliminarily analyzed based on the practical approach dominated by visual features, and the visual features of teaching behaviors are extracted from the time dimension, so as to provide reference for intelligent analysis activities of teaching behaviors such as "one excellent course for every teacher, one excellent teacher for every course" and "teacher training".

[Keywords] Teaching Behavior; Multi-dimensional Features; Intelligent Analysis; Artificial Intelligence Technology