深度殘差網絡應用與實踐

翟高粵 高乾龍

摘 要:本文先介紹深層神經網絡模型特點和應用,并指出其隨著層數的加深發展的瓶頸及不足之處;然后引入深度殘差網絡的概念,以其實現代碼為例,詳細介紹深度殘差神經網絡的關鍵技術特點,最后通過一個實例說明深度殘差神經網絡在深度學習方面的應用。

關鍵詞:深度學習;殘差網絡;梯度彌散;梯度爆炸

自2012年AlexNet的提出以來,各種各樣的深度卷積神經網絡模型相繼被提出,其中比較有代表性的有VGG系列,GoogLeNet系列等,它們的網絡層數整體趨勢逐漸增多。以網絡模型在ILSVRC 挑戰賽ImageNet數據集上面的分類性能表現為例,在AlexNet出現之前的網絡模型都是淺層的神經網絡,Top-5錯誤率均在25%以上,AlexNet 8層的深層神經網絡將Top-5錯誤率降低至16.4%,性能提升巨大,后續的VGG、GoogleNet模型繼續將錯誤率降低至6.7%。

AlexNet、VGG、GoogLeNet等網絡模型的出現將神經網絡的發展帶入了幾十層的階段,研究人員發現網絡的層數越深,越有可能獲得更好的泛化能力。但是當模型加深以后,網絡變得越來越難訓練,這主要是由于梯度彌散和梯度爆炸現象造成的。在較深層數的神經網絡中,梯度信息由網絡的末層逐層傳向網絡的首層時,傳遞的過程中會出現梯度接近于0 或梯度值非常大的現象。網絡層數越深,這種現象可能會越嚴重。

一、深度殘差網絡簡介

針對上述問題,如何解決由于層數加深而引起的梯度彌散和梯度爆炸的現象?一個很自然的想法是,既然淺層神經網絡不容易出現這些梯度現象,那么可以嘗試給深層神經網絡添加一種回退到淺層神經網絡的機制。當深層神經網絡可以輕松地回退到淺層神經網絡時,深層神經網絡可以獲得與淺層神經網絡相當的模型性能,而不至于更糟糕。通過在輸入和輸出之間添加一條直接連接的Skip Connection可以讓神經網絡具有回退的能力。以 VGG13深度神經網絡為例,假設觀察到VGG13模型出現梯度彌散現象,而10層的網絡模型并沒有觀測到梯度彌散現象,那么可以考慮在最后的兩個卷積層添加Skip Connection。通過這種方式,網絡模型可以自動選擇是否經由這兩個卷積層完成特征變換,還是直接跳過這兩個卷積層而選擇Skip Connection,亦或結合兩個卷積層和Skip Connection的輸出。這就是深度殘差網絡的由來。

2015年,微軟亞洲研究院何凱明等人發表了基于Skip Connection 的深度殘差網絡(Residual Neural Network,簡稱ResNet)算法,并提出了18層、34層、50層、101層、152 層的ResNet-18、ResNet-34、ResNet-50、ResNet-101和ResNet-152等模型,甚至成功訓練出層數達到1202層的極深層神經網絡。

二、深度殘差網絡原理

一般來說,網絡層數越深,就可以越好的擬合出真實的函數。然而,在網絡深度較深時,由于梯度消失,網絡的性能反而變差。殘差網絡很好的解決了梯度消失問題。殘差網絡的主要思想是通過恒等映射,保證深層的效果不弱于淺層。

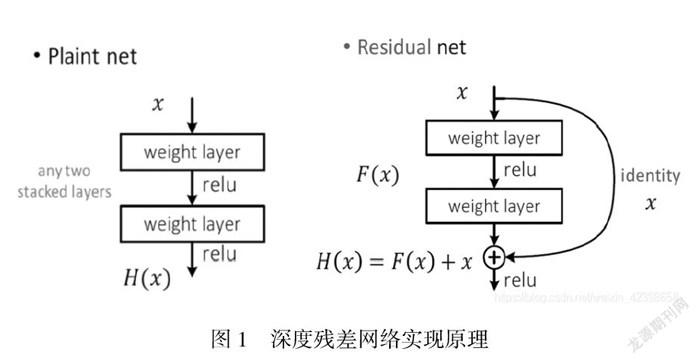

殘差網絡借鑒了高速網絡(Highway Network)的跨層鏈接思想,但對其進行改進(殘差項原本是帶權值的,但ResNet用恒等映射代替之)。假定某段神經網絡的輸入是x,期望輸出是H(x),即H(x)是期望的復雜潛在映射,如果是要學習這樣的模型,則訓練難度會比較大;回想前面的假設,如果已經學習到較飽和的準確率(或者當發現下層的誤差變大時),那么接下來的學習目標就轉變為恒等映射的學習,也就是使輸入x近似于輸出H(x),以保持在后面的層次中不會造成精度下降。在殘差網絡結構圖中,通過shortcut connections(捷徑連接)的方式,直接把輸入x傳到輸出作為初始結果,輸出結果為H(x)=F(x)+x,當F(x)=0時,那么H(x)=x,也就是上面所提到的恒等映射。于是,ResNet相當于將學習目標改變了,不再是學習一個完整的輸出,而是目標值H(X)和x的差值,也就是所謂的殘差F(x) = H(x)-x,因此,后面的訓練目標就是要將殘差結果逼近于0,使到隨著網絡加深,準確率不下降。

這種殘差跳躍式的結構,打破了傳統的神經網絡n-1層的輸出只能給n層作為輸入的慣例,使某一層的輸出可以直接跨過幾層作為后面某一層的輸入,其意義在于為疊加多層網絡而使得整個學習模型的錯誤率不降反升的難題提供了新的方向。

至此,神經網絡的層數可以超越之前的約束,達到幾十層、上百層甚至千層,為高級語義特征提取和分類提供了可行性。

三、深度殘差網絡Python代碼實現

深度殘差網絡并沒有增加新的網絡層類型,只是通過在輸入和輸出之間添加一條 Skip Connection,因此并沒有針對ResNet的底層實現。在TensorFlow中通過調用普通卷積層即可實現殘差模塊。

首先創建一個新類,在初始化階段創建殘差塊中需要的卷積層、激活函數層等,首先新建卷積層,主要代碼如下:

class BasicBlock(layers.Layer):

# 殘差模塊類

def __init__(self, filter_num, stride=1):

super(BasicBlock, self).__init__()

# f(x)包含了2個普通卷積層,創建卷積層1

self.conv1 = layers.Conv2D(filter_num, (3, 3), strides=stride, padding='same')

self.bn1 = layers.BatchNormalization()

self.relu = layers.Activation('relu')

# 創建卷積層2

self.conv2 = layers.Conv2D(filter_num, (3, 3), strides=1, padding='same')

self.bn2 = layers.BatchNormalization()

? ?當F(x)的形狀與x不同時,無法直接相加,我們需要新建identity(x)卷積層,來完成x的形狀轉換。緊跟上面代碼,實現如下:

if stride != 1: # 插入 identity 層

self.downsample = Sequential()

self.downsample.add(layers.Conv2D(filter_num, (1, 1), strides=stride))

else: # 否則,直接連接

self.downsample = lambda x:x

在前向傳播時,只需要將F(x)與identity(x)相加,并添加ReLU激活函數即可。前向計算函數代碼如下:

def call(self, inputs, training=None):

# 前向傳播函數

out = self.conv1(inputs) #通過第一個卷積層

out = self.bn1(out)

out = self.relu(out)

out = self.conv2(out) #通過第二個卷積層

out = self.bn2(out)

# 輸入通過 identity()轉換

identity = self.downsample(inputs)

# f(x)+x 運算

output = layers.add([out, identity])

# 再通過激活函數并返回

output = tf.nn.relu(output)

return output

代碼原理圖如圖1所示。

圖1 深度殘差網絡實現原理

四、總結

殘差網絡結構簡單,解決了極深度條件下深度卷積神經網絡性能退化的問題,分類性能表現出色。本文先通過例子說明非常深的網絡很難訓練,存在梯度消失和梯度爆炸問題,學習 skip connection它可以從某一層獲得激活,然后迅速反饋給另外一層甚至更深層,利用 skip connection可以構建殘差網絡ResNet來訓練更深的網絡,ResNet網絡是由殘差模塊構建的。這種方式能夠到達網絡更深層,有助于解決梯度消失和梯度爆炸的問題,讓我們訓練更深網絡同時又能保證良好的性能。

參考文獻:

[1] 劉航等.基于深度殘差網絡的麥穗回歸計數方法[J],中國農業大學學報,2021(4).

[2] 張宇等.融入注意力機制的深度學習動作識別方法[J],電訊技術,2021(4).

[3] 閆濤. 深度學習算法實踐 [M]. 電子工業出版社出版社,2020.

[4] 王宇石等.一種基于卷積神經網絡的違禁品探測系統及部署方法[J],科技創新與應用,2020(7).