基于機器學習與眼動追蹤的認知風格模型構建

摘要:認知風格反映了學生接近、獲取、組織、處理和解釋信息的模式,可用來解釋和指導學生的行為。將認知風格集成到智能系統中,有助于開發個性化的用戶模型,推動智能教育發展。當前有關認知風格自動分類的研究較為匱乏,尚未將機器學習與眼動追蹤技術聯合起來進行應用。基于機器學習與眼動追蹤的認知風格模型,選取注視時長、注視點數量、掃視時長、眼跳次數、眼跳距離與瞳孔直徑等6個與認知有著密切關系的眼動指標,歸一化處理后借助機器學習算法進行認知風格自動分類。實驗結果表明:在進行同樣時長的視頻學習時,不同場認知風格的學習者表現出不同的視覺行為模式;場依存型學習者注視點較為分散,表現出有較多的掃視行為、較少的注視行為、較長的眼跳距離與較大的瞳孔直徑變化,信息搜索效率較低;而場獨立型學習者有著較為密集與定向的視覺注意模式,信息搜索效率更高。對5種機器學習算法進行性能對比后發現,邏輯回歸算法的分類效果最好,準確率達到89.01%,Kappa值達到0.774。該認知風格自動化分類模型既可用于智能學習系統的課程資源優化設計,也可用于個性化學習路徑的推薦。未來可整合更多生理數據,通過不同模態數據之間的信息互補,提升數據分析的準確性以及對學習者認知能力評估的可靠性。

關鍵詞:智能教育;機器學習;眼動追蹤技術;場認知風格;自動化分類

中圖分類號:G434" "文獻標識碼:A" " 文章編號:1009-5195(2024)04-0094-10" doi10.3969/j.issn.1009-5195.2024.04.011

——————————————————————————————————————————

基金項目:全國教育科學規劃2022年度教育部重點課題“智能教育視角下基于眼動追蹤的在線學習認知模型及自適應機制研究”(DCA220453)。

作者簡介:薛耀鋒,博士,副研究員,碩士生導師,華東師范大學教育信息技術學系,上海數字化教育裝備工程技術研究中心(上海 200062);朱芳清,碩士研究生,華東師范大學教育信息技術學系(上海 200062)。

一、引言

目前我國教育正面臨著由規模化向個性化、從信息化到智能化的過渡和轉變,傳統的教育模式和學習方式亟待創新與變革。智能教育作為智能技術與教育領域深度融合的代表,能夠服務于教育模式的轉變和教育生態的重構(郭紹青等,2022)。《中國教育現代化 2035》從智能校園建設、人才培養、教育治理等不同方面提出了智能教育發展的戰略任務(新華網,2019),加快了智能教育以及相關應用的落地。智能教學系統是智能技術賦能教育的重要成果(王靖等,2023)。認知風格數據正被集成到智能系統中,以開發個性化的用戶模型,推動智能教育發展(Nisiforou et al.,2013)。一些研究結果表明,認知風格與學習成績之間存在直接關聯,即學習內容和形式與學習者的認知風格越匹配,學習者的學習成績就越高(Jovanovic et al.,2012)。認知風格是指個體展示的相對穩定的信息處理模式(McKay et al.,2003),反映了學生接近、獲取、組織、處理和解釋信息的模式,可以用來解釋和指導他們的行為。然而傳統的認知風格測量往往通過量表來進行,測量結果可能會受到主觀因素的影響,同時需要較長的填寫時間(Yousef et al,,2021)。因此,亟需開發一種新的、更便捷、更客觀的測量方法,來準確評估學生的認知風格,以更好地服務智能時代學生的學習。

隨著智能技術及認知科學的發展,基于眼動追蹤技術來探究學習者的認知過程已成為教育學與心理學研究的重要方式。這是因為眼球運動是視覺感知活動中不可或缺的重要組成部分(Workman,2004),眼動數據能夠追蹤反映學習者的信息加工與認知過程,且眼動追蹤技術具有非侵入性的優勢(薛耀鋒等,2021)。越來越多的研究開始探索個體的認知特征與視覺之間的關系。例如,Liu(2018)通過眼動數據研究了場依賴和場獨立認知風格在視覺搜索效率和多媒體學習性能方面的差異,證明了眼動指標可用于識別學習者的認知風格類型。然而,目前的眼動追蹤數據僅以熱圖或描述性統計結果的形式區分學習者的類型,具體的分析與驗證還需要研究者的進一步解釋(Pradnya Sidhawara et al.,2020)。

隨著人工智能技術的發展,將眼動追蹤技術與機器學習相結合來優化智能系統,已成為智能教育系統開發研究的重要趨勢。例如,Eivazi等人(2011)使用眼動追蹤和機器學習的方法來探究個人的視覺注意力模式與問題解決行為的關系;Lou等人(2017)使用支持向量機(Support Vector Machine,SVM)算法和眼動追蹤技術來評估讀者的識字能力,準確率達80.3%。先前研究表明,機器學習算法可用于眼動數據的分析,以實現對學習者認知狀態的自動識別。

基于此,本研究擬基于機器學習算法和眼動追蹤技術構建認知風格自動識別模型,通過分析學習者眼動模式與認知風格之間的關系,總結不同場認知風格學習者在視頻學習過程中的眼動模式及其眼動指標差異,并利用機器學習算法實現在線學習過程中學習者場獨立—場依存風格的自動分類,以促進智能學習系統的開發,為學生提供個性化和智能化的反饋。

二、相關研究

1.場認知風格

場認知風格是在關于教學效果的研究中確定的認知風格理論(Al-Saai et al.,1993)。場認知風格分為場獨立、場依存兩個維度,是最廣泛被使用的認知風格分類之一。Witkin(1967)認為,不同人處理學習材料的方式不同,使用不同的方法完成學習任務;場獨立型個體在信息加工中對內在參照(主體精神)有較大的依賴傾向,主要依據內在標準或內在參照進行價值判斷;而場依存型個體則傾向于以外在參照(外部環境或他人)作為信息加工的依據,處理問題時往往依賴于外在參照對客觀事物或事實進行判斷。因此,場依存型個體比場獨立型個體更容易受到外部線索的影響。在以視覺感知為主的學習活動中,學習者的這種認知偏好對學習的影響更大。已有研究發現,場依存型學習者在識別嵌入到復雜圖形中的簡單圖形時需要更長的時間,或者根本無法找到;場依存型學習者在從視覺教學材料中提取相關信息方面存在困難(Mahvelati,2020);場獨立型個體更易受到內部線索而不是外部線索的影響,因此在信息輸入方面具有選擇性(Riding et al.,1991)。在社交方面,場依存型個體與場獨立型個體也表現出明顯差異。場獨立型個體具備良好的分析能力,但在社交中表現出孤立、冷漠和疏離的狀態;而場依存型個體樂于與人互動,表現出對與他人交流的強烈興趣(Saracho,2003)。

2.眼動追蹤技術

眼球運動被認為與大腦的思維活動有關,這種連續的信息流可以作為探究認知過程的重要指標。已有研究發現,人眼的位置僅在 200~300 毫秒時間內保持穩定。眼球穩定的時期被稱為注視期,它們覆蓋了大約 2° 的可視角度區域,在此期間信息被聚焦和處理(Jacob et al.,2003)。注視的位置和注視點數量、注視的持續時間和眼跳距離是最常見的眼動測量指標。注視的持續時間、注視次數和重新注視次數揭示了用戶的注意力是如何被引導到特定區域或視覺位置的。掃視是指眼睛從一個注視點到另一個注視點的運動。兩個連續注視點之間的距離定義為眼跳距離。注視和掃視的路徑和順序,顯示了注意力隨時間的變化情況,可用于深入了解學習者是如何從視覺線索中收集信息的(Carter et al.,2020)。瞳孔直徑也是重要的眼動指標,瞳孔大小的變化與認知處理需求的變化相關,且該指標較為敏感,0.1mm的瞳孔直徑變化就可以代表認知狀態的改變,因此瞳孔直徑可以作為高級心理變化的測量指標(Szulewski et al.,2015)。

3.眼動指標在場認知風格測量中的應用

眼動指標有著很強的表意功能,學習者的認知處理模式可以通過眼動狀態與視覺路徑來識別(詹澤慧,2013)。具有不同場依賴性的個體在處理多媒體信息時可能表現出不同的眼球運動模式。例如,場依存型學習者被認為可能比場獨立型學習者需花費更多的時間和精力來從學習環境中搜索必要的信息(Witkin,1967)。此外,插圖的視覺豐富性,包括顏色細節、紋理和形式等特征,也可能干擾場依存型學習者對任務相關信息的處理。因此,與場獨立型學習者相比,場依存型學習者可能會表現出更分散的視覺場景注視,以及更長的任務達成時間。

眼動指標在場認知風格測量中的應用研究,多為在特定任務情境中,探討不同場認知風格學習者的眼動行為差異。如Liu(2018)分析了在觀看多媒體教學材料時,不同場認知風格學習者的注視與掃視行為差異;Nisiforou等人(2016)分析了在進行隱藏圖形測試時,不同場認知風格學習者的任務完成時長及視覺搜索模式差異。還有一些學者通過眼動數據建模,實現了對其他類別認知風格的自動識別。如薛耀鋒等(2020)通過圖片與文字興趣域中注視點與注視時長的比值,對言語—表象型學習者進行了自動識別;Pradnya Sidhawara等(2020)通過K臨近算法(KNN)等三種機器學習算法,以注視與掃視相關指標為自變量,實現了言語—表象型學習者的自動分類。

總的來說,有關場認知風格自動識別的研究仍較為匱乏,多數研究僅限于描述性統計分析,眼動數據僅用于驗證。此外,以往的研究還未將機器學習算法應用于基于眼動追蹤數據的場認知風格自動分類中。因此,本研究擬將機器學習算法和眼動追蹤技術結合起來,構建認知風格自動分類模型,一方面豐富相關領域的研究,另一方面借助場認知風格的自動分類,進一步完善學習者畫像,為設計更加個性化的智能教育系統提供支持。

三、面向智能教育的認知風格模型構建

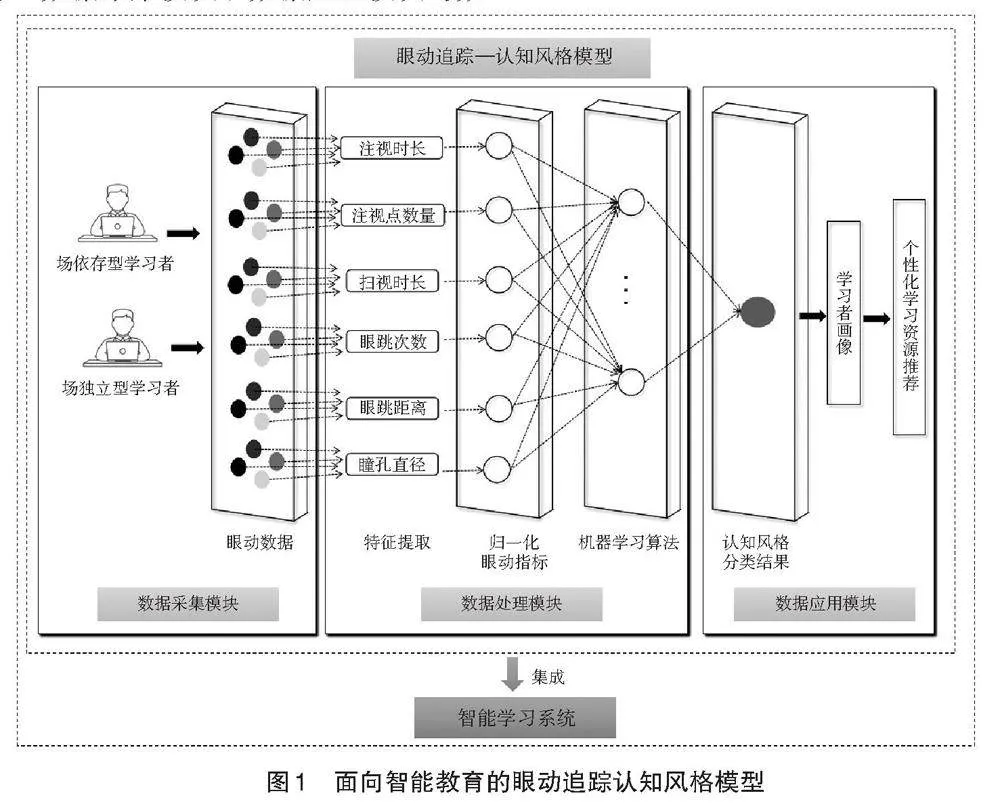

本研究將機器學習算法和眼動追蹤技術結合在一起,構建了認知風格自動分類模型(如圖1所示)。整個模型集成在一個智能學習系統當中,主要分為三大部分:數據采集模塊、數據處理模塊與數據應用模塊。數據采集模塊的功能是在學習者觀看在線課程視頻的過程中通過外部的眼動儀設備來收集眼動數據。數據處理模塊的功能是實現眼動數據處理以及認知風格自動識別。該模塊是整個模型的核心。首先,對收集到的原始眼動數據進行特征提取,提取出注視時長、注視點數量、掃視時長、眼跳次數、眼跳距離以及瞳孔直徑6個原始指標;然后對原始指標進行歸一化處理,將其作為自變量數據,同時將認知風格類型作為標簽,輸入到機器學習算法當中,得到最終的分類結果。數據應用模塊的功能是將學習者認知風格的識別結果儲存在學習者畫像庫當中,為之后的智能課程推薦、智能教學規劃等提供支持。眼動指標與機器學習算法的選擇,決定了認知風格模型分類的效果,是整個模型最為關鍵的兩個環節。

1.眼動指標選擇

由于本研究的目的是準確識別學習者的認知風格,因此在選擇眼動指標時,研究選擇了與學習認知密切相關的注視類、掃視類以及瞳孔直徑類指標。

常用的注視類指標包括注視時長與注視點數量。注視時長是指在一個區域內進行的所有注視行為的時間總和。注視時長越長,學習者的認知資源投入越多,對學習內容的認知加工程度也就越深。注視點數量是指在一個區域內進行的注視行為的總次數。在某個區域內的注視點越多,學習者在此處的注意力及認知資源分配就越多(閆志明等,2018)。

常用的掃視類指標包括掃視時長、眼跳次數及眼跳距離。掃視指的是眼睛從一個注視點到另一個注視點的行為。眼跳過程中會產生視覺抑制現象,使學習者知覺信息的能力減弱,因此掃視過程中是不進行深度認知處理的(閆志明等,2018)。掃視時長指的是在一個區域內進行的所有掃視行為的時間總和。掃視時間越長,說明注意力越不集中。眼跳次數指的是眼睛在注視點之間轉換的總次數。一般來說,學習內容區域或難度越大,眼跳次數越多。眼跳距離指兩個注視點之間的距離,是反映知覺廣度的指標。越長的眼跳距離代表在一次注視中提取的信息量越大(王雪,2015)。

瞳孔直徑即瞳孔的大小,反映了廣泛的認知過程。在亮度與頭部動作恒定的情況下,腦力勞動的增加會導致瞳孔直徑的增大(Math?t et al.,2023)。研究表明,在學習過程中,瞳孔越大說明提取信息越難、心理負荷越大,需要投入更多的認知資源來理解知識(曹衛真等,2012)。

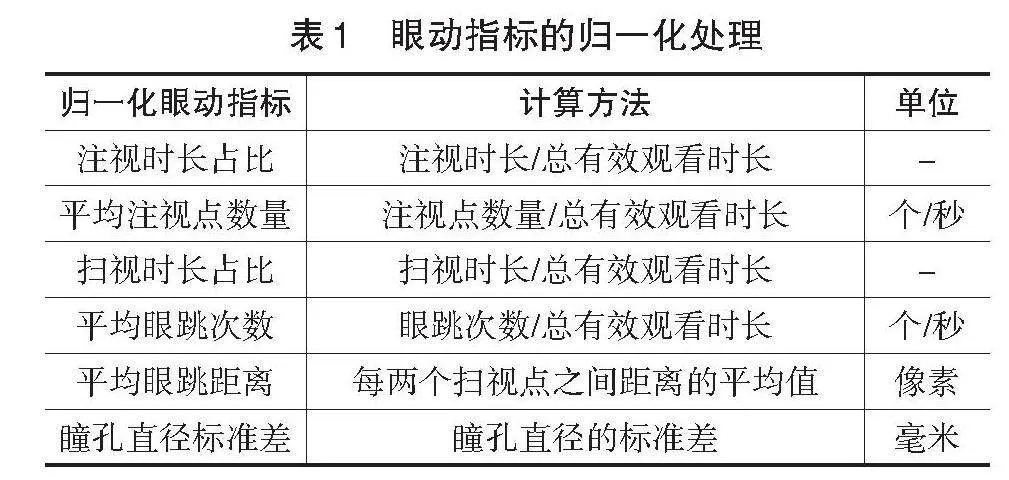

由于坐姿等客觀因素的影響,不同被試的眼動數據收集率會有差別。研究選取數據收集率在50%以上的眼動數據作為有效數據。為了使后續建模輸入的數據及建模結果不受數據收集率的影響,研究將眼動指標進行歸一化處理,處理后的指標將作為最終的建模指標,具體見表 1。

2.機器學習算法選擇

為了實現學習者場認知風格的自動識別,本研究選擇5種常用的機器學習算法進行分類性能測試與比較,目的是選取性能最好的機器學習算法來構建最終模型。5種機器學習算法分別是支持向量機(Support Vector Machine,SVM)、隨機森林(Random Forest,RF)、樸素貝葉斯(Naive Bayes,NB)、K臨近算法(K-Nearest Neighbor,KNN)以及邏輯回歸(Logistic Regression,LR)。

支持向量機是一種監督分類算法,旨在找到線性可分特征向量的優化超平面,以最大化分類間隔來增強泛化能力,同時最小化誤分類誤差。支持向量機可以在被稱為核函數的非線性映射函數的幫助下有效地執行非線性分類。因此,通過將主輸入空間映射到高維點積空間,可以增強線性可分離性(Ghazizadeh et al.,2019)。然而其對缺失數據較為敏感,且在多分類問題中容易陷入過擬合。本研究使用線性核作為支持向量機的內核函數。

隨機森林是一種基于識別的、監督式的機器學習算法。它由許多決策樹組成,是一種使用復數決策樹的集成學習算法,減少了數據集的過度擬合并提高了精度,克服了決策樹算法的局限性。隨機森林對噪聲具有魯棒性,并且可以通過減少泛化誤差來產生高精度的結果(Breiman,2001)。但是,當遇到取值劃分比較多的特征時,會對其整體判斷產生較大影響。本研究將樹的數量設置為100,將單個樹的深度限制為5。

貝葉斯網絡由一個結構模型和一組條件概率組成。結構模型是一個有向無環圖,其中節點表示屬性,弧表示屬性依賴關系。屬性依賴關系通過給定其父節點的每個節點的條件概率進行量化。樸素貝葉斯分類器是最簡單的貝葉斯網絡分類器,它假定實例的所有屬性在給定類的上下文的情況下彼此獨立,在大樣本處理時有很大優勢(Jiang et al.,2013)。不過,當樣本屬性有關聯時,會影響模型的準確度。

K臨近算法是一種非參數分類方法。它是基于監督學習技術,用于模式識別和分類的最簡單的機器學習算法之一。與其他分類器不同,KNN 算法本身不需要訓練階段,因為它只存儲預測階段的訓練數據。KNN 算法假定新數據與已有數據之間具有相似性,并將新數據放入與可用類別最相似的類別中(Kharbech et al.,2016)。但其計算量較大、計算速度慢,不易確定K值,且數據不均衡時會影響準確性。本研究以 K=5 運行算法。

邏輯回歸是廣義線性回歸模型的特定情況,是一種為了解決二分類問題提出的算法。該算法在假設數據服從伯努利分布的基礎上,給定條件概率分布,并用極大似然估計求解最優參數。邏輯回歸本質上是一個線性分類器,所得到的模型清晰,可解釋性強,并且實施簡單,計算高效,可以在大數據場景中使用(Bewick et al.,2005)。然而其不能解決非線性問題,也難以處理數據不平衡問題。

四、實驗設計

1.實驗材料

在線課程視頻。本研究選取2段時長為3分鐘、主題為“機器學習”的在線課程視頻作為實驗材料。每段課程視頻均以“文本+圖片+聲音”的形式呈現。課程視頻的亮度恒定,防止由于亮度變化而引起瞳孔直徑的變化。

認知風格量表。本研究采用鑲嵌圖形測驗(Group Embedded Figure Test,GEFT)作為認知風格的識別量表(張雁凌,2003)。該測驗共分為三個部分,共有簡單圖形9個與復雜圖形29個。每個部分測試時間為5分鐘,要求被試在規定時間內從各個復雜圖形中找到規定的簡單圖形并用筆標注出來。第一部分的9道題目較為簡單,主要用于讓被試熟悉題目,不計入總分。第二、三部分的題目每答對一道題記1分,答錯不得分。能夠快速排除干擾信息并找到簡單圖形的被試為場獨立型學習者,反之則為場依存型學習者。在本研究中,得分在0~10分的被試為場依存型學習者,得分在11~20分的為場獨立型學習者。

2.實驗對象

本研究選取H大學68名在讀大學生為實驗被試,年齡在18~24歲之間。為保證眼動數據的有效性及采集率,被試的裸眼糾正視力均不低于1.0,不配戴眼鏡或佩戴眼鏡的度數低于400度。同時,為保證學習認知過程順利,要求被試均具有一定的機器學習基礎。被試在申請參與時,需填寫機器學習測試問卷,合格者才能被選取。根據鑲嵌圖形測試的結果,共有39名被試為場獨立型學習者,29名為場依存型學習者。

3.實驗設備與環境

首先,研究使用Tobii T120眼動儀收集每個被試的眼動數據。該儀器的數據采集頻率為60 Hz,精度為0.5°。眼動儀集成在17 英寸的LCD屏幕中,通過在屏幕下方安裝光學系統以實現眼球運動追蹤。教學材料顯示在LCD屏幕上,當被試觀看材料時,眼動儀會記錄眼球運動。其次,研究使用與眼動追蹤同步的Tobii Studio軟件收集數據。實驗選擇在一間安靜、恒溫且光照適宜的實驗室中進行,以減少無關因素對被試的影響。被試坐在軟椅上觀看材料,同時桌面上放有頭部支架,減少被試的頭部移動,以確保眼動數據的收集率以及有效性。

4.實驗流程

在實驗開始之前,被試填寫機器學習先驗知識問卷,通過者成為正式被試。進入實驗室后,被試通過紙筆測驗的方式進行鑲嵌圖形測驗題目作答,主試計時并控制每部分答題時長。眼動實驗正式開始前,由主試向被試介紹實驗流程以及注意事項,并幫助被試進行眼動儀校驗。被試通過校驗后方可正式觀看學習視頻。被試觀看第一個實驗視頻后,黑屏3分鐘供被試休息,之后再觀看第二個實驗視頻。在此期間,研究者一直使用眼動儀記錄數據。被試觀看完畢后離開實驗室,實驗結束。

5.數據分析

實驗結束后,研究人員利用Tobii Studio軟件進行眼動數據導出、預處理與特征提取等工作;使用SPSS 23.0軟件對眼動指標進行單因素方差分析,以此來確定場認知風格對學習者眼動行為的影響;使用RapidMiner Studio 9.10軟件進行場認知風格分類算法模型的構建,并采用準確率(Accuracy)以及Kappa值來評價算法性能。

五、結果與討論

1.機器學習算法的分類性能比較

本實驗共收集到73萬余條眼動樣本數據,將數據進行特征提取,總共得到136組特征向量。研究首先利用眼動數據實現對場認知風格學習者的分類。方法是:將歸一化后的注視時長占比、平均注視點數量、掃視時長占比、平均眼跳次數、平均眼跳距離、瞳孔直徑標準差6個指標作為變量輸入,以場認知風格類型為標簽進行分類,分別使用支持向量機(SVM)、隨機森林(RF)、樸素貝葉斯(NB)、K臨近算法(KNN)以及邏輯回歸(LR)等機器學習算法,通過十折交叉驗證法檢驗算法的準確率和Kappa值,得到如表 2所示的結果。

準確率指的是所有分類正確的樣本數與總樣本數的比值,即分類正確的概率,范圍在0~1之間,值越大說明采用該方法進行的分類越準確。Kappa系數是用在統計學中評估一致性的一種方法,考查的是預測結果和實際分類結果是否一致,范圍在-1~1之間,通常大于0,值越大說明該方法的分類性能越強。

由表2可以看出,在5種機器學習算法中,邏輯回歸(LR)算法具有最高的分類準確率,達到89.01%;同時具有最高的Kappa值,為0.774。說明在這5種算法之中,邏輯回歸算法在進行場認知風格分類時性能最強,是構建模型的最優方法。

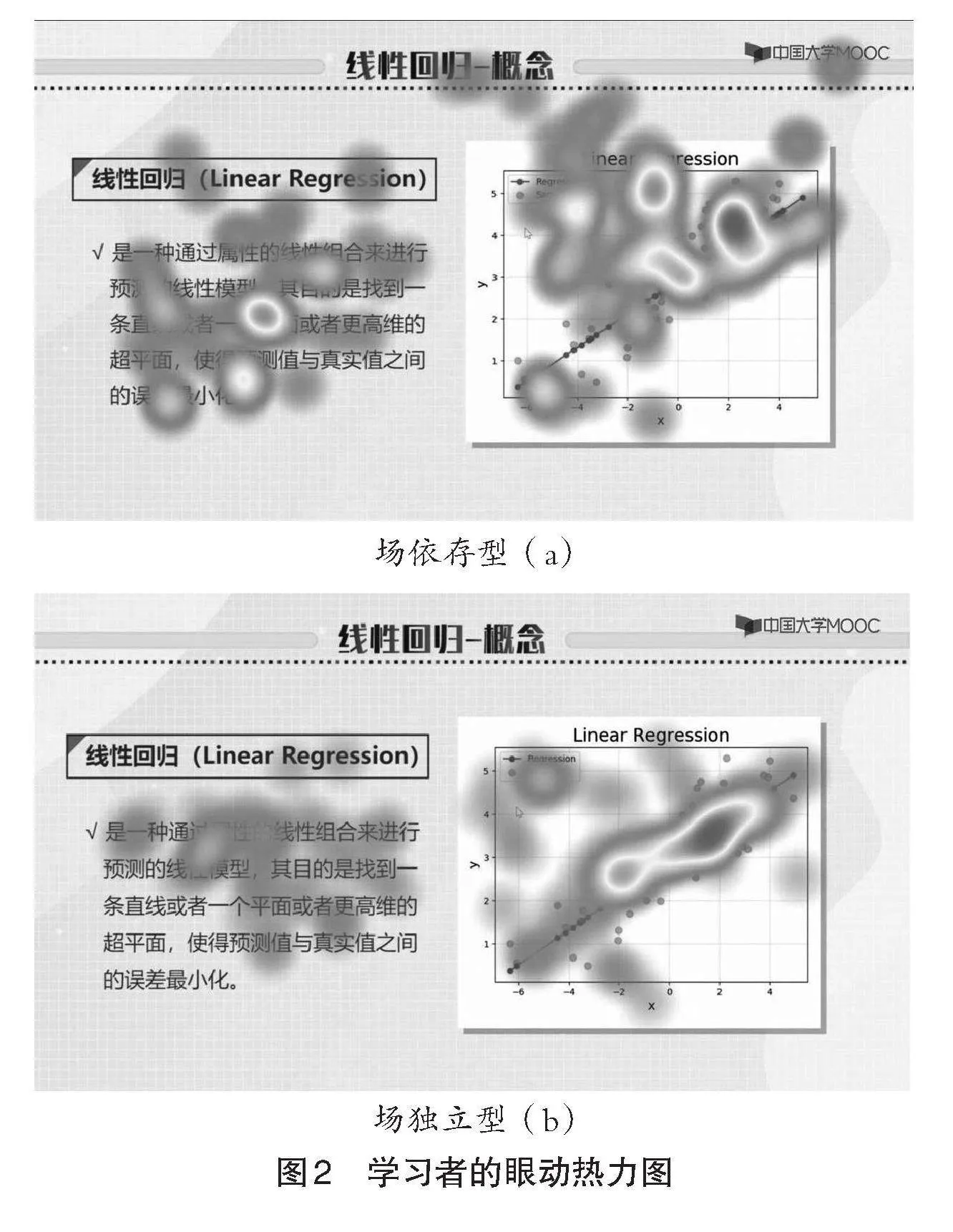

2.不同認知風格學習者眼動熱力圖及眼動路徑比較

為了更深入地了解不同認知風格學習者在眼動行為上的差異,并為其個性化學習資源推薦提供指導,本研究對學習者的視覺模式與眼動指標進行了深入分析。圖 2展示了一名場依存型學習者與一名場獨立型學習者的眼動熱力圖,顏色越深、亮度越亮代表被試在該位置的注釋時間越長。從圖中兩名學習者的注意力分布情況來看,場依存型學習者在注意力分配(即注視位置)方面比場獨立型學習者表現出更顯著的變化。場依存型學習者的注視位置較為分散,在文字、圖片等區域都有大量的注視行為。場獨立型學習者的注視位置較為集中,注意力主要分布在圖片區域。在信息搜索方面,分散的注視點表明學習者難以將知識內容進行編碼,在識別與理解知識內容方面具有更大的不確定性(Just et al.,1976);反之,較為集中的注視點反映了更高的視覺搜索效率,表明學習者可以更快速地進行知識編碼并儲存。通過實驗可知,場獨立型學習者比場依存型學習者具有更高的視覺搜索效率。

圖 3展示了圖 2中對應的場依存型學習者與場獨立型學習者的眼動路徑圖,相鄰的兩個注視點由直線連接,并且在某注視點的注視時間越長,則該注視點的直徑就越大。該圖體現了不同認知風格學習者的視覺搜索模式。總體來看,相較于場獨立型學習者,場依存型學習者的眼動路徑較為分散與雜亂,且會受到與知識無關內容的影響。場依存型學習者的眼跳距離更大,且較多次地注視學習視頻中的信息,體現出一種較為分散的視覺搜索模式。而場獨立型學習者的眼跳距離較小,注視內容更加密集,體現了較為密集的視覺搜索模式。根據Rayner等人(1992)的研究結果,回視的次數反映了在視覺場景中搜索信息時定位關鍵內容的困難程度。圖3同時也表明,場依存型學習者更難搜索到視頻中的關鍵信息與關鍵知識。

結合場認知風格理論,不同認知風格的學習者產生不同視覺搜索模式的原因在于,場依存型學習者難以識別視頻信息中的關鍵元素,需要依賴信息與環境之間的關系來輔助判斷。因此,場依存型學習者需要逐個探測視頻信息,由此產生了更多的掃視與回視等行為。相比之下,場獨立型學習者表現出更精準的搜索模式,其特點是更少的掃視和回視。同時,場依存型學習者的注意力容易受到與課程內容不相關因素的影響,視線多次在課程標題與課程內容之間轉移,體現出一定的迷失與分心情況。而場獨立型學習者的注意力則集中分布在與課程內容有緊密關系的要素上,視覺行為更加定向。

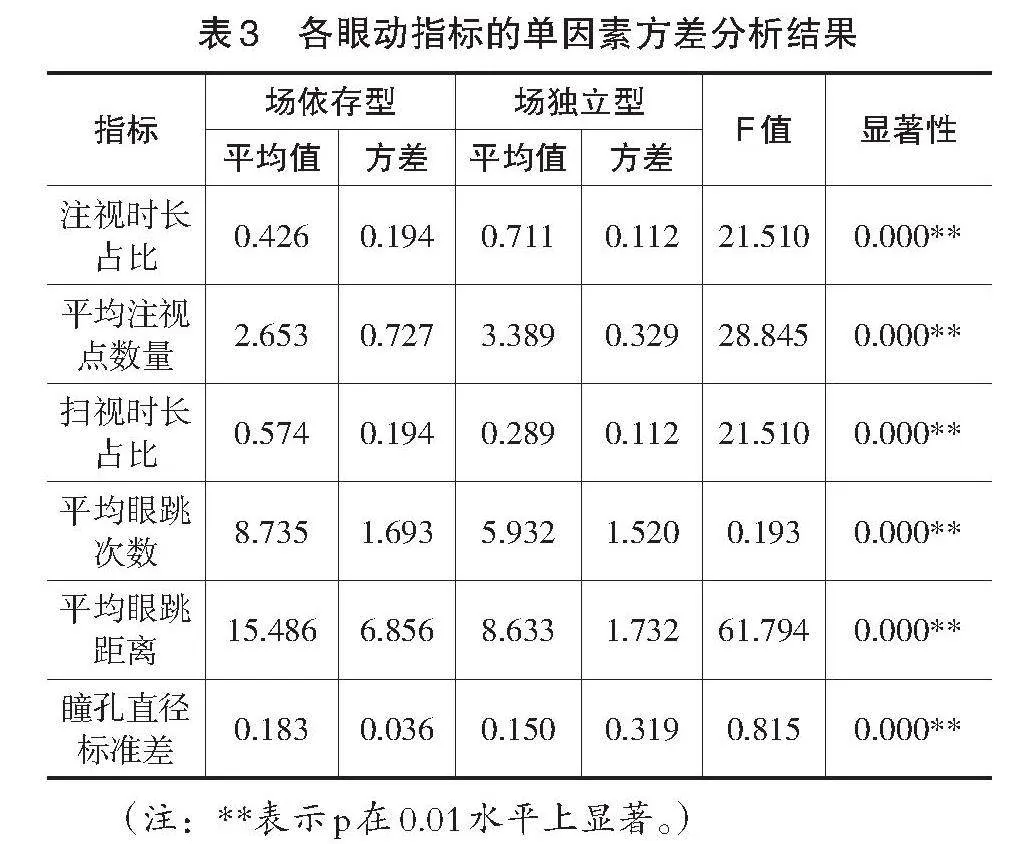

3.不同認知風格學習者眼動指標差異性分析

使用方差分析對眼動數據進行分析可知(結果如表 3所示),6個眼動指標均在0.01水平上具有顯著差異。其中,場獨立型學習者的注視時長占比與平均注視點數量均高于場依存型學習者,場依存型學習者的掃視時長占比與平均眼跳次數均高于場獨立型學習者。這表明在視頻學習的過程中,場獨立型學習者進行了更多的注視行為,而場依存型學習者進行了更多的掃視行為。同時,場依存型學習者的平均眼跳距離顯著大于場獨立型學習者,與眼動路徑圖的結果一致,表明場依存型學習者需要大范圍地進行信息檢索。并且,場依存型學習者的瞳孔直徑標準差顯著大于場獨立型學習者,表明場依存型學習者在學習過程中產生了更加顯著的認知變化。

掃視指標的相關結果與以往研究一致,即場依存型學習者表現出更多的掃視行為。然而注視時長的結果與以往的研究不同。已有研究認為,場依存型學習者難以確定關鍵信息,因而需要更多的注視行為進行信息的獲取與理解(Nisiforou et al.,2013);而本研究發現,場獨立型學習者的注視時長與平均注視點數量均高于場依存型學習者。究其原因,已有的場認知風格—眼動研究中的實驗材料是不限時的測試任務,需要統計被試完成任務整個過程中的眼動行為。由于場依存型學習者難以識別關鍵信息,他們會花費更長的時間來完成任務,在此過程中需要進行更多的認知處理,因此會產生更多的注視行為。然而本研究的實驗材料為時長固定的課程視頻,在相同的時間內,場依存型學習者會花費更多的時間來檢索關鍵信息,因而會產生更多的掃視行為,從而減少了注視行為的占比。因此,雖在不同的背景與不同的需求下,對兩種場認知風格學習者的眼動指標分析產生了不同的結果,但其背后隱含的認知原理卻是相同的。

六、總結

1.邏輯回歸算法是構建認知風格模型的良好方法

本研究旨在構建基于機器學習算法與眼動追蹤技術的認知風格模型,實現學習者認知風格的自動分類,為智能學習系統的構建提供支撐。研究共選擇了5種機器學習算法來構建認知風格模型。通過實驗數據分析,發現邏輯回歸(LR)算法在進行認知風格分類時的準確率與Kappa值均最高,分類準確率高達89.01%,是分類性能最佳的方法。因此,我們最終選取邏輯回歸作為認知風格模型構建的機器學習算法。

2.不同認知風格學習者視覺模式存在差異

本研究通過眼動實驗,深入挖掘了不同認知風格學習者的眼動行為差異。結果表明,在視頻學習過程中,不同場認知風格學習者表現出不同的視覺行為模式。場依存型學習者有著較為分散的視覺注意模式,同時在信息檢索方面存在一定困難,且在掃視過程中容易迷失和分心;場獨立型學習者有著較為密集與定向的視覺注意模式,更加關注重點學習內容,信息搜索效率更高。

同時,對場依存型和場獨立型學習者的眼動指標差異進行分析發現,兩種認知風格的學習者在6個歸一化眼動指標上均具有顯著差異。在固定時長的視頻學習過程當中,場依存型學習者展現了更多的掃視行為與更長的平均眼跳距離;場獨立型學習者展現了更多的注視行為與較短的平均眼跳距離。這表明在進行同樣時長的視頻學習時,場依存型學習者會花費更多時間來進行信息檢索,而場獨立型學習者會花費更多時間來進行信息處理。

3.認知風格模型可為智能教育提供精準支撐

本研究所構建的認知風格模型可應用于智能學習系統的優化當中,具有豐富的現實意義。首先,本研究探索了學習者認知風格與視覺行為之間的聯系,該結果可用于智能學習系統的課程資源優化設計。基于以學習者為中心的設計理論,在以學習者為中心的學習環境中提供能滿足個人獨特學習需求的資源,有助于加深學習者對學習內容的理解(牟智佳,2017)。當教師或教學設計者認識到不同認知風格學習者的視覺行為差異時,可以根據學習者的個體差異為其提供差異化的學習材料。例如,由于場依存型學習者難以識別課程中的關鍵信息,在課程設計的過程中,可加入更多的線索,如加粗、加亮關鍵字體,或通過添加箭頭等形式,來為場依存型學習者提供學習輔助,幫助其快速定位關鍵信息,提升學習效率。

其次,認知風格模型還可用于智能學習系統的構建。個性化學習路徑的規劃是智能學習系統的重要功能之一,其實現的關鍵在于明確學習者的特征。學習者特征把握不精準,是目前個性化學習路徑推薦準確率較低的主要原因(唐雯謙等,2021)。本研究提供了認知風格分類精確度近90%的模型,可以幫助設計者準確地把握學習者的認知風格特征。將訓練好的模型嵌入到在線學習平臺當中,可以實現對學習者認知風格的自動識別,構建更加細致的學習者畫像,進而為學習者提供更適合的學習內容、更合理的學習路徑,提升其學習體驗和學習效果。

4.局限性與展望

首先,本研究的實驗材料較為單一,僅提供了呈現方式較為單一的某一學科的課程視頻作為實驗材料。因此,未來的研究可使用更多樣化的課程視頻,或者是其他類型的視覺刺激,以檢驗實驗方法與實驗結果的可靠性和有效性。此外,應考慮更多的學習者特征如年齡、性別、學科背景等,探究其對認知風格和眼動行為的影響,同時可以將其作為新的自變量輸入到機器學習算法當中,以提升模型的針對性與準確性。眼球運動也可能會受到學習環境的影響,僅使用眼動追蹤數據來測量學習認知并不全面,未來可將其他的生理指標如腦電、心電等整合在研究中,通過不同模態數據之間的信息互補,提升數據分析的準確性,以完善學習者認知評估的可靠性。

參考文獻:

[1]曹衛真,殷婷如,邢強等(2012).常見教學網頁圖文搭配方式對記憶效果影響的研究[J].電化教育研究,33(2):93-100.

[2]郭紹青,華曉雨(2022).論智慧教育與智能教育的關系[J].西北師大學報(社會科學版),59(6):139-147.

[3]牟智佳(2017).“人工智能+”時代的個性化學習理論重思與開解[J].遠程教育雜志,35(3):22-30.

[4]唐雯謙,覃成海,向艷等(2021).智慧教育與個性化學習理論與實踐研究[J].中國電化教育,(5):124-137.

[5]王靖,巴安妮,吳寶鎖(2023).智能教學反饋的目標、機制與架構[J].現代遠程教育研究,35(3):102-112.

[6]王雪(2015).多媒體學習研究中眼動跟蹤實驗法的應用[J].實驗室研究與探索,34(3):190-193,201.

[7]新華網(2019).中共中央、國務院印發《中國教育現代化2035》[EB/OL].[2023-08-09].http://www.moe.gov.cn/jyb_xwfb

/s6052/moe_838/201902/t20190223_370857.html.

[8]薛耀鋒,曾志通(2020).面向自適應學習的不同認知風格學習者眼動模型研究[J].現代教育技術,30(8):91-97.

[9]薛耀鋒,李佳璇(2021).基于眼動追蹤的在線同步學習系統可用性評測[J].現代教育技術,31(12):85-93.

[10]閆志明,郭喜蓮,王睿(2018).多媒體學習研究中眼動指標述評[J].現代教育技術,28(5):33-39.

[11]詹澤慧(2013).基于智能Agent的遠程學習者情感與認知識別模型——眼動追蹤與表情識別技術支持下的耦合[J].現代遠程教育研究,(5):100-105.

[12]張雁凌(2003).中國大學生的場獨立/依存的認知風格對英語水平的影響[J].外國語言文學,(4):43-45.

[13]Al-Saai, A. J., amp; Dwyer, F. M. (1993). The Effect of Visualization on Field-Dependent and Field-Independent Learners[J]. International Journal of Instructional Media, 20:243-249.

[14]Bewick, V., Cheek, L., amp; Ball, J. (2005). Statistics Review 14: Logistic Regression[J]. Critical Care, 9(1):112-118.

[15]Breiman, L. (2001). Random Forests[J]. Machine Learning, 45(1):5-32.

[16]Carter, B. T., amp; Luke, S. G. (2020). Best Practices in Eye Tracking Research[J]. International Journal of Psychophysiology, 155:49-62.

[17]Eivazi, S., amp; Bednarik, R. (2011). Predicting Problem-Solving Behavior and Performance Levels from Visual Attention Data[C]// Proceedings of the 2nd Workshop on Eye Gaze in Intelligent Human Machine Interaction at IUI. Palo Alto, CA:9-16.

[18]Ghazizadeh, E., Abbasi-Moghadam, D., amp;" Nezamabadi-Pour, H. (2019). An Enhanced Two-Phase SVM Algorithm for Cooperative Spectrum Sensing in Cognitive Radio Networks[J]. Communication Systems, 32(2):e3856.

[19]Jacob, R. J. K., amp; Karn, K. S. (2003). The Mind’s Eye: Cognitive and Applied Aspects of Eye Movement Research[M]. Amsterdam, The Netherlands: Elsevier Science:573-605.

[20]Jiang, L. X., Cai, Z. H., amp; Zhang, H. et al. (2013). Naive Bayes Text Classifiers: A Locally Weighted Learning Approach[J]. Journal of Experimental amp; Theoretical Artificial Intelligence, 25(2):273-286.

[21]Jovanovic, M., Vukicevic, M., amp; Milovanovic M. et al. (2012). Using Data Mining on Student Behavior and Cognitive Style Data for Improving E-Learning Systems: A Case Study[J]. International Journal of Computational Intelligence Systems, 5(3):597-610.

[22]Just, M. A., amp; Carpenter, P. A. (1976). Eye Fixations and Cognitive Processes[J]. Cognitive Psychology, 8:441-480.

[23]Kharbech, S.," Dayoub, I., amp; Zwingelstein-Colin, M. (2016). On Classifiers for Blind Feature-Based Automatic Modulation Classification over Multiple-Input-Multiple-Output Channels[J]. IET Communications, 10(7):790-795.

[24]Liu, H. C. (2018). Investigating the Impact of Cognitive Style on Multimedia Learners’Understanding and Visual Search Patterns: An Eye-Tracking Approach[J]. Journal of Educational Computing Research, 55(8):1053-1068.

[25]Lou, Y., Liu, Y., amp; Kaakinen, J. K. et al. (2017). Using Support Vector Machines to Identify Literacy Skills: Evidence from Eye Movements[J]. Behavior Research Methods, 49(3):887-895.

[26]Mahvelati, E. H. (2020). Field-Dependent/Field-Independent Learners’Information Processing Behavior in an Implicit Learning Task: Evidence from Iranian EFL Learners[J]. Journal of" Psycholinguist Research, 49(6):955-973.

[27]Math?t, S., amp; Vilotijevi?, A. (2023). Methods in Cognitive Pupillometry: Design, Preprocessing, and Statistical Analysis[J]. Behavior Research Methods, 55:3055-3077 .

[28]McKay, M. T., Fischler, I., amp; Dunn, B. R. (2003). Cognitive Style and Recall of Text: An EEG Analysis[J]. Learning and Individual Differences, 14(1):1-21.

[29]Nisiforou, E. A., amp; Laghos, A. (2013). Do the Eyes Have It? Using Eye Tracking to Assess Students Cognitive Dimensions[J]. Educational Media International, 50(4):247-265.

[30]Nisiforou, E., amp; Laghos, A. (2016). Field Dependence-

Independence and Eye Movement Patterns: Investigating Users’ Differences Through an Eye Tracking Study[J]. Interacting with Computers, 28(4):407-420.

[31]Pradnya Sidhawara, A. G., Wibirama, S., amp; Adji, T. B. et al. (2020). Classification of Visual-Verbal Cognitive Style in Multimedia Learning using Eye-Tracking and Machine Learning[C]// 2020 6th International Conference on Science and Technology (ICST). Yogyakarta, Indonesia:1-5.

[32]Rayner, K., amp; Pollatsek, A. (1992). Eye-Movements and Scene Perception[J]. Canadian Journal of Psychology, 46(3):342-376.

[33]Riding, R., amp; Cheema, I. (1991). Cognitive Styles: An Overview and Integratio[J]. Educational Psychology, 11:193-215.

[34]Saracho, O. (2003). Matching Teachers’ and Students’ Cognitive Styles[J]. Early Child Development and Care, 173:161-173.

[35]Szulewski, A. M. D., Roth, N., amp; Howes, D. M. D. (2015). The Use of Task-Evoked Pupillary Response as an Objective Measure of Cognitive Load in Novices and Trained Physicians: A New Tool for the Assessment of Expertise[J]. Academic Medicine, 90(7):981-987.

[36]Witkin, H. A. (1967). A Cognitive-Style Approach to Cross-Cultural Research[J]. International Journal of Psychology, 2(4):233-250.

[37]Workman, M. (2004). Performance and Perceived Effectiveness in Computer-Based and Computer Aided Education: Do Cognitive Styles Make a Difference[J]. Computers in Human Behaviour, 20(4):517-534.

[38]Yousef, A. M. F.," Atia, A., amp;" Youssef, A. et al. (2021). Automatic Identification of Student’s Cognitive Style from Online Laboratory Experimentation Using Machine Learning Techniques[C]// 2021 IEEE 12th Annual Ubiquitous Computing, Electronics amp; Mobile Communication Conference (UEMCON). New York:143-149.

收稿日期 2023-12-14 責任編輯 汪燕

Construction of Cognitive Style Model Based on Machine Learning and Eye Tracking

XUE Yaofeng, ZHU Fangqing

Abstract: Cognitive style reflects the patterns of students’ approaching, acquiring, organizing, processing and interpreting information, and can be used to explain and guide students’ behavior. Integrating cognitive style into intelligent systems can help develop personalized user models and promote the development of intelligent education. Currently, there is a lack of research on automatic classification of cognitive styles, and machine learning has not yet been combined with eye tracking technology for application in this research field. Based on machine learning and eye tracking, a cognitive style model is built. It selects six eye movement indicators closely related to cognition, including fixation duration, number of fixations, saccade duration, number of saccades, saccade distance, and pupil diameter. After normalization, machine learning algorithms are used to automatically classify cognitive styles. The experimental results show that learners with different field cognitive styles exhibit different visual behavior patterns when learning from videos of the same duration. Field-dependent learners have a more dispersed fixation points, showing more saccades, fewer fixations, longer saccade distances, and larger pupil diameter changes, resulting in lower information search efficiency. Field-independent learners have a more intensive and directional visual attention pattern, resulting in higher information search efficiency. After comparing the performance of five machine learning algorithms, it is found that the classification effect of logistic regression algorithm is the best, with an accuracy rate of 89.01% and a Kappa value of 0.774. This automatic classification model of cognitive styles can be used for optimizing the design of course resources in intelligent learning systems and for recommending personalized learning paths. In the future, more physiological data can be integrated to improve the accuracy of data analysis and the reliability of learner cognitive ability assessment through information complementarity between different modalities.

Keywords: Intelligent Education; Machine Learning; Eye Tracking Technology; Field Cognitive Style; Automatic Classification