基于深度強化學習的基站動態開關研究

摘 要:隨著5G 移動互聯網的快速發展,為了滿足用戶不斷增長的流量需求,5G 基站大規模部署,導致能耗急劇增加。針對以上問題,通過采用流量預測與深度強化學習相結合的方法,建立基站動態開關模型。具體而言,該模型通過密集卷積神經網絡(Densely Connected Convolutional Networks,DenseNet)對基站流量進行預測;進一步地,基于精確的移動流量預測,將基站開關控制問題建模為一個馬爾科夫決策過程(Markov Decision Process,MDP),然后通過強化學習方法進行求解。此外,強化學習的reward 函數設計在優化基站開關成本時綜合考慮了多方面的因素,包括能耗和用戶服務質量(Quality of Service,QoS)下降成本,目標是在降低能耗的前提下,最小化長期的基站能量消耗。最終通過對真實數據集的大量實驗驗證,提出的模型與當前使用的基站常開策略相比,能夠節約37% 的能量消耗,且節能效果也優于傳統啟發式算法。

關鍵詞:基站;蜂窩網絡;動態開關;流量預測;深度Q 網絡

中圖分類號:TN92 文獻標志碼:A 開放科學(資源服務)標識碼(OSID):

文章編號:1003-3114(2024)04-0815-08

0 引言

隨著5G 移動互聯網的高速發展,移動流量呈現爆炸式增長,大規模基站部署和高負荷運行導致了大量的能源需求,進而引發了對能源效率和環境保護的迫切關注。在這樣的背景下,基站節能成為一項緊迫而重要的任務,需要尋找創新的解決方案,以平衡通信技術的發展與能源可持續利用之間的關系。然而,傳統的基站節能方案往往基于以往的經驗和靜態數據,無法充分利用網絡中歷史數據的特征和規律,也難以適應動態變化的通信負載和網絡環境。另外,現有的算法與策略大多建立在已知的規則或數學模型上,在實際應用中具有較大的局限性。然而,實際應用中,由于實際網絡環境的復雜性,使得對其進行精確建模變得十分困難。

為了解決上述問題,本文通過流量預測幫助基站更精準地預測通信流量負載,從而在開關決策中更好地平衡能源消耗和網絡性能,提高通信效率和用戶體驗。通過采用強化學習的方法來適應復雜的網絡環境,減少對問題的不必要假設。

本文的主要貢獻如下

① 針對蜂窩網絡的基站開關管理問題進行了全面的建模,將基站開關控制問題建模為一個馬爾科夫決策過程(Markov Decision Process,MDP),并采用深度Q 網絡(Deep Q-Network,DQN)算法求解該問題。

② 針對單智能體在面對高維度的動作空間時算法很難收斂,采用深度確定性策略梯度(Deep De-terministic Policy Gradient,DDPG)算法求解基站開關問題時又不利于動作的探索,很容易陷入局部最優的問題,使用多個并行的DQN(Multi-DQN)算法求解基站開關問題。該算法可以提高學習模型的收斂速度,增加探索動作空間和策略的多樣性。

③ 在強化學習的reward 函數設計中綜合考慮了蜂窩網絡的開銷問題,以相對更為準確地度量基站動態開關策略的優劣程度。其中,蜂窩網絡的總能耗是主要的開銷部分。此外,也考慮了由于基站開關狀態的切換帶來的開銷問題。

④ 使用北京市某區域的真實數據集進行了大量的實驗,提出的模型與當前廣泛使用的基站常開策略相比,能夠節約37% 的能量消耗,且節能效果也優于傳統啟發式算法。

1 相關研究

隨著5G 網絡的快速發展以及基站的大規模部署,基站的能源消耗已經成為一個重要的關注點,當前已經涌現了不少關于基站節能的相關研究。

文獻[1]基于白天和夜間移動網絡負荷的變化,在夜晚移動負載較低的時候,將一些不必要開啟的基站關掉,把連接的用戶轉移到其他基站。文獻[2]提出了一種基于集合覆蓋的基站動態關斷策略。文獻[3]則提出了基于頻譜效率的基站動態關斷策略。文獻[4]通過改進Affinity Propagation 聚類算法對基站日負荷曲線進行自適應聚類,并進一步挖掘分析周效應下的日潮汐現象和汐節能時段。

此外,目前已有不少研究通過建立基站休眠與資源分配的優化問題,使用啟發式算法迭代求解。文獻[5]基于最小化系統能耗和提高系統狀態穩定性,建立了雙目標優化問題,提出了求解雙目標優化問題的快速窮舉算法(Centralized Sleeping Schemefor a Fast Exhaustive Algorithm,CSS-E)和低復雜度的改進粒子群算法(Centralized Sleeping Scheme for aModified Particle Swarm Optimizationin,CSS-PSO)。文獻[6]則針對尋找休眠模式(Sleep Mode,SLM)下運行的最優的活躍基站集合的多目標優化問題,使用遺傳算法以實現快速收斂率并獲得最佳解決方案。

上述研究都是基于傳統的同構網絡的基站休眠技術。為應對日益增長的無線通信流量和用戶的高速率需求,引入多個小基站組成異構蜂窩網絡,以克服傳統同構網絡在容量和覆蓋方面的限制。文獻[7]研究了在一種多小基站共存的異構無線蜂窩網絡場景下,通過優化小型基站的傳輸功率和激活/停用(動態休眠)來研究電網能量最小化問題。文獻[8]研究了接入飛蜂窩網絡的能源效率問題,聯合優化毫微微基站的操作模式(如活躍或睡眠)以及用戶與活躍基站之間的關聯的方案。

上述研究都是基于集中式的方法,無法適應5G密集部署的場景下海量基站的動態關斷需求。在基站開關狀態切換過程中,為了降低由于切換帶來的通信開銷,有必要設計對分布式基站進行動態開關控制的算法。文獻[9]提出了一種提高綠色蜂窩網絡能源效率的分布式合作框架。文獻[10]研究了自適應小區縮放方案,應用博弈論優化小區縮放因子(Cell Zooming Factor,CZF)。

上述研究提到的博弈論等分布式方法在基站節能中可能存在一些局限性,如假設與實際網絡環境可能不符或最優策略具有不確定性。可以通過機器學習對實際業務量進行預測,進而制定針對性的基站休眠策略。文獻[11]提出了一種基于無線流量預測模型的智能數據驅動的基站休眠機制。文獻[12]提出一種基于深度強化學習的數據驅動基站休眠操作方法:Deepnap。文獻[13]采用深度強化學習方法對用戶分布、通信需求等進行自我學習,從而推測出基站的負載變化規律,進而對基站采取一系列節能措施。文獻[14]設計了一個基于基站狀態切換操作的強化學習框架方案。此外,為了加快訓練過程,提出了一種遷移參與者批評算法。文獻[15]提出了一種基于深度強化學習的基站休眠控制算法。

以上研究在基站節能方面都取得了一定的成果,本文在前期研究基礎上,構建基于流量預測與深度強化學習的基站動態開關模型。流量預測可以為未來時刻的基站開關決策提供有力的數據支撐,同時結合深度強化學習算法來求解基站動態開關問題,從而達到使基站的長期能耗最小的目的。

2 系統模型

本節將從網絡模型、基站成本模型等方面來描述基站成本問題。

2. 1 網絡模型

蜂窩網絡通常由多個基站組成來處理移動業務負載。本文考慮一個由一組基站服務用戶的蜂窩網絡,其中所述基站和用戶的集合可以分別表示為={1,2,…,N}, = {1,2,…,K}。在地理區域上,每個基站在各自的覆蓋范圍內(例如3×3 柵格),基站之間也可能存在重疊覆蓋問題。由于移動流量具有時變性,很多基站大部分時間都沒有得到充分的利用,造成了巨大的資源浪費和嚴重的能效問題。所以需要對基站的開關策略進行動態調整,以適應不同的流量需求。

本文的主要變量及其含義如表1 所示。

2. 2 基站成本模型

基站成本主要分為兩部分:能耗成本、用戶服務質量(Quality of Service,QoS)下降成本。

① 能耗成本。在蜂窩網絡中,基站的能耗不是簡單地與其覆蓋范圍內的流量負載成正比[16]。一般來說,基站的能耗可以總結為兩種:一種是固定的能量消耗,不依賴于基站的移動流量負載,主要來源于電路損耗和散熱損耗;另一種是與功率放大器等組件相關的傳輸能耗,與流量負載存在非線性關系。為此,本文提出了一種通用的能耗模型,一個基站在t 時刻一個小時內的能耗可以概括為[17]:

pti=Pfi+Pli, (1)

式中:Pfi為基站的固定能耗;Pli為基站的傳輸能耗,與流量負載成非線性相關。

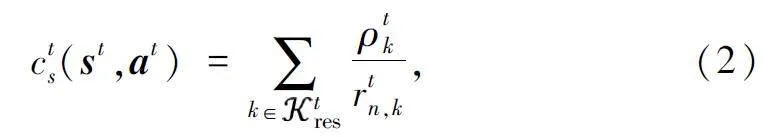

② QoS 下降成本。為了保證QoS,本文考慮了基站關斷可能導致用戶需要重新選擇基站進行連接的情況。該情況會降低QoS,產生用戶服務延遲的成本。本文將其定義為用戶進行基站重選后翻轉的流量與用戶重新連接到開啟狀態的基站的下行速率之比,具體表述為:

式中:小區重選后翻轉的用戶流量指重新選擇開啟狀態基站的用戶k(即更換所關聯基站的用戶)的流量,即ρtk; tres 表示在t 時刻基站重選的用戶集合,可以采用K-最近鄰(KNearest Neighbor,KNN)算法為失去基站連接的用戶搜索最近鄰的可連接基站得到;rtn,k 表示在t 時刻基站n 到用戶k 的下行速率,該速率可以用香農公式計算:

rtn,k =btn,k lb(1+SNRtn,k), (3)

式中:btn,k 表示在t 時刻基站n 分配給用戶k 的帶寬資源,SNRtn,k 表示在t 時刻基站n 到用戶k 的信噪比,SNRtn,k =ptn,khtn,k/N0,ptn,k 為基站n 分配給用戶k 的功率資源,htn,k 為基站n 與用戶k 之間的信道增益,N0為功率譜密度。

通過綜合考慮以上因素,本文的系統模型旨在實現多目標優化,即在最小化能耗的同時,確保用戶的通信服務質量得到保障。

3 基于流量預測的深度強化學習的基站動態開關算法

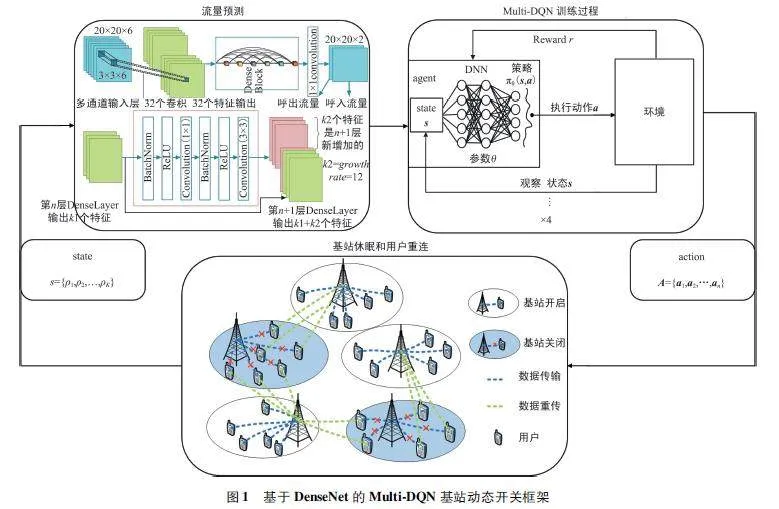

本節詳細介紹了基于密集卷積神經網絡(Densely Connected Convolutional Networks,DenseNet)的Multi-DQN 基站動態開關框架,并對流量預測、強化學習MDP 環境建模以及Multi-DQN 訓練過程分別展開了描述。

3. 1 基于DenseNet 的Multi-DQN 基站動態開關框架

系統框架由基站休眠與用戶重連模塊、流量預測模塊和Multi-DQN 訓練模塊三個模塊組成。該框架的工作流程描述如下。

① 基站休眠與用戶重新連接:當網絡負載較小時,為了降低能耗并提高網絡效率,一些基站可能會進入休眠狀態,減少不必要的能耗。此時用戶需要重新選擇基站進行連接,以獲得穩定的通信服務。

② DenseNet 模型預測流量:基于當前的基站開關狀態,本文利用DenseNet 模型,基于歷史流量數據預測基站在未來一段時間內的網絡流量情況得到預測結果。預測模型的輸出流量結果會被傳遞給強化學習模塊。

③ Multi-DQN 訓練:由于基站數量過多,單智能體在面對高維度的動作空間時,算法很難收斂;而且單個智能體在信息的獲取能力、處理能力、控制能力等方面有限,對于復雜的工作任務及多變的工作環境,單智能體能力明顯不足。如果采用DDPG 求解基站動態開關問題,由于初始策略通常固定,在探索高維度的連續動作空間時很有可能陷入局部最優解,無法跳出。因此,本文的強化學習模塊采用Multi-DQN 算法,該算法中多個DQN 并行訓練可以同時學習,模型訓練速度得到大幅度提升;而且多個DQN 代理(agent)可以獨立地探索不同的策略和動作選擇,進一步增加了探索的多樣性。這樣有助于避免陷入局部最優解,提高代理找到全局最優策略的概率。

該強化學習模塊基于基站流量負載變化、用戶體驗指標(如速率、時延),旨在自主學習得到最優的基站動態開關策略。

④ 動態基站開關策略生成:經過訓練,Multi-DQN 將產生一個動態的基站開關策略。代理可以根據當前的網絡環境和狀態,自主地選擇基站的開關狀態,從而進一步提升網絡性能和用戶體驗。

上述內容的具體細節如圖1 所示。綜上所述,移動通信網絡能夠在基站休眠與用戶重新連接的過程中,通過流量預測和強化學習等方法的協同作用,實現基站開關策略的智能優化。這一框架不僅有助于提升網絡效率和性能,也為用戶提供了更穩定和流暢的通信體驗。

3. 2 流量預測

本文的流量預測模型DenseNet 用滑動窗口的方式對數據集進行抽取,由于所選用數據集可以看作二維空間的流量分布隨時間的變化,具有視頻流的特征,因此針對影響三種時間依賴性的歷史數據采用不同長度的幀數來采集構建,并分為三部分輸入到不同的分模塊中進行訓練,從而捕捉三種時間依賴性。輸入數據前先經過Min-Max 歸一化處理,以提高模型訓練時的收斂速度。進入分模塊后經過主要由堆疊的DenseLayer 組成的DenseUnit 來進行空間依賴的捕捉,并將分模塊學習的特征通過參數矩陣融合的方式結合起來。

流量的周期性、臨近性、趨勢性等特征會對最后的預測結果產生不同的影響。本文通過參數矩陣的融合,將不同時間特征的強度體現在不同權重上,并將其分別表示為Wp1、Wp2、Wc 和Wt。在訓練階段,將學習參數轉化為與輸入的特征形式相同的張量,這樣就可以進一步做哈達瑪的乘法運算,從而可以獲得矩陣融合的輸出,即時空模塊的輸出。記為XT [18]:

XT =Wp1 。X7p1 +Wp2 。X7p2 +Wc 。X7c+Wt 。X7t, (4)

式中:表示哈達瑪乘積,將學習參數矩陣與特征輸出矩陣的位置一一對應然后分別相乘,最后將三個特征相加,從而獲得預測特征的結果。經過神經網絡的迭代訓練,不斷計算梯度和更新權重,最后得出模型t 時刻的預測輸出:

︿Yt =σ XT, (5)

式中:σ(·)表示Sigmoid 激活函數。從預測值和真實值的對比結果來看,可以通過均方根誤差(RootMean Square Error,RMSE)表達該損失函數,并在訓練期間對該模型進行參數更新:

L(μ)=|| Yt -Yt︿|| 2, (6)

式中:μ 表示一組可以使得模型最終訓練得到的損失函數取最小值的參數,Yt 表示真實值,當損耗函數取最小值時,加權參數也分別對應最優值。

3. 3 強化學習MDP 環境建模

本文的主要研究目標是找到最優的基站開關策略,以最大限度降低系統的長期總成本。將基站成本優化問題建模為一個MDP,并將其表示為一個元組M=〈S,A ,R ,S′,γ〉。其中,S為狀態空間,A 為動作空間,R 為獎勵函數,S′為下一時刻的狀態,γ∈[0,1]為折扣因子。MDP 的設計過程按以下步驟進行:

① 狀態(state):系統狀態是由在當前時刻t 所有用戶的流量負載ρtk 組成。但是,當基站要進行活躍/睡眠模式操作時,在時段t 開始時,流量ρtk 不可用。因此,利用流量預測模型訓練得到的預測結果ρtk ~,將狀態表示為st ={ρtk ~}。

② 動作(action):動作at 是決定所有基站在t時刻的工作模式,其中:

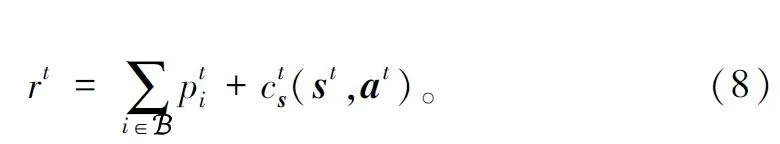

③ 獎勵函數(Reward):為了評估當前的基站開關策略,將在狀態s 下采取動作a 獲得的瞬時獎勵作為判斷依據。系統在一個小時內的獎勵由所有基站的能耗和用戶QoS 下降成本組成。獎勵函數如式(8)所示:

3. 4 Multi-DQN 訓練過程

為了提高強化學習模型的訓練速度,進一步提升基站動態開關模型的性能,采用Multi-DQN 算法求解基站動態開關問題。完整的Multi-DQN 訓練過程如算法1 所示。

在每一步訓練過程中,蜂窩網絡都會向Q 網絡發送當前所有用戶的移動流量狀態。由此,得到在該狀態下的全部基站進行開關切換所對應的Q 值。算法第6 行說明多個DQN 在并行訓練;第7 行~15 行是基于ε-greedy 算法對單個DQN 進行判定的步驟。具體來說就是,當隨機數小于ε 時,會隨機生成一個[0,1]的數字。假設該數值小于ε,該步驟將采取具有最大Q 值的動作進行操作,否則將隨機采取一個動作。基站開關狀態發生變化以后,蜂窩網絡將基于能耗、QoS 下降成本的獎勵反饋給DQN 代理,并進入到新的狀態,產生一條數據保存到經驗回放緩沖區。在該算法中,第11 行~13 行為DQN 的Q網絡參數更新過程,它通過對少量采樣數據的丟失進行計算,并通過梯度下降來調節神經網絡的參數θ。第14 行為Q 目標網絡和Q 網絡的神經網絡的參數以C 為間隔進行同步的過程。

4 模型性能分析

本節主要包括三部分:數據集描述、參數設置及實驗環境、模型性能。

4. 1 數據集描述

本文所用數據為某區域4G 流量數據,對每小時空口總流量(單位為GB)進行分析處理。數據集分為兩部分,其中2021 年11 月19 日—2021 年12 月18 日每小時測得的數據(共720 條)為訓練集,2021 年12 月19 日每小時測得的數據(共24 條)為測試集。

4. 2 參數設置及實驗環境

本文首先將3×3 個柵格劃分為一個區域,整個區域被分為4 個子區域,每個子區域都有一個DQN代理獨立地控制基站的開關狀態。然后,將每個柵格劃分為100 個50 m×50 m 的小柵格。本文采用KNN 算法將每個小柵格關聯到距離最近的基站,以小時為單位,將基站流量均分到所有關聯的小柵格。最后統計每個柵格所有小柵格的流量和,作為該柵格的流量。

實驗環境的硬件配置為:Intel(R)Core(TM)i9-10940X CPU @ 3. 30 GHz,GPU RTX3090,24 GB 顯存;軟件配置為:Python3. 8,pytorch2. 0. 1+CUDA11. 7CUDNN 8. 2. 4;CPU 內存128 GB。

4. 3 模型性能

本小節主要分為流量預測和強化學習兩部分。

4. 3. 1 流量預測性能

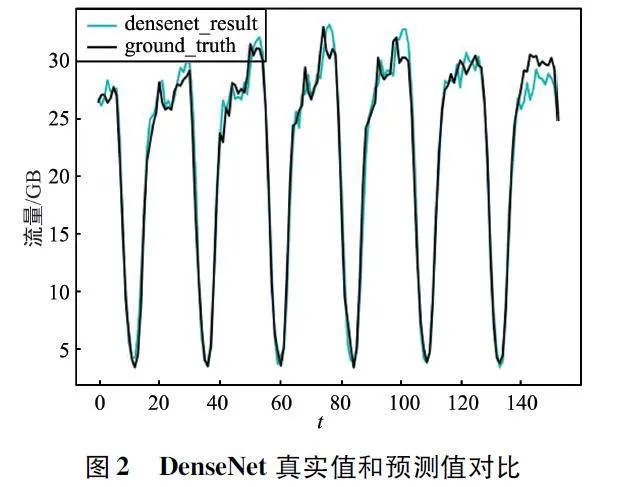

① 基于DenseNet 的基站流量預測值和真實值對比(某一個區域29 個基站下平均效果)如圖2 所示,可以看出,DenseNet 模型在整體預測性能上表現良好,但是,在網絡流量高峰時刻,模型的預測結果(densenet_result)出現了一些與真實值(ground_truth)略微不一致的情況。這可能是由于模型在高峰時刻的數據特性、復雜性或非線性動態變化方面存在一定的挑戰,導致預測精度在此時段稍有波動。

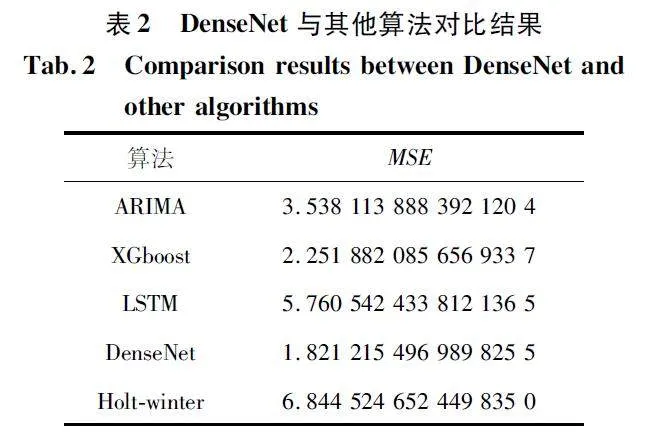

② 某一個區域29 個基站下平均預測效果DenseNet 與其他算法對比結果如表2 所示。此次實驗以均方誤差(Mean Square Error,MSE)作為評價指標。實驗結果表明,Holt-winter 模型[19]得到的MSE為6. 844 5,表現最差;其次是LSTM[20]和ARIMA[21]模型,MSE 分別為5. 760 5 和3. 538 1;而XGBoost[22]模型和DenseNet 模型的表現最好,其中DenseNet 模型以1. 821 2 的MSE 表現最為出色,XGboost 模型的MSE 為2. 251 8,表現次之。

在此次實驗中,XGBoost 和DenseNet 在流量預測任務中具有較好的性能,可能的原因在于這兩種模型均具有較強的特征學習和抽象能力,能夠有效地捕捉到數據中的復雜模式和關聯關系。與之相比,ARIMA 和Holt-winters 是傳統的時間序列模型,通常對于復雜的時間序列模式表現較差。

4. 3. 2 強化學習性能

① 本文選取了市區內高校區、居民區和商業區三個區域作為實驗場景,模型訓練結果曲線如圖3所示。三個不同的區域都隨著訓練輪次的增加,模型收斂至穩定。其中,居民區的收斂趨勢最快,在第150 輪次就逐漸開始收斂。由于居民區相對于高校區和商業區來說,網絡環境通常更簡單,具有較低的復雜性。這種低復雜性使得強化學習智能體更容易學習和優化基站的開關策略,因此,學習模型的收斂速度相對而言會更快。

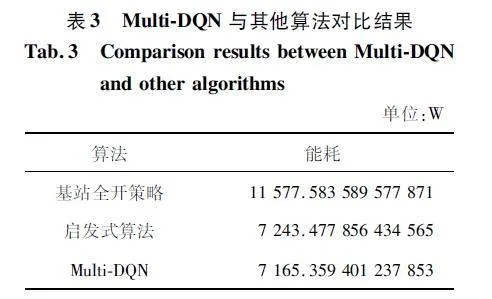

② Multi-DQN 與其他算法在某一個區域29 個基站的平均節能效果對比結果如表3 所示。

從對比結果來看,與啟發式算法和Multi-DQN算法相比,基站全開策略最不理想,能耗最大,大約為11 578 W;啟發式算法與Multi-DQN 算法的能耗結果分別為7 243 W 和7 165 W,因此,Multi-DQN算法比啟發式算法節能效果更好。Multi-DQN 相對于啟發式算法在節能方面的優勢在于其能夠進行全局優化,具有自適應性和學習能力;同時,其并行化訓練和廣泛的策略空間探索使其能夠更有效地發現并優化節能策略,為復雜的節能問題提供了更為有效的解決方案。而啟發式算法通常以簡單規則或既往經驗為基礎,性能受限于搜索空間的局部最優解問題,可能無法提供足夠準確的解決方案,尤其在復雜、不確定性高的情況下,算法表現可能不穩定且難以調優。

總的來說,Multi-DQN 算法相對基站全開策略和啟發式算法而言,效果比較好。該算法與當前使用的基站常開策略相比,能夠節約37% 的能量消耗,且優于傳統啟發式算法。

5 結束語

本文提出了一種基于流量預測的Multi-DQN 基站動態開關模型,用于蜂窩網絡的節能。利用DenseNet 預測移動流量,而后,基于精確的移動流量預測,將基站開關控制問題建模為一個MDP 過程,以考慮用戶QoS 下降成本來最小化長期的能量消耗。為了解決MDP 問題,本文采用了Multi-DQN深度強化學習方法求解。最后,通過對真實區域數據集的大量實驗,證明了所提模型的有效性。本文的主要研究目標在于通過一系列的創新性工作,降低基站的能源消耗,以實現通信基站節能的目標。

參考文獻

[1] MARSAN M A,CHIARAVIGLIO L,CIULLO D,et al. Optimal Energy Savings in Cellular Access Networks[C]∥2009 IEEE International Conference on CommunicationsWorkshops. Dresden:IEEE,2009:1-5.

[2] BEITELMAL T,YANIKOMEROGLU H. A Set CoverBased Algorithm for Cell Switchoff with Different CellSorting Criteria[C]∥2014 IEEE International Conferenceon Communications Workshops (ICC). Sydney:IEEE,2014:641-646.

[3] GONG J,ZHOU S,YANG Z X,et al. Green MobileAccess Network with Dynamic Base Station Energy Saving[J]. Ice Technical Report Internet Architecture,2009,109(262):25-29.

[4] 鄭佳歡,向勇. 基于個性化場景的5G 基站節能方法[J]. 移動通信,2021,45(3):91-96.

[5] LIU C,WAN Y,TIAN L,et al. Base Station SleepingControl with Energystability Tradeoff in Centralized RadioAccess Networks[C]∥2015 IEEE Global CommunicationsConference(GLOBECOM). San Diego:IEEE,2015:1-6.

[6] CHANDHAR P,DAS S S. Energy Saving in OFDMA Cellular Networks with Multiobjective Optimization [C]∥2014 IEEE International Conference on Communications(ICC). Sydney:IEEE,2014:3951-3956.

[7] ALQASIR A M,KAMAL A E. Cooperative Small CellHetNets with Dynamic Sleeping and Energy Harvesting[J]. IEEE Transactions on Green Communications andNetworking,2020,4(3):774-782.

[8] KIM J,JEON W S,JEONG D G. Basestation Sleep Management in Openaccess Femtocell Networks[J]. IEEE Transactions on Vehicular Technology,2016,65(5):3786-3791.

[9] ZHENG J C,CAI Y M,CHEN X F,et al. Optimal BaseStation Sleeping in Green Cellular Networks:A DistributedCooperative Framework Based on Game Theory[J]. IEEETransactions on Wireless Communications,2015,14(8):4391-4406.

[10]XU X D,YUAN C J,CHEN W W,et al. Adaptive Cell Zooming and Sleeping for Green Heterogeneous UltradenseNetworks[J]. IEEE Transactions on Vehicular Technology,2018,67(2):1612-1621.

[11]LIN J S,CHEN Y J,ZHENG H F,et al. A DatadrivenBase Station Sleeping Strategy Based on Traffic Prediction[J/ OL]. IEEE Transactions on Network Science and Engineering(2021-09-02)[2024-02-10]. https:∥ieeexplore. ieee. org/ document/9528008.

[12]LIU J C,KRISHNAMACHARI B,ZHOU S,et al.DeepNap:Datadriven Base Station Sleeping OperationsThrough Deep Reinforcement Learning[J]. IEEE Internetof Things Journal,2018,5(6):4273-4282.

[13]曾德澤,李躍鵬,趙宇陽,等. 基于強化學習的高能效基站動態調度方法[J]. 計算機科學,2021,48(11):363-371.

[14]LI R P,ZHAO Z F,CHEN X F,et al. TACT:A TransferActorcritic Learning Framework for Energy Saving in Cellular Radio Access Networks[J]. IEEE Transactions onWireless Communications,2014,13(4):2000-2011.

[15]楊馥瑜,趙東. 基于深度強化學習的基站休眠控制算法[EB/ OL]. (2015-02-10)[2024-02-10]. https:∥www. paper. edu. cn/ releasepaper/ content/202302-58.

[16]LI R P,ZHAO Z F,WEI Y,et al. GMPAB:A GridbasedEnergy Saving Scheme with Predicted Traffic Load Guidance for Cellular Networks[C]∥2012 IEEE InternationalConference on Communications (ICC). Ottawa:IEEE,2012:1160-1164.

[17]WU Q,CHEN X,ZHOU Z,et al. Deep ReinforcementLearning with Spatiotemporal Traffic Forecasting forDatadriven Base Station Sleep Control[J]. IEEE/ ACMTransactions on Networking,2021,29(2):935-948.

[18]馬冀,林尚靜,李月穎,等. 多源跨域數據融合的無線通信網絡流量預測[J]. 計算機科學,2022,49(增刊2):893-899.

[19]CHATFIELD C. The Holtwinters Forecasting Procedure[J]. Journal of the Royal Statistical Society Series C:Applied Statistics,1978,27(3):264-279.

[20]DENG C,ZHU C. Shortterm Traffic Velocity PredictionBased on LSTM Neural Networks[C]∥2023 IEEE 6thInternational Conference on Knowledge Innovation andInvention (ICKII). Sapporo:IEEE,2023:634-638.

[21]DENG L J,RUAN K,CHEN X,et al. An IP NetworkTraffic Prediction Method Based on ARIMA andNBEATS[C]∥2022 IEEE 4th International Conferenceon Power,Intelligent Computing and Systems (ICPICS).Shenyang:IEEE,2022:336-341.

[22]BOSE S,GAYNAR K,SINGH S P. Breast CancerDetection by Data Visualization and Feature SelectionUsing XG Boost Algorithm[C]∥2022 International Conference on Signal and Information Processing (IConSIP).Pune:IEEE,2022:1-6.

作者簡介:

王 瑜 男,(1983—),碩士,高級工程師。主要研究方向:無線移動網、物聯網、人工智能、網絡創新支撐等。

范燕琳 女,(1991—),博士,工程師。主要研究方向:網絡智慧運營、網絡運維數字化轉型。

孫洋洋 男,(1990—),碩士,工程師。主要研究方向:網絡運維數字化轉型。

熊建勝 男,(1989—),碩士,工程師。主要研究方向:智能運維人工智能算法。

蔣 濤 男,(1993—),工程師。主要研究方向:基站機房節能。

周 瑩 女,(1988—),碩士,工程師。主要研究方向:網絡智慧運營、人工智能。

韓志博 女,(2000—),碩士研究生。主要研究方向:無線通信。

李子怡 女,(2000—),碩士研究生。主要研究方向:無線通信。

王振乾 男,(1999—),博士研究生。主要研究方向:大數據、人工智能算法。

基金項目:2023 年中國聯通智網創新中心基于AI 的基站與接入機房節能算法模型研究及應用研發項目